Введение в согласование подобного-мозгу СИИ

Примечание переводчика: цепочка Стивена Бирнса «Intro to Brain-Like-AGI Safety», выкладывалась на leswrong,com с января по май 2022 года.

Предположим, мы когда-нибудь создадим алгоритм Сильного Искусственного Интеллекта с использованием принципов обучения и мышления, схожими с теми, что использует человеческий мозг. Как мы могли бы безопасно использовать такой алгоритм?

Я утверждаю, что это – открытая техническая задача, и моя цель в этой цепочке постов – довести не обладающих предшествующими знаниями читателей вплотную до переднего края нерешённых задач, как я его вижу.

Если вся эта тема кажется странной или глупой, вам стоит начать с Поста №1, который содержит определения, контекст и мотивацию. Затем Посты №2-№7 – это в основном нейробиология, а Посты №8-№15 более напрямую касаются безопасности СИИ, и заканчивается всё списком открытых вопросов и советами по тому, как включиться в эту область исследований.

1. В чём проблема и почему работать над ней сейчас?

- 1.1.1 Краткое содержание / Оглавление

- 2.1.2 Техническая задача безопасности СИИ

- 3.1.3 Подобный-мозгу СИИ

- 4.1.4 Что конкретно такое «СИИ»?

- 5.1.5 Какова вероятность, что мы однажды придём к подобному-мозгу СИИ?

- 6.1.6 Почему происшествия с СИИ – настолько серьёзное дело?

- 7.1.7 Почему думать о безопасности СИИ сейчас? Почему не подождать, пока мы не приблизимся к СИИ и не узнаем больше?

- 8.1.8 …А ещё это по-настоящему восхитительная задача!

1.1 Краткое содержание / Оглавление

Это первый из серии постов о технической задаче безопасности гипотетических будущих подобных-мозгу систем Сильного Искусственного Интеллекта (СИИ). Так что мой приоритет тут – сказать, что, чёрт побери, такое «техническая задача безопасности подобных-мозгу СИИ», что эти слова вообще значит, и с чего мне вообще беспокоиться.

Краткое содержание этого первого поста:

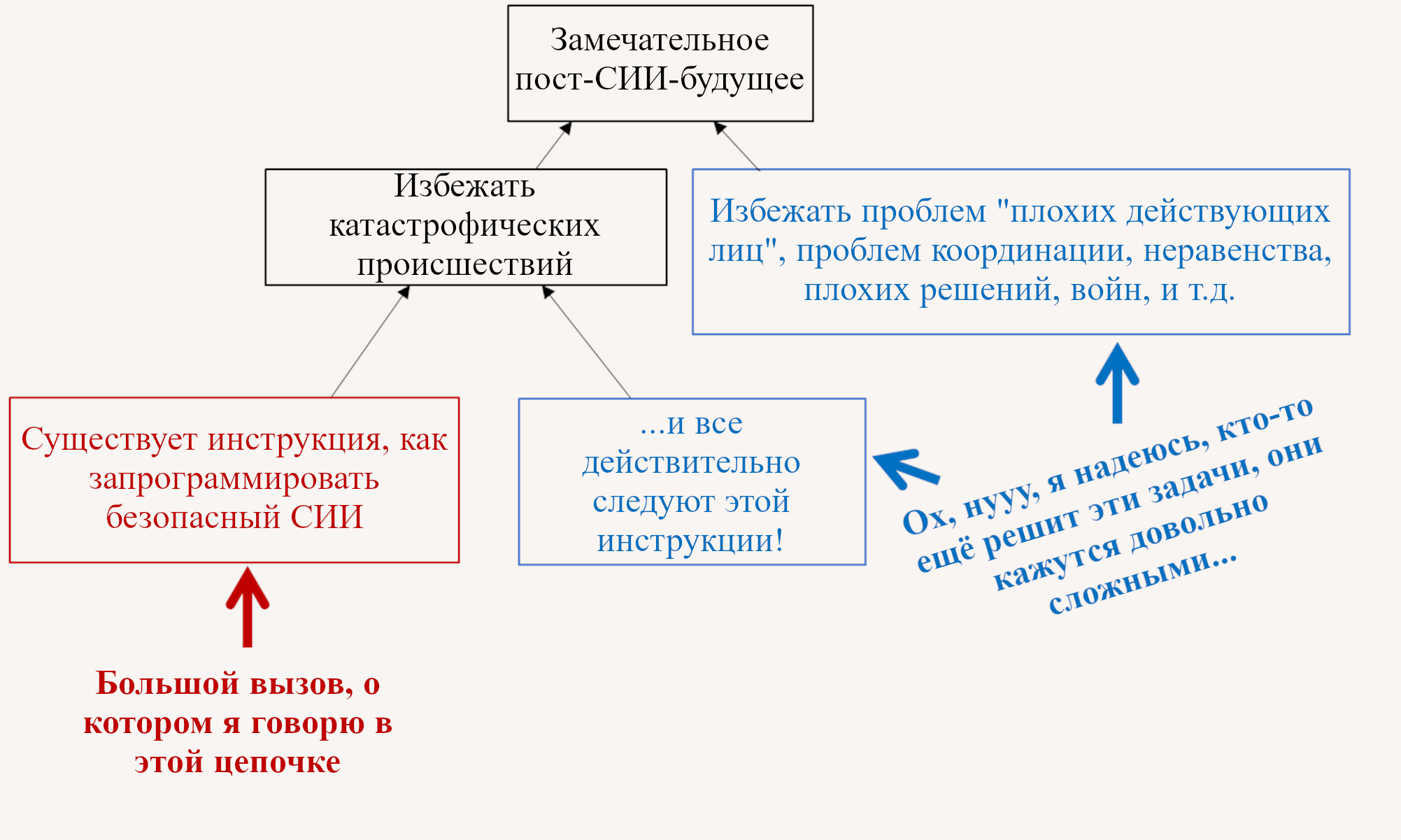

- В Разделе 1.2 я определяю «техническую задачу безопасности СИИ», помещаю её в контекст других видов исследования безопасности (например, изобретения пассивно-безопасных проектов атомных электростанций), и связываю её с большой картиной того, что необходимо, чтобы реализовать потенциальные выгоды СИИ для человечества.

- В Разделе 1.3 я определяю «подобные мозгу СИИ» как алгоритмы, имеющие на высоком уровне сходства с ключевыми чертами человеческого интеллекта, предположительно (хоть и не обязательно) в результате того, что будущие люди проведут реверс-инжиниринг этих аспектов человеческого мозга. Что в точности это значит будет яснее понятно из следующих постов. Я также упомяну контринтуитивную идею о том, что «подобный-мозгу СИИ» может (и, вероятно, будет) иметь радикально нечеловеческие мотивации. Я не объясню это полностью здесь, но вернусь к этой теме в конце Поста №3.

- В Разделе 1.4 я определю термин «СИИ», как он будет использоваться в этой цепочке.

- В Разделе 1.5 я рассмотрю вероятность того, что люди однажды создадут подобные мозгу СИИ, в противоположность каким-то другим видам СИИ (или просто не появлению СИИ вообще). Раздел включает семь популярных мнений по этому поводу, как от нейробиологов, так и от экспертов в ИИ / машинном обучении, и мои на них ответы.

- В Разделе 1.6 я рассмотрю происшествия с СИИ, которые стоит ожидать, если мы не решим техническую задачу безопасности СИИ. Я приведу аргументы в пользу того, что такие происшествия действительно могут быть катастрофическими, в том числе приводящими к вымиранию людей. Эта тема просто минное поле замешательства и проблем коммуникации, и я построю свой обсуждение вокруг ответов на восемь частых возражений.

- В Разделе 1.7 я рассмотрю более конкретный вопрос того, почему на следует думать о безопасности СИИ прямо сейчас. Всё же, с первого взгляда кажется, что есть хорошие поводы подождать, конкретно: (1) СИИ пока не существует, (2) СИИ будет существовать когда-нибудь в будущем, и (3) исследования безопасности СИИ будут проще, когда мы будем больше о нём знать и действительно иметь код СИИ для проведения тестов. В этом аргументе действительно что-то есть, но я считаю, что всё же очень много работы по безопасности можно и нужно сделать как можно скорее.

- В Разделе 1.8 я обосную, что безопасность подобного-мозгу СИИ - это увлекательная, восхитительная и перспективная тема, даже если вы не принимаете идею, что она важна для будущего.

1.2 Техническая задача безопасности СИИ

СИИ – сокращение для «Сильного Искусственного Интеллекта» – я рассмотрю его определение ниже в Разделе 1.4. СИИ сейчас не существует, но в Разделе 1.7 я обосную, что мы можем и нам следует готовиться к появлению СИИ уже сегодня.

Часть, о которой я буду говорить в этой цепочке – это красный прямоугольник тут:

Конкретнее, мы будем представлять одну команду людей, пытающихся создать один СИИ, и стремиться, чтобы для них было возможным сделать это не вызвав какую-нибудь катастрофу, которую никто не хочет, с вышедшим из под контроля СИИ, самовоспроизводящимся через Интернет, или чем-то ещё (больше про это в Разделе 1.6).

Синие прямоугольники на диаграмме – это то, о чём я не буду говорить в этой цепочке. На самом деле, я вообще над ними не работаю – мне и так уже достаточно. Но я очень сильно одобряю, что над ними работают другие люди. Если ты, дорогой читатель, хочешь работать над ними, удачи тебе! Я болею за тебя! И вот несколько ссылок, чтобы начать: 1, 2, 3, 4, 5, 6, 7.

Возвращаясь к красному прямоугольнику. Это техническая задача, требующая технического решения. Никто не хочет катастрофических происшествий. И всё же катастрофы случаются! В самом деле, для людей совершенно возможно написать алгоритм, который делает что-то, что никто от него не хотел. Это происходит всё время! Мы можем назвать это «багом», когда это локальная проблема в коде, и мы можем назвать это «фундаментально порочным дизайном софта», когда это глобальная проблема. Позднее в цепочке я буду отстаивать позицию, что код СИИ может быть необычайно склонен к катастрофическим происшествиям, и что ставки очень высоки (см. Раздел 1.6 ниже и Пост №10).

Вот аналогия. Если вы строите атомную электростанцию, то никто не хочет вышедшей из-под контроля цепной реакции. Люди в Чернобыле точно не хотели! Но это всё равно произошло! Я извлекаю из этой аналогии несколько уроков:

- Энрико Ферми изобрёл техническое решение для контроля атомных цепных реакций – аварийные регулирующие кассеты – до создания первой атомной цепной реакции. Правильно!! Вот это значит делать вещи в нужном порядке! По той же причине, я считаю, что нам следует стремиться иметь техническое решение для избегания катастрофических происшествий с СИИ наготове до того, как начинать программировать СИИ. На самом деле, я ниже буду отстаивать даже более сильное утверждение: знать (хотя бы в общих чертах) решение за 10 лет до СИИ ещё лучше; за 20 лет до СИИ – ещё лучше; и т.д. и т.д. Это заявление неочевидно, но я к нему ещё вернусь (Раздел 1.7).

- Технические решения – это не всё-или-ничего. Некоторые снижают риск происшествий, не избавляясь от него полностью. Некоторые сложны и дороги, и подвершены ошибкам при реализации. В случае атомных реакций, аварийные регулирующие кассеты сильно снижают риск происшествий, но пассивно-безопасные реакторы снижают его ещё сильнее. Аналогично, я ожидаю, что техническая безопасность СИИ будет большой областью, в которой мы будем со временем разрабатывать всё более хорошие подходы, используя множество техник и множество слоёв защиты. По крайней мере, я надеюсь! Дальше в цепочке я заявлю, что прямо сейчас у нас нет никакого решения – даже примерного. У нас полно работы!

- Синие прямоугольники (см. диаграмму выше) тоже существуют, и они совершенно необходимы, хоть и находятся за пределами рассмотрения этой конкретной серии статей. Причиной Чернобыля было не то, что никто не знал, как контролировать цепную атомную реакцию, а то, что лучшим практикам не следовали. В таком случае, мы все в пролёте! Всё же, хоть техническая сторона не может сама по себе решить проблему невыполнения, мы можем несколько с ней помочь, разрабатывая лучшие практики минимально дорогими и с максимальной защитой от дурака.

В *Ученике Чародея*, если я правильно его помню, программный инженер Микки Маус программирует СИИ с метлоподобным роботизированным телом. СИИ делает в точности то, что Микки *запрограммировал* его делать («наполнить ведро водой»), но это оказалось сильно отличающимся от того, что Микки от него *хотел* («наполнить ведро водой, не устроив беспорядок и не делая чего-то ещё, что я бы счёл проблематичным, и т.д.»). Наша цель – дать программным инженерам вроде Микки *возможность* избегать подобных инцидентов, снабдив их необходимыми для этого инструментами и знаниями. См. эту лекцию Нейта Соареса для глубокого обзора того, почему перед Микки ещё полно работы.

1.3 Подобный-мозгу СИИ

1.3.1 Обзор

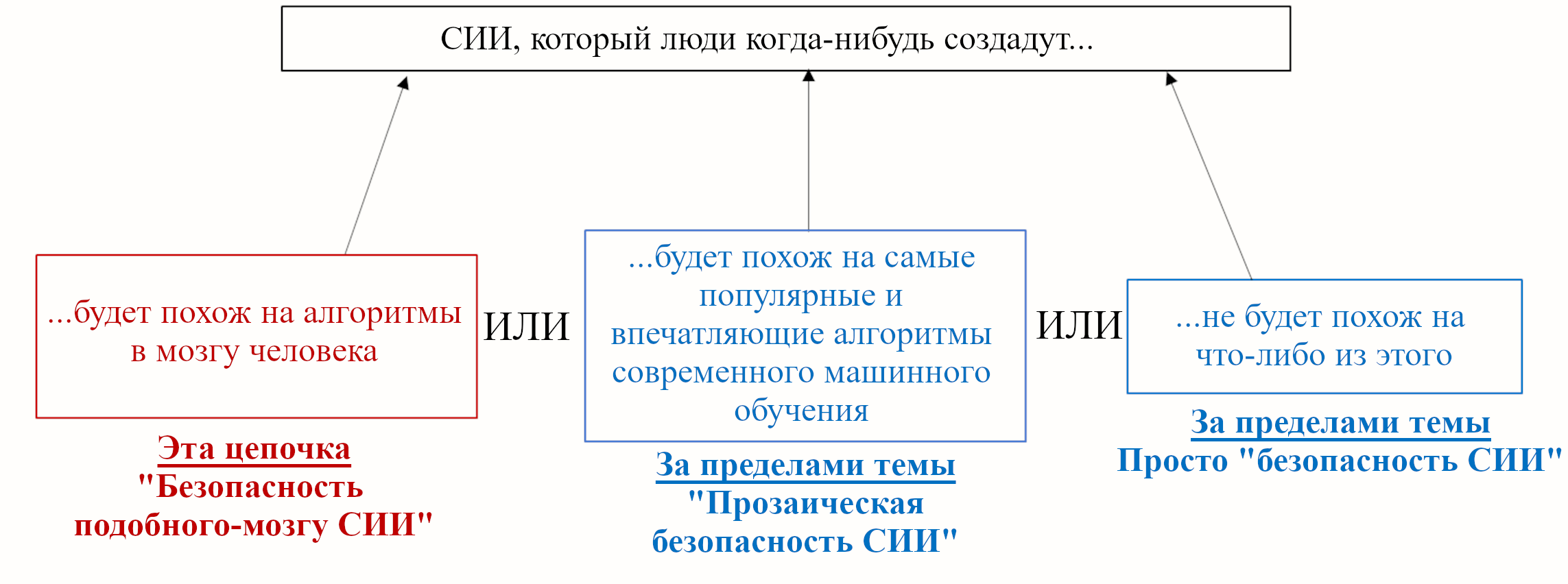

Эта цепочка фокусируется на конкретном сценарии того, как будут выглядеть алгоритмы СИИ:

Красный прямоугольник – то, о чём я говорю тут. Синие прямоугольники находятся за пределами рассмотрения данной цепочки.

У вас может быть своё мнение о том, какие из этих категорий более или менее вероятны, или даже невозможны, или вообще имеет ли это разделение смысл. У меня оно тоже есть! Я опишу его позже (Раздел 1.5). Но его основа – что все три варианта в достаточной степени вероятны, чтобы нам следовало к ним готовиться. Так что хоть я лично и не делаю много работы в этих синих прямоугольниках, я уж точно рад, что это делают другие!

Вот аналогия. Если бы кто-то в 1870 пытался бы догадаться, как будет выглядеть будущий человеческий полёт…

- «Что-то вроде птиц» было бы осмысленным предположением…

- «Что-то вроде лучших нынешних летательных аппаратов» было бы тоже осмысленным предположением…

- «Ни то, ни другое» было бы ещё одним осмысленным предположением!!

В этом конкретном воображаемом случае, все три предположения оказались бы частично верны, а частично ошибочны: братья Райт активно напрямую вдохновлялись большими парящими птицами, но отбросили махание крыльями. Они также использовали некоторые компоненты уже существовавших аппаратов (например, пропеллеры), но и прилично своих оригинальных деталей. Это всего один пример, но мне кажется, что он убедительный.

1.3.2 Что в точности такое «подобный-мозгу СИИ»?

Когда я говорю «подобный-мозгу СИИ», я имею в виду нечто конкретное. Это станет яснее в следующих постах, после того, как мы начнём погружаться в нейробиологию. Но вот, в общих чертах, о чём я:

Есть некоторые составляющие в человеческом мозгу и его окружении, которые приводят к тому, что у людей есть обобщённый интеллект (например, здравый смысл, способность что-то понимать, и т.д. – см. Раздел 1.4 ниже). В представляемом мной сценарии исследователи выясняют, что это за составляющие и как они работают, а потом пишут код ИИ, основываясь на этих же ключевых составляющих.

Для прояснения:

- Я не ожидаю, что «подобный мозгу СИИ» будет включать каждую часть мозга и его окружения. К примеру, есть высокоинтеллектуальные люди, рождённые без чувства запаха, из чего можно сделать вывод, что цепи обработки ольфакторной информации не необходимы для СИИ. Есть и высокоинтеллектуальные парализованные с рождения люди, так что большинство спинного мозга и некоторые аспекты ощущения тела тоже не необходимы. Есть люди, рождённые без мозжечка, несмотря на это вполне попадающие в диапазон нормального интеллекта взрослого человека (способные работать, независимо жить и т.д. – способности, которые мы бы без сомнений назвали бы «СИИ»). Другие взрослые ходят на работу, будучи лишёнными целого полушария мозга, и т.д. Моё ожидание по умолчанию – что СИИ будет создан людьми, пытающимися создать СИИ, и они отбросят столько компонентов, сколько возможно, чтобы сделать свою работу проще. (Я не утверждаю, что это обязательно хорошая идея, только что этого я ожидаю по умолчанию. Подробнее об этом в Посте №3.)

- В частности, «подобный мозгу СИИ», о котором я говорю – это точно не тоже самое, что Полная Эмуляция Мозга.

- Я не требую, чтобы «подобный-мозгу СИИ» напоминал человеческий мозг в низкоуровневых деталях, вроде импульсных нейронов, дендритов, и т.д., или их прямых симуляций. Если сходство есть только на высоком уровне, хорошо, это тут ни на что не повлияет.

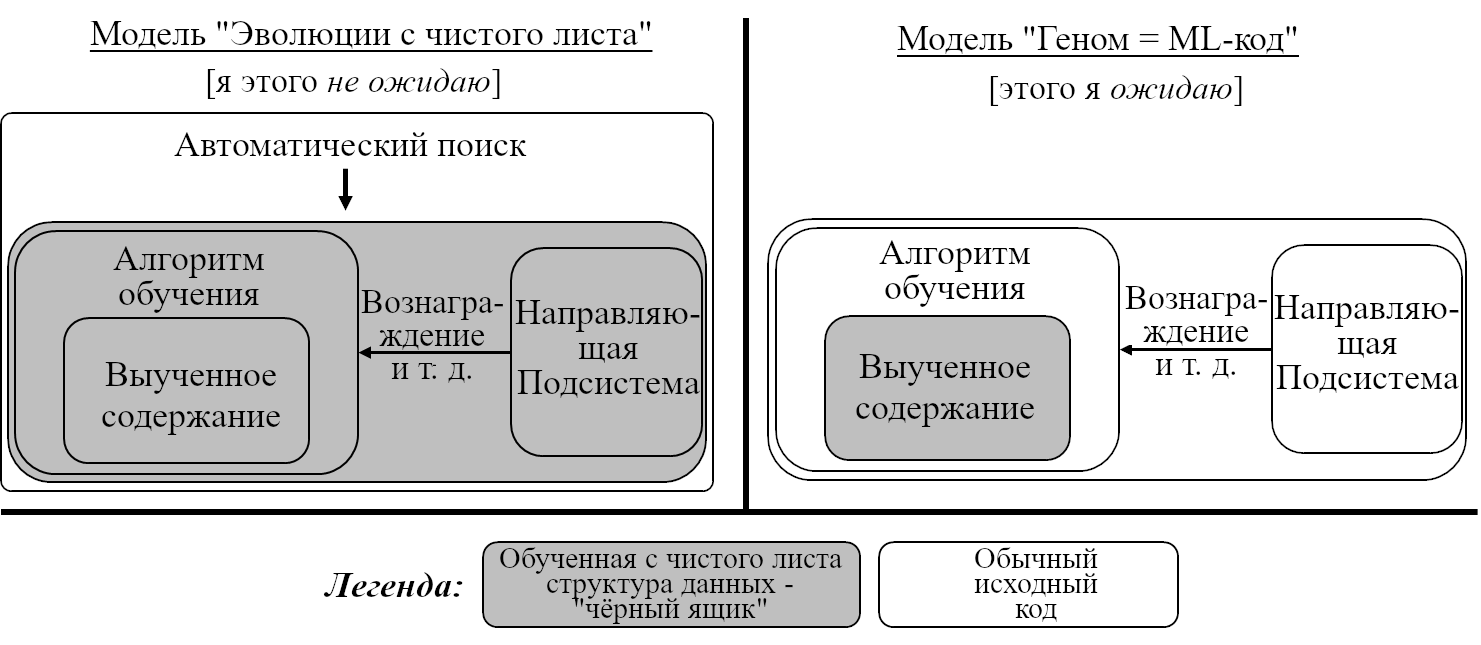

- Я не требую, чтобы «подобный мозгу СИИ» был изобретён процессом реверс-инжиниринга мозга. Если исследователи ИИ независимо переизобретут схожие с исполняемыми в мозгу алгоритмами – просто потому, что это хорошие идеи – что ж, я всё ещё буду считать результат подобным-мозгу.

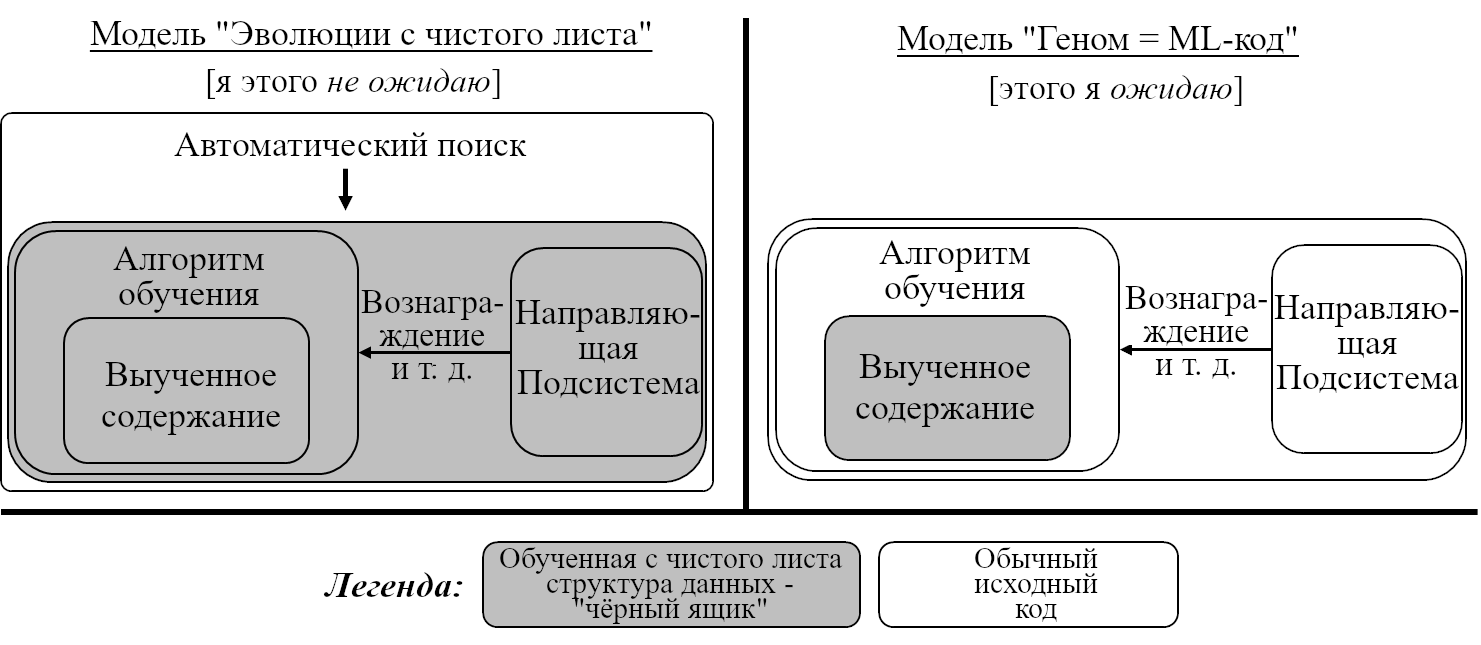

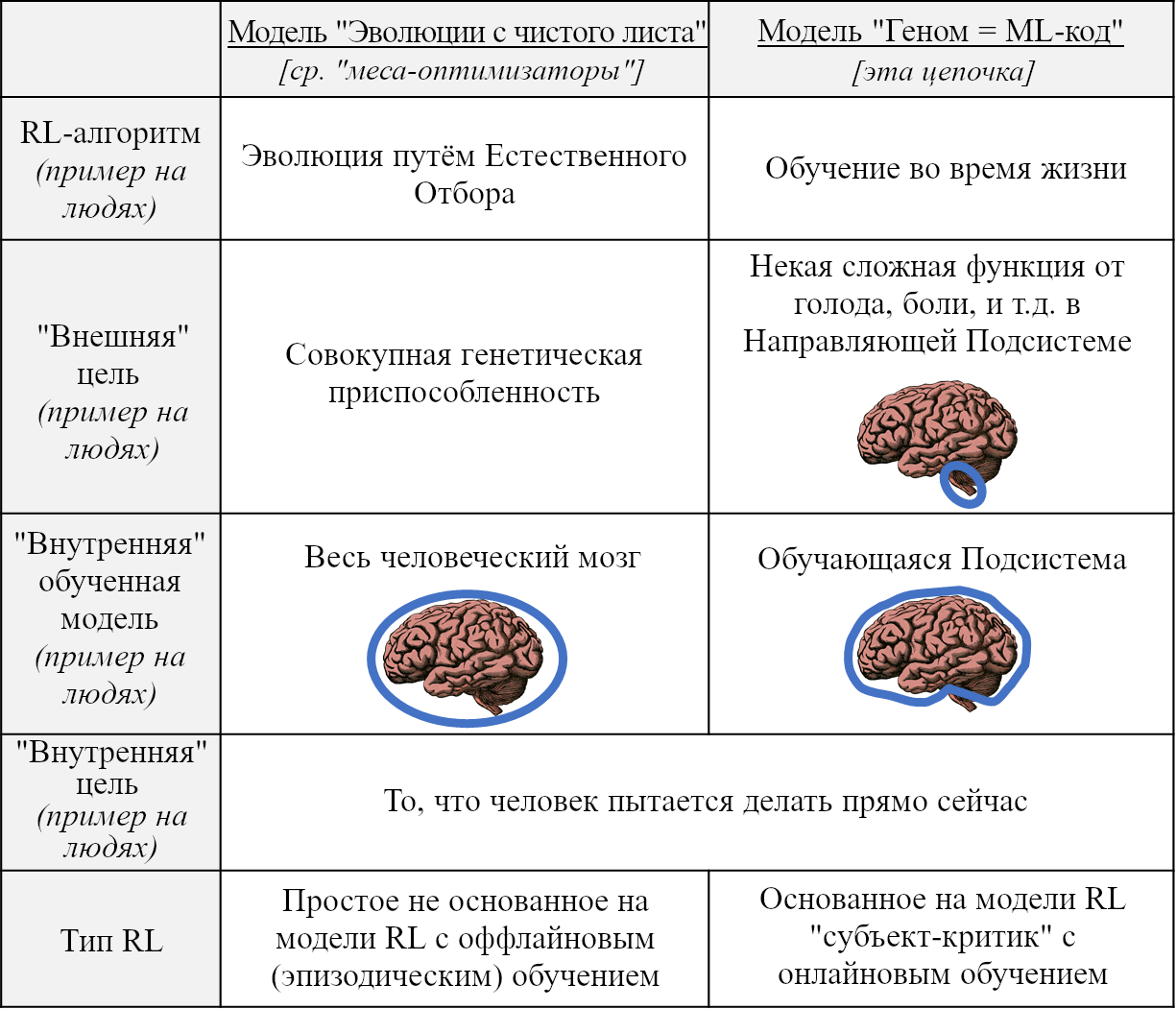

- Я не требую, чтобы «подобный мозгу СИИ» был спроектирован способом, напоминающим то, как был спроектирован мозг, т.е. эволюционным поиском. Даже наоборот: моё рабочее допущение – что он будет спроектирован людьми способом, сходным с типичными проектами машинного обучения сегодня: много написанного людьми кода (очень приблизительно аналогичного геному), часть которого определяет выведение и правила обновлений одного или нескольких алгоритмов обучения (соответствующих алгоритмам обучения мозга во время жизни). В коде могут быть какие-то пустые места, заполняемые поиском гиперпараметров или нейронной архитектуры и т.п. Потом код запускают, и обучающие алгоритмы постепенно создают большую сложно устроенную обученную модель, возможно, с триллионами настраиваемых параметров. Больше об этом в следующих двух постах и Посте №8.

- Я не требую, чтобы «подобный-мозгу СИИ» имел самосознание. Есть этические причины беспокоиться об осознанности СИИ (больше об этом в Посте №12), но всё, что я говорю в этой цепочке, не зависит от этого. Машинное сознание – большая спорная тема, и я не хочу в неё тут погружаться. (Я написал немного об этом в другом месте.)

Я собираюсь много чего заявить про алгоритмы в основе человеческого интеллекта, и потом говорить о безопасном использовании алгоритмов с этими свойствами. Если наши будущие алгоритмы СИИ будут иметь эти свойства, то эта цепочка будет полезна, и я буду склонен называть такие алгоритмы «подобными мозгу». Мы увидим, что это в точности за свойства дальше.

1.3.3 «Подобный мозгу СИИ» (по моему определению) может (и очень возможно, что будет) иметь радикально нечеловеческие мотивации

Я собираюсь много говорить об этом в следующих статьях, но это настолько важно, что я хочу поднять эту тему немедленно.

Да, я знаю, это звучит странно.

Да, я знаю, вы думаете, что я чокнутый.

Но пожалуйста, прошу вас, сначала выслушайте. К моменту, когда мы доберёмся до Поста №3, тогда вы сможете решать, верить мне или нет.

На самом деле, я пойду дальше. Я отстаиваю позицию, что «радикально нечеловеческие мотивации» не просто возможны для подобного-мозгу СИИ, но и являются основным ожиданием от него. Я считаю, что это в целом плохо, и что для избегания этого нам следует проактивно приоритезировать конкретные направления исследований и разработок.

(Для ясности, «радикально нечеловеческие мотивации» - это не синоним «пугающих и опасных мотиваций». К сожалению, «пугающие и опасные мотивации» – тоже моё основное ожидание от подобного-мозгу СИИ!! Но это требует дальнейшей аргументации, и вам придётся подождать её до Поста №10.)

1.4 Что конкретно такое «СИИ»?

Частый источник замешательства – слово «Обобщённый» в «Обобщённом Искусственном Интеллекта» (по-русски устоялось словосочетание «Сильный Искусственный Интеллект», поэтому аббревиатуру я перевожу как СИИ, но вообще в оригинале он General – прим.пер.):

- Слово «Обобщённый» ОЗНАЧАЕТ «не специфичный», как «Говоря обобщённо, в Бостоне жить хорошо.»

- Слово «Обобщённый» НЕ ОЗНАЧАЕТ «универсальный», как в «Я нашёл обобщённое доказательство теоремы.»

СИИ не «обобщённый» во втором смысле. Это не штука, которая может мгновенно обнаружить любой паттерн и решить любую задачу. Люди тоже не могут! На самом деле, никакой алгоритм не может, потому что это фундаментально невозможно. Вместо этого, СИИ – это штука, которая, встретившись с сложной задачей, может быть способна легко её решить, но если нет, то может быть она способна создать инструмент для решения задачи, или найти умный способ обойти задачу, и т.д. В наших целях можно думать о СИИ как об алгоритме, который может «разобраться в вещах» и «понять, что происходит» и «сделать дело», в том числе с использованием языка, науки и технологии, способом, напоминающим то, как это может делать большинство взрослых людей, но не могут младенцы, шимпанзе и GPT-3. Конечно, алгоритмы СИИ вполне могут быть в чём-то слабее людей и сверхчеловеческими в чём-то другом.

В любом случае, эта цепочка – про подобные-мозгу алгоритмы. Эти алгоритмы по определению способны на совершенно любое интеллектуальное поведение, на которое способны люди, и потенциально на куда большее. Так что они уж точно достигают уровня СИИ. А вот сегодняшние ИИ-алгоритмы не являются СИИ. Так что где-то посередине есть неясная граница, отделяющая «СИИ» от «не СИИ». Где точно? Мой ответ: я не знаю, и мне всё равно. Проведение этой линии никогда не казалось мне полезным. Так что я не вернусь к этому в цепочке.

1.5 Какова вероятность, что мы однажды придём к подобному-мозгу СИИ?

Выше (Раздел 1.3.1) я предложил три категории алгоритмов СИИ: «подобные мозгу» (определённые выше), «прозаические» (т.е. подобные современным наиболее впечатляющим глубоким нейросетевым алгоритмам машинного обучения), и «другие».

Если ваше отношение – «Да, давайте изучать безопасность для всех трёх возможностей, просто на всякий случай!!» – как, по-моему, и надо – то, наверное, не так уж важно для принятия решений, как между этими возможностями распределена вероятность.

Но даже если это не важно, об этом интересно поговорить, так что почему нет, я просто быстро перескажу и отвечу на некоторые популярные известные мне мнения на этот счёт.

Мнение №1: «Я оспариваю предпосылку: человеческий мозг работает в целом по тем же принципам, что и нынешние популярные алгоритмы машинного обучения.»

- В первую очередь, «нынешние популярные алгоритмы машинного обучения» – это зонтичный термин, включающий в себя много разных алгоритмов. К примеру, я едва ли вижу хоть какое-то пересечение у «безопасности подобного-GPT-3 СИИ» и «безопасности подобного-мозгу СИИ», но вижу у второго значительное пересечение с «безопасностью подобного-агенту-основанного-на-модели-обучения-с-подкреплением СИИ».

- В любом случае, предполагая «подобный-мозгу СИИ» я могу делать некоторые предположения о его когнитивной архитектуре, внутренних отображениях, обучающих алгоритмах, и так далее.

- Некоторые из этих «ингредиентов подобного-мозгу СИИ» – повсеместные части нынешних популярных алгоритмов машинного обучения (например, алгоритмы обучения; распределённые отображения).

- Другие из этих «ингредиентов подобного-мозгу СИИ» – представлены (по отдельности) в некотором подмножестве нынешних популярных алгоритмов машинного обучения, но отсутствуют в других (например, обучение с подкреплением; предсказывающее обучение [так же известное как самообучение]; явное планирование).

- А ещё некоторые из этих «ингредиентов подобного-мозгу СИИ» кажутся в основном отсутствующими в нынешних самых популярных алгоритмах машинного обучения (например, способность формировать «мысли» [вроде «Я собираюсь пойти в магазин»], которые совмещают немедленные действия, краткосрочные и долгосрочные предсказания и гибкие иерархические планы в генеративной модели мира, поддерживающей причинные, гипотетические и метакогнитивные рассуждения).

- Так что в этом смысле «подобный мозгу СИИ» – это конкретная штука, которая может случиться или не случиться независимо от «прозаического СИИ». Больше про «подобный мозгу СИИ», или, по крайней мере, его важные для безопасности аспекты, в следующих постах.

Мнение №2: «Подобный-мозгу СИИ» возможен, а Прозаический – нет. Этого просто не будет. Современное исследование машинного обучения – не путь к СИИ, точно так же, как забираться на дерево – не путь на Луну.»

- Это кажется мне умеренно популярным мнением среди нейробиологов и когнитивных психологов. Видные защитники этой точки зрения – это, например, Гэри Маркус и Мелани Митчелл.

- Один вопрос: если мы возьмём одну из нынешних самых популярных моделей машинного обучения, не будем добавлять никаких значительных озарений или изменений архитектуры, и просто масштабируем её на ещё больший размер, получим ли мы СИИ? Я присоединяюсь к этим нейробиологам в ожидании ответа «наверное, нет».

- С другой стороны, даже если окажется, что глубокие нейросети не могут делать важные-для-интеллекта штуки X, Y и Z, то ну серьёзно, кто-нибудь наверное просто приклеит к глубоким нейросетям другие компоненты, которые делают X, Y и Z. И у нас останется лишь какой-то бессмысленный спор об определениях, о том, «действительно» ли это прозаический СИИ или нет.

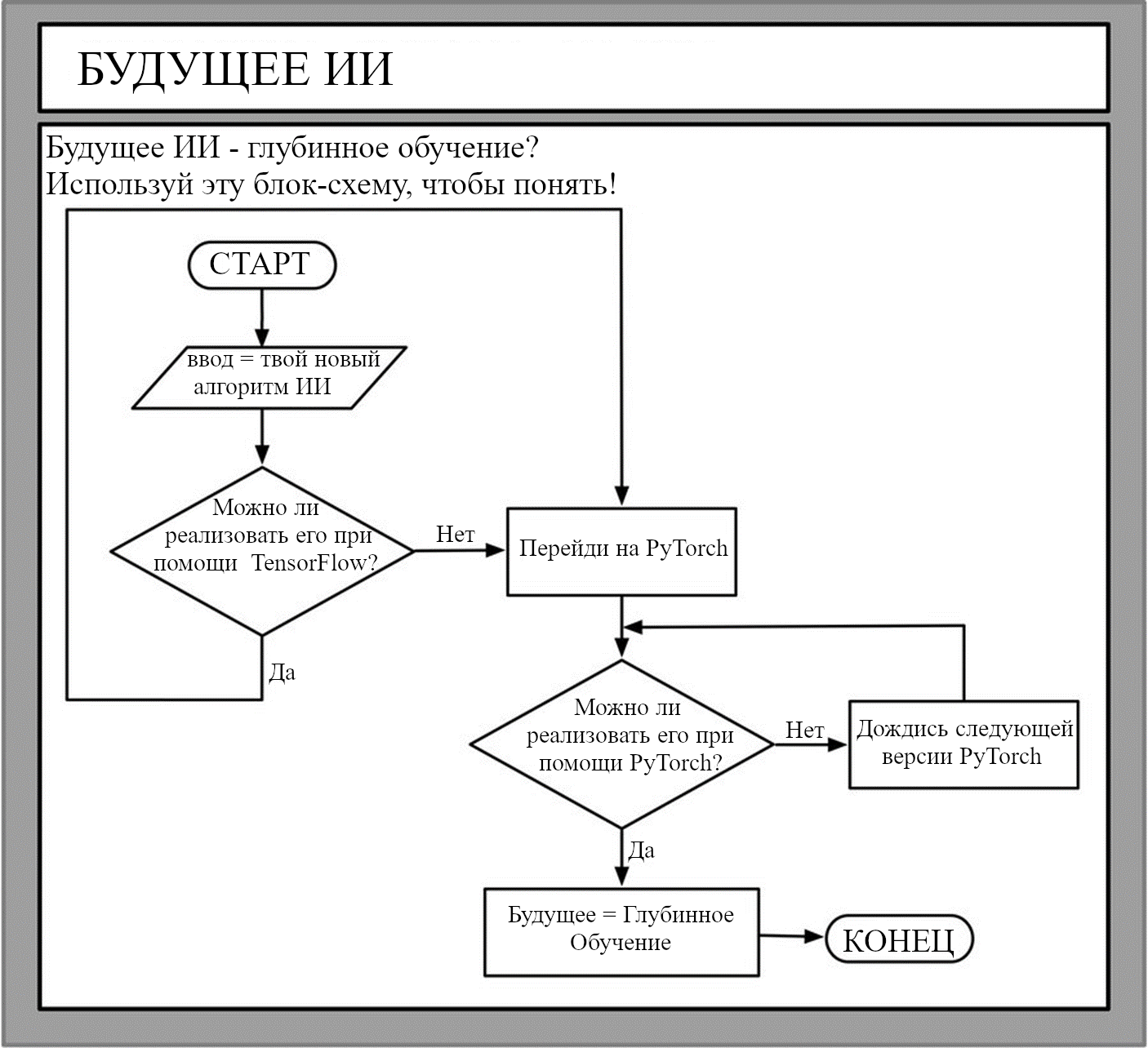

- В любом случае, в этой цепочке я буду предполагать, что СИИ будет иметь некоторые алгоритмические черты (например, онлайновое обучение, разновидность основанного на модели планирования, и т.д. Больше об этом в следующих постах). Я буду предполагать это, потому что (1) эти черты – части человеческого интеллекта, (2) кажется, что они в нём не зря. Мои относящиеся к безопасности рассуждения будут полагаться на наличие этих черт. Могут ли алгоритмы с этими чертами быть реализованы в PyTorch на GPU? Ну, мне всё равно.

Мнение №3: «Прозаический СИИ появится настолько скоро, что другие программы исследований не имеют ни шанса.»

- Некоторое подмножество людей в области машинного обучения считают так. Я нет. Или, по крайней мере, я был бы ужасно удивлён.

- Я согласен, что ЕСЛИ прозаический СИИ, скажем, в пяти годах от нас, то нам почти точно не надо думать о подобном мозгу СИИ или о любой иной программе исследований. Я просто думаю, что это ну очень большое «если».

Мнение №4: «Мозги НАСТОЛЬКО сложные – и мы понимаем о них НАСТОЛЬКО мало после НАСТОЛЬКО больших усилий – что мы никак не можем получить подобный мозгу СИИ даже за следующие 100 лет.»

- Это довольно популярное мнение, как внутри, так и снаружи нейробиологии. Я думаю, что оно крайне неверно, и буду спорить с ним в следующих двух постах.

Мнение №5: «Нейробиологи не пытаются изобрести СИИ, так что нам не следует ожидать, что они это сделают».

- В этом есть какая-то правда, но в основном я не соглашусь. Для начала, некоторое количество ведущих вычислительных нейробиологов (команда нейробиологии DeepMind, Рэндалл О’Райли, Джефф Хокинс, Дайлип Джордж) на самом деле явно пытаются изобрести СИИ. Во-вторых, люди в области ИИ, включая влиятельных лидеров области, стараются иметь в виду нейробиологическую литературу и осваивать её идеи. И в любом случае, «понять мозговой алгоритм, важный для СИИ» – это часть изобретения подобного-мозгу СИИ, независимо от того, пытается ли это сделать человек, проводящий исследование.

Мнение №6: «Подобный-мозгу СИИ – не вполне имеющий смысл концепт; интеллект требует телесного воплощения, не просто мозга в банке (или на чипе).»

- Дебаты о «телесном воплощении» в нейробиологии всё продолжаются. Я принимаю позицию где-то посередине. Я думаю, что будущие СИИ будут иметь какое-то пространство действий – вроде способности (виртуально) призвать конкретную книгу и открыть её на конкретном месте. Я не думаю, что обладание целым буквальным телом важно – к примеру, Кристофер Нолан (1965-2009) был парализован всю жизнь, что не помешало ему быть известным писателем и поэтом. Что важнее, я ожидаю, что какие бы аспекты телесного воплощения ни оказались важны для интеллекта, их можно будет легко встроить в подобный-мозгу СИИ, запущенный на кремниевом чипе. Тело всё же необходимо для интеллекта? ОК, ладно, давайте дадим СИИ виртуальное тело в виртуальном мире. Гормональные сигналы необходимы для интеллекта? ОК, хорошо, мы можем закодировать виртуальные гормональные сигналы. И т.д., и т.п.

Мнение №7: «Подобный-мозгу СИИ несовместим с обычными кремниевыми чипами, он потребует новой аппаратной платформы, основанной на импульсных нейронах, активных дендритах, и т.д. Нейроны попросту лучше в вычислениях, чем кремниевые чипы – просто посмотри на энергетическую эффективность и подобное.»

- Я довольно плохо отношусь к этой позиции. Стандартные кремниевые чипы точно могут симулировать биологические нейроны – нейробиологи всё время это делают. По-видимому, они также могут исполнять «подобные мозгу алгоритмы», используя иные низкоуровневые операции, более подходящие для этого «железа» – так же как один и тот же код на C можно скомпилировать для разных наборов инструкций процессоров. Касательно же «нейроны попросту лучше», я вполне признаю, что человеческий мозг выполняет чертовски впечатляющее количество вычислений для своего крохотного объёма, массы и потребления энергии. Но это всё не жёсткие ограничения! Если СИИ на кремниевых чипах будет буквально в 10000 раз больше по объёму, массе и потреблению энергии, чем человеческий мозг сравнимой интеллектуальной мощности, то я не думаю, что кому-то было бы дело до меньшей эффективности – в частности, стоимость потребляемого им электричества была бы всё ещё меньше минимальной зарплаты в моём регионе!! И моя лучшая оценка такова, что покупка достаточного количества кремниевых чипов для осуществления того же объёма вычислений, что выполняет человеческий мозг за всю жизнь, скорее всего легко доступна, или будет легко доступна в следующем десятилетии, даже для маленьких компаний. Ключевая причина, по которой маленькие компании не создают СИИ сегодня – мы не знаем правильных алгоритмов.

Это просто быстрый обзор; каждое из этих мнений можно растянуть на отдельную статью – да что там, на целую книгу. Что касается меня, я оцениваю вероятность, что у нас будет достаточно подобный мозгу СИИ, чтобы эта цепочка была к месту, более чем в 50%. Но, конечно, кто знает.

1.6 Почему происшествия с СИИ – настолько серьёзное дело?

Две причины: (1) ставки высоки, и (2) задача трудна. Я буду говорить о (2) куда позже в цепочке (Посты №10-11). Давайте поговорим про (1).

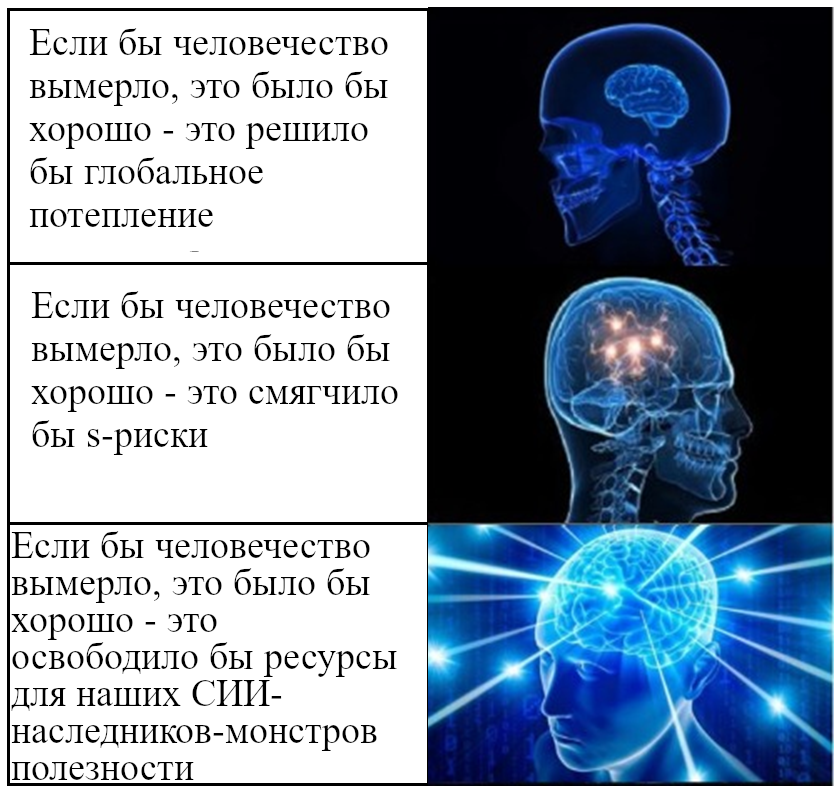

И давайте поговорим конкретнее про возможность одной высокой ставки: риск человеческого вымирания. Это звучит немного дико, но послушайте.

Я оформлю это как ответы на популярные возражения:

Возражение №1: Единственный способ, которым вышедший из под контроля СИИ может привести к вымиранию людей – это если СИИ изобретёт сумасшедшее фантастическое супероружие, например, серую слизь. Как будто это вообще возможно!

О, если бы это было так! Но увы, я не думаю, что фантастическое супероружие невозможно. На самом деле, мне кажется, что где-то примерно на границе возможного для человеческого интеллекта использовать существующие технологии для вымирания человечества!

Подумайте об этом: для амбициозного харизматичного методичного человека уже по крайней мере недалеко от границ возможного устроить производство и высвобождение новой заразной болезни в 100 раз смертельнее, чем COVID-19. Чёрт побери, наверное, возможно выпустить 30 таких болезней одновременно! В то же время, я думаю, хотя бы на границах возможного для амбициозного умного харизматичного человека и найти способ манипулировать системами раннего оповещения о ядерном ударе (обмануть, взломать, подкупить или запугать операторов, и т.д.), устроив полноценную ядерную войну, убив миллиарды людей и посеяв в мире хаос. Это всего лишь два варианта, креативный читатель немедленно придумает ещё немало. В смысле, серьёзно, есть художественные книги с совершенно правдоподобными апокалиптическими безумноучёновскими сценариями, не согласно лишь моему мнению, но согласно экспертам в соответствующих областях.

Теперь, ну принято, вымирание выглядит очень сложнодостижимым требованием! Люди живут в куче разных мест, в том числе на маленьких тропических островах, которые были бы защищены и от ядерной зимы, и от эпидемий. Но тут мы вспомним о большой разнице между интеллектуальным агентом, вроде СИИ и неинтеллектуальным, вроде вируса. Оба могут самовоспроизводиться. Оба могут убить кучу людей. Но СИИ, в отличии от вируса, может взять управление военными дронами и перебить выживших!!

Так что я подозреваю, что мы всё ещё тут в основном из-за того, что самые амбициозные умные харизматичные методичные люди не пытаются всех убить, а не из-за того, что «убить всех» – задача, требующая сумасшедшего фантастического супероружия.

Как описано выше, один из возможных вариантов провала, которые я себе представляю, включает в себя вышедший из-под контроля СИИ, сочетающий интеллект (как минимум) человеческого уровня с радикально нечеловеческими мотивациями. Это была бы новая для мира ситуация, и она не кажется мне комфортной!

Вы можете возразить: То, что пошло не так в этом сценарии – это не вышедший из-под контроля СИИ, это факт того, что человечество слишком уязвимо! И моим ответом будет: Одно другому не мешает! Так что: да, нам совершенно точно следует делать человечество более устойчивым к искусственно созданным эпидемиям и уменьшать шансы атомной войны, и т.д., и т.п. Всё это – замечательные идеи, которые я сильно одобряю, и удачи вам, если вы над ними работаете. Но в то же время, нам следует ещё и очень много работать над тем, чтобы не создать вышедший из-под контроля самовоспроизводящийся подобный-человеку интеллект с радикально нечеловеческими мотивациями!

…О, и ещё одно: может быть, «сумасшедшее фантастическое супероружие вроде серой слизи» тоже возможно! Не знаю! Если так, нам надо быть ещё более осторожными!

Возражение №2: Единственный способ, которым происшествие с СИИ может привести к вымиранию людей – это если СИИ каким-то образом умнее всех людей вместе взятых.

Проблема тут в том, что «все люди вместе взятые» могут не знать, что участвуют в битве против СИИ. Могут знать, а могут и нет. Если СИИ вполне компетентен в секретности, то он скорее организует неожиданную атаку, чтобы никто не знал, что происходит, пока не станет слишком поздно. Или, если СИИ вполне компетентен в дезинформации и пропаганде, он предположительно сможет представить свои действия как несчастные случаи, или как (человеческие) враждебные действия. Может быть, все будут обвинять кого-то ещё, и никто не будет знать, что происходит.

Возражение №3: Единственный способ, которым происшествие с СИИ может привести к вымиранию людей – если СИИ намеренно дадут доступ к рычагам влияния, вроде кодов запуска ядерных ракет, контроля над социальными медиа, и т.д. Но мы также можем запустить код СИИ на всего одном сервере, и потом выключить его, если что-то пойдёт не так.

Проблема тут в том, что интеллектуальные агенты могут превратить «мало ресурсов» в «много ресурсов». Подумайте о Уоррене Баффетте или Адольфе Гитлере.

Интеллектуальные агенты могут зарабатывать деньги (легально или нет), зарабатывать доверие (заслуженное или нет) и получать доступ к другим компьютерам (приобретая серверное время или взламывая их). Последнее особенно важно, потому что СИИ – как вирус, но не как человек – потенциально может самовоспроизводиться. Самовоспроизведение – один из способов, которыми он может защитить себя от выключения, если он на это мотивирован. Другой способ – обмануть / ввести в заблуждение / склонить на свою сторону / подкупить / перехитрить того, кто контролирует кнопку выключения.

(Зерно истины тут в том, что если мы не уверены в мотивации и компетентности СИИ, то давать ему доступ к кодам запуска – очень плохая идея! Попытки ограничить власть и ресурсы СИИ не кажутся решением ни одной из сложнейших интересующих нас тут задач, но это всё ещё может быть как-то полезно, вроде «дополнительного слоя защиты». Так что я целиком за.)

Возражение №4: Хорошие СИИ могут остановить плохих вышедших-из-под-контроля СИИ.

Для начала, если мы не решим техническую проблему того, как направлять мотивацию СИИ и удерживать его под контролем (см. Посты №10-15), то может случиться так, что некоторое время хороших СИИ нет! Вместо этого, все СИИ будут вышедшими из-под контроля!

Вдобавок, вышедшие из-под контроля СИИ будут иметь асимметричные преимущества над хорошими СИИ – вроде возможности красть ресурсы, манипулировать людьми и социальными институтами ложью и дезинформацией; начинать войны, пандемии, блэкауты, выпускать серую слизь, и так далее; и отсутствия необходимости справляться с трудностями координации многих разных людей с разными убеждениями и целями. Больше на эту тему – тут.

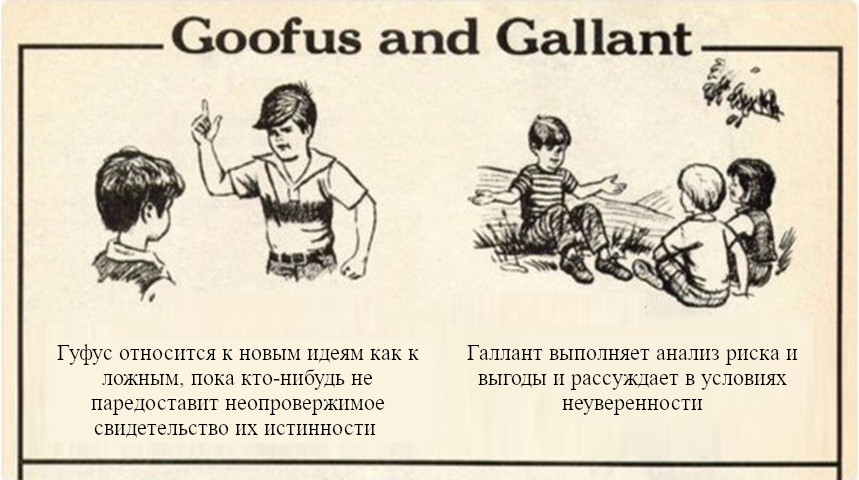

Возражение №5: СИИ, который пытается всех убить – это очень конкретный вариант провала! Нет причин считать, что СИИ попробует это сделать. Это не то, что произойдёт как общий результат забагованного или плохо спроектированного софта СИИ. Такое произойдёт только, если кто-то намеренно вложит в СИИ злобные мотивации. На самом деле, забагованный или плохо спроектированный софт обычно делает, ну, ничего особенного! Я знаю кое-что про забагованный софт – я вообще-то написал один сегодня с утра. Единственное, что было убито – моя самооценка!

Тут есть зерно истины в том, что некоторые баги или недостатки проектирования в коде СИИ действительно приведут к тому, что получившийся софт не будет СИИ, не будет «интеллектуальным», и, возможно, даже не будет функционировать! Такие ошибки не считаются катастрофическими происшествиями, если только мы не оказались настолько глупы, что поставили этот софт управлять ядерным арсеналом. (См. «Возражение №3» выше.)

Однако, я утверждаю, что другие баги / ошибки проектирования будут потенциально вести к тому, что СИИ намеренно будет всех убивать, даже если его создатели – разумные люди с благородными скромными намерениями.

Почему? В области безопасности СИИ классический способ это обосновать – это триада из (1) «Тезиса Ортогональности», (2) «Закона Гудхарта» и (3) «Инструментальной Конвергенции». Вы можете ознакомиться с короткой версией этого тройного аргумента тут. Для длинной версии, читайте дальше: эта цепочка вся про детали мотивации подобного мозгу СИИ, и про то, что там может пойти не так.

Так что запомните эту мысль, мы проясним её к тому моменту, как пройдём Пост №10.

Возражение №6: Если создание СИИ кажется спусковым крючком катастрофических происшествий, то мы просто не будем этого делать, до тех пор, пока (если) не решим проблему.

Моя немедленная реакция: «Мы»? Кто, чёрт побери, такие «Мы»? Занимающееся ИИ сообщество состоит из многих тысяч способных исследователей, рассеянных по земному шару. Они расходятся друг с другом во мнениях практически о чём угодно. Никто не присматривает за тем, что они делают. Некоторые из них работают в секретных военных лабораториях. Так что я не думаю, что мы можем принять за данность, что «мы» не будем проводить разработки, которые вы и я считаем очевидно необдуманными и рискованными.

(К тому же, если от некоторых катастрофических происшествий нельзя восстановиться, то даже одно такое – слишком много.)

К слову, если предположить, что кто-то скажет мне «У меня есть экстраординарно амбициозный план, который потребует многих лет или десятилетий работы, но если мы преуспеем, то «Все на Земле ставят разработку СИИ на паузу, пока не будут решены задачи безопасности» будет возможной опцией в будущем» – ОК, конечно, я бы с готовностью выслушал. По крайней мере, этот человек говорит так, будто понимает масштаб вызова. Конечно, я ожидаю, что это скорее всего провалится. Но кто знает?

Возражение №7: Риски происшествий падают и падают уже на протяжении десятилетий. Ты не читал Стивена Пинкера? Имей веру!

Риски не решают сами себя. Они решаются, когда их решают люди. Самолёты обычно не падают. потому что люди сообразили, как избегать падения самолётов. Реакторы атомных электростанций обычно не плавятся потому, что люди сообразили, как избежать и этого.

Представьте, что я сказал: «Хорошие новости, уровень смертей в автокатастрофах сейчас ниже, чем когда либо! Так что теперь мы можем избавиться от ремней безопасности, зон деформации и дорожных знаков!». Вы бы ответили: «Нет!! Это безумие!! Ремни безопасности, зоны деформации и дорожные знаки – это и есть причина того, что смертей в автокатастрофах меньше, чем когда либо!»

Точно так же, если вы оптимистичны и считаете, что мы в итоге избежим происшествий с СИИ, то это не причина возражать против исследований безопасности СИИ.

Есть ещё кое-что, что надо держать в голове, прежде чем находить утешение в исторических данных о рисках технологических происшествий: пока технология неумолимо становится могущественнее, масштабы урона от технологических происшествий также неумолимо растут. Происшествие с атомной бомбой было бы хуже, чем с конвенционной. Биотеррорист с технологией 2022 года был бы способен нанести куда больший ущерб, чем биотеррорист с технологией 1980 года. Точно так же, раз ИИ системы в будущем станут значительно более мощными, нам следует ожидать, что масштаб урона от происшествий с ними так же будет расти. Так что исторические данные не обязательно правильно отображают будущее.

Возражение №8: Люди всё равно обречены. И вообще, никакой вид не живёт вечно.

Я много встречал вариации этого. И, ну да, я не могу доказать, что это неверно. Но мечехвосты вот существуют уже половину миллиарда лет. Давайте, люди, мы так можем! В любом случае, я без боя сдаваться не собираюсь!

А для людей, принимающих “далёкое” отчуждённое философско-кресельное отношение к человеческому вымиранию: если вас опустошила бы безвременная смерть вашего лучшего друга или любимого члена семьи… но вас не особенно заботит идея вышедшего из-под контроля СИИ, убивающего всех… эммм, я не уверен, что тут сказать. Может, вы не очень осторожно всё продумали?

1.7 Почему думать о безопасности СИИ сейчас? Почему не подождать, пока мы не приблизимся к СИИ и не узнаем больше?

Это частое возражение, и в нём действительно есть огромное зерно истины: в будущем, когда мы будем знать больше деталей об устройстве СИИ, будет много новой технической работы по безопасности, которую мы не можем сделать прямо сейчас.

Однако, есть работа по безопасности, которую мы можем сделать прямо сейчас. Просто продолжайте читать эту цепочку, если не верите мне!

Я хочу заявить, что работу по безопасности, которую мы можем делать прямо сейчас, действительно стоит делать прямо сейчас. Ждать куда хуже, даже если до СИИ ещё много десятилетий. Почему? Три причины:

Причина поторопиться №1: Ранние наводки по поводу безопасности могут влиять на решения при исследовании и разработке, включая «Дифференцированное Технологическое Развитие».

Самое важное, что уж точно есть более чем один способ запрограммировать алгоритм СИИ.

Очень рано в этом процессе мы принимаем высокоуровневые решения о пути к СИИ. Мы можем вести исследования и разработку к одной из многих вариаций «подобного мозгу СИИ», как определено здесь, или к полной эмуляции мозга, или к разным видам «прозаического СИИ» (Раздел 1.3.1), или к СИИ, основанному на запросах к графу базы данных, или к системе знания / дискуссии / рассуждения, мы можем использовать или не использовать различные интерфейсы мозг-компьютер, и так далее. Вероятно, не все из этих путей осуществимы, но тут уж точно есть более чем один путь к более чем одной возможной точке назначения. Нам надо выбрать по какому пути пойти. Чёрт, мы даже решаем, создавать ли СИИ вообще! (Однако, смотри «Возражение №6» выше)

На самом деле, мы принимаем эти решения уже сейчас. Мы принимаем их годами. И наша процедура принятия решений такова, что много отдельных людей по всему миру спрашивают себя: какое направление исследований и разработки лучше всего для меня прямо сейчас? Что принесёт мне работу / повышение / выгоду / высокоцитируемую публикацию прямо сейчас?

Получше была бы такая процедура принятия решений: какой СИИ мы хотим однажды создать? ОК! Давайте попробуем прийти к этому раньше всех плохих альтернатив.

Другими словами, те, кто выбирает направление исследований и разработки, основываясь на том, что выглядит интересным и многообещающим, так же как все остальные, не поменяют путь развития нашей технологии. Они просто проведут нас по тому же пути немного быстрее. Если мы думаем, что некоторые точки назначения лучше других, скажем, если мы пытаемся избежать будущих полностью неподконтрольных СИИ с радикально нечеловеческими мотивациями – то важно выбрать, какие исследования делать, чтобы стратегически ускорить то, что мы хотим, чтобы произошло. Этот принцип называется дифференцированное технологическое развитие – или, более обобщённо, дифференцированный интеллектуальный прогресс.

У меня есть мои собственные предварительные идеи о том, что следует ускорять, чтобы с подобным-мозгу СИИ всё получилось получше. (Я доберусь до этого подробно позже в цепочке.) Но главное, в чём я убеждён: «нам нужно отдельно ускорять работу над выяснением, какую работу следует отдельно ускорять»!! К примеру, будет ли подобный мозгу СИИ склонным к катастрофическим происшествиям или нет? Нам надо выяснить! Потому я и пишу эту цепочку!

Причина поторопиться №2: Мы не знаем, сколько времени займёт исследование безопасности.

Как будет описано куда подробнее в позднейших постах (особенно в Постах №10-15), сейчас неизвестно, как создать СИИ, который надёжно будет пытаться делать то, что мы от него хотим. Мы не знаем, как долго займёт выяснение этого (или доказательство невозможности!). Кажется важным начать сейчас.

Как будет описано позже в цепочке (особенно в Постах №10-15), Безопасность СИИ выглядит очень заковыристой технической задачей. Мы сейчас не знаем, как её решить – на самом деле, мы даже не знаем, решаема ли она. Так что кажется мудрым заточить свои карандаши и приняться за работу прямо сейчас, а не ждать до последнего. Концепт мема украден отсюда

Запомнившаяся аналогия Стюарта Расселла: представьте, что мы получили сообщение от инопланетян «Мы летим к вам на наших космических кораблях, и прибудем через 50 лет. Когда мы доберёмся, мы радикально преобразуем весь ваш мир до неузнавания.» И мы в самом деле видим их корабли в телескопы. Они становятся ближе с каждым годом. Что нам делать?

Если мы будем относиться к приближающемуся инопланетному вторжению так же, как мы на самом деле сейчас относимся к СИИ, то мы коллективно пожмём плечами и скажем «А, 50 лет, это ещё совсем нескоро. Нам не надо думать об этом сейчас! Если 100 человек на Земле пытаются подготовиться к надвигающемуся вторжению, этого достаточно. Может, слишком много! Знаете, спросите меня, этим 100 людям стоит перестать смотреть на звёзды и посмотреть на их собственное общество. Тогда они увидят, что РЕАЛЬНОЕ «надвигающееся инопланетное вторжение» – это кардиоваскулярные заболевания. Вот что убивает людей прямо сейчас!»

…Ну вы поняли. (Не язвлю, ничего такого.)

Причина поторопиться №3: Создание близкого к универсальному консенсуса о чём угодно может быть ужасающе медленным процессом.

Представим, что у меня есть по-настоящему хороший и корректный аргумент о том, что некая архитектура или некий подход к СИИ – просто ужасная идея – непоправимо небезопасная. Я публикую аргумент. Поверят ли мне немедленно и изменят ли направление исследований все вовлечённые в разработку СИИ, включая тех, кто вложил всю свою карьеру в этот подход? Вероятно, нет!!

Бывает, что такое происходит, особенно в зрелых областях вроде математики. Но у некоторых идей широкое (не говоря уж об универсальном) принятие занимает десятки лет: известные примеры включают эволюцию и тектонику плит. Доработка аргументов занимает время. Приведение в порядок свидетельств занимает время. Написание новых учебных пособий занимает время. И да, чтобы несогласные упрямцы умерли и их заменило следующее поколение, тоже занимает время.

Почему почти-универсальный консенсус настолько важен? См. Раздел 1.2 выше. Хорошие идеи о том, как создать СИИ, бесполезны, если люди, создающие СИИ, им не следуют. Если мы хотим добровольного сотрудничества, то нам надо, чтобы создатели СИИ поверили идеям. Если мы хотим принудительного сотрудничества, то нам надо, чтобы люди, обладающие политической властью, поверили идеям. И чтобы создатели СИИ поверили тоже, потому что идеальное принуждение – несбыточная мечта (особенно учитывая секретные лаборатории и т.п.).

1.8 …А ещё это по-настоящему восхитительная задача!

Эй, нейробиологи, слушайте. Некоторые из вас хотят лечить болезни. Хорошо. Давайте. Остальные, вы говорите, что хотите лечить болезни, в своих заявках на гранты, но ну серьёзно, это не ваша настоящая цель, все это знают. На самом деле вы тут, чтобы решать восхитительные нерешённые задачи. Ну, позвольте мне вам сказать, безопасность подобного-мозгу СИИ – это восхитительная нерешённая задача!

Это даже богатый источник озарений о нейробиологии! Когда я целыми днями думаю о штуках из безопасности СИИ (вайрхединг, принятие желаемого за действительное, основания символов, онтологический кризис, интерпретируемость, бла-бла-бла), я задаю вопросы, отличающиеся от обычно задаваемых большинством нейробиологов, а значит наталкиваюсь на другие идеи. (…Мне нравится так думать. Ну, читайте дальше, и сами для себя решите, есть ли в них что-то хорошее.)

Так что даже если я не убедил вас, что техническая задача безопасности СИИ супер-пупер-важная, всё равно читайте. Вы можете работать над ней, потому что она офигенная. ;-)

2. "Обучение с чистого листа" в мозгу

- 1.2.1 Краткое содержание / Оглавление

- 2.2.2 Что такое «обучение с чистого листа»?

- 3.2.3 Три вещи, которыми «обучение с чистого листа» НЕ ЯВЛЯЕТСЯ

- 4.2.4 Моя гипотеза: конечный мозг и мозжечок обучаются с чистого листа, гипоталамус и мозговой ствол – нет

- 5.2.5 Свидетельства того, что конечный мозг и мозжечок обучаются с чистого листа

2.1 Краткое содержание / Оглавление

В предыдущем посте я представил задачу «безопасности подобного-мозгу СИИ». Следующие 6 постов (№2-№7) будут в основном про нейробиологию, в них я буду выстраивать более детальное понимание того, как может выглядеть подобный-мозгу СИИ (или, по крайней мере, его относящиеся к безопасности аспекты).

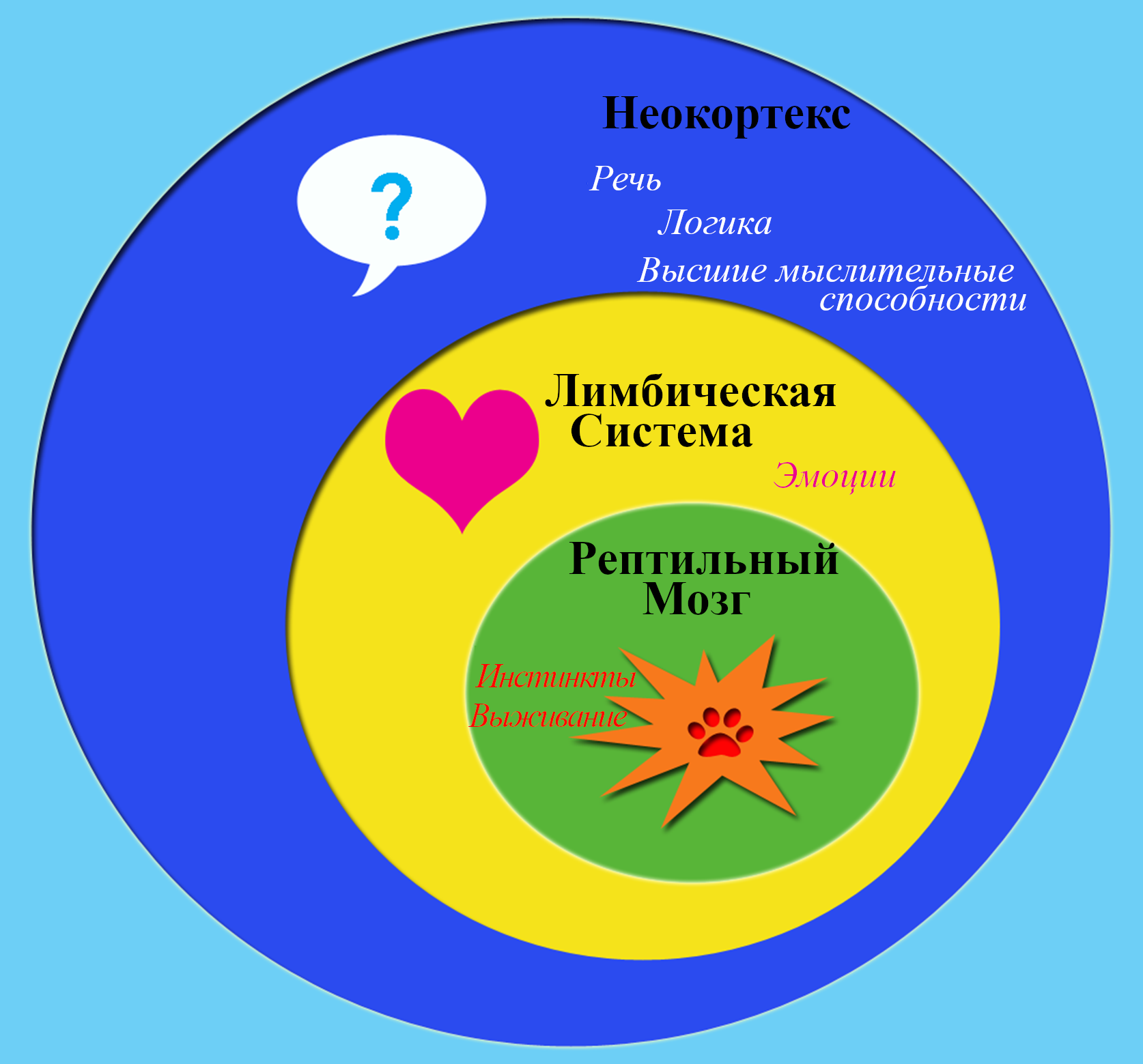

Этот пост сосредоточен на концепции, которую я называю «обучением с чистого листа», я выдвину гипотезу разделения, в котором 96% человеческого мозга (включая неокортекс) «обучается с чистого листа», а остальные 4% (включая ствол головного мозга) – нет. Эта гипотеза – центральная часть моего представления о том, как работает мозг, так что она требуется для дальнейших рассуждений в этой цепочке.

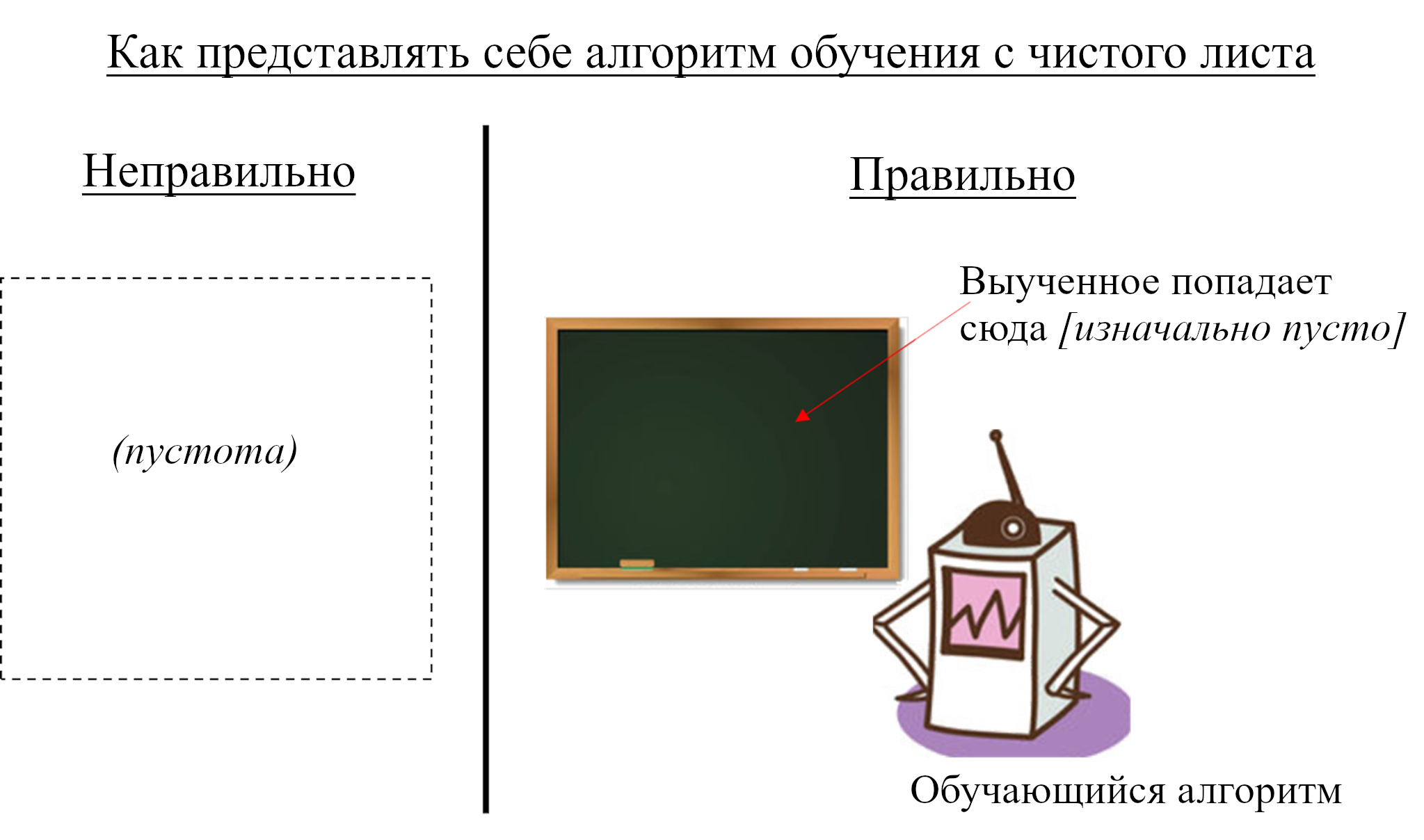

- В Разделе 2.2 я определю концепцию «обучения с чистого листа». Например, заявляя, что неокортекс «обучается с чистого листа», я имею в виду, что он изначально совершенно бесполезен для организма – выводит улучшающие приспособленность сигналы не чаще, чем случайно – пока не начинает обучаться (во время жизни индивида). Вот пара повседневных примеров штук, которые «обучаются с чистого листа»:

- В большинстве статей по глубинному обучению модель «учится с чистого листа» – она инициализирована случайными весами, так что поначалу её вывод – случайный мусор. Но по ходу обучения её веса обновляются и вывод модели со временем становится весьма полезным.

- Пустой жёсткий диск тоже «учится с чистого листа» – нельзя вытащить оттуда полезную информацию, пока её туда не запихнули.

- В Разделе 2.3 я проясню некоторые частые поводы к замешательству:

- «Обучение с чистого листа» – не то же самое, что «с нуля», потому что существуют встроенные алгоритм обучения, нейронная архитектура, гиперпараметры и т.д.

- «Обучение с чистого листа» – не то же самое, что «воспитание превыше природы», потому что (1) только некоторые части мозга обучаются с чистого листа, а другие – нет, и (2) алгоритмы обучения вовсе не обязательно обучаются внешнему окружению – они так же могут обучаться, например, как контролировать собственное тело.

- «Обучение с чистого листа» – не то же самое (и конкретнее), чем «пластичность мозга», потому что последняя также включает (например) жёстко генетически заданную цепь с всего одним конкретным подстраиваемым параметром, полу-перманентно изменяющимся в некоторых условиях.

- В Разделе 2.4 я опишу свою гипотезу о том, что две большие части мозга существуют исключительно для того, чтобы исполнять алгоритмы обучения с чистого листа – конкретно, конечный мозг (неокортекс, гиппокампус, миндалевидное тело, большая часть базальных ганглиев) и мозжечок. Вместе они составляют 96% от объёма человеческого мозга.

- В Разделе 2.5 я коснусь четырёх источников свидетельств, относящихся к моей гипотезе о том, что конечный мозг и мозжечок обучаются с нуля: (1) размышления о том, как мозг работает на высоком уровне, (2) неонатальные данные, (3) связь с гипотезой «однородности коры» и относящимися к ней проблемами, и (4) возможность, что некоторое свойство предварительной обработки в мозгу – так называемое «разделение паттернов» – включает рандомизацию, заставляющую последующие алгоритмы обучаться с чистого листа.

- В Разделе 2.6 я немного поговорю о том, является ли моя гипотеза мэйнстримной или выделяющейся. (Ответ: я не уверен.)

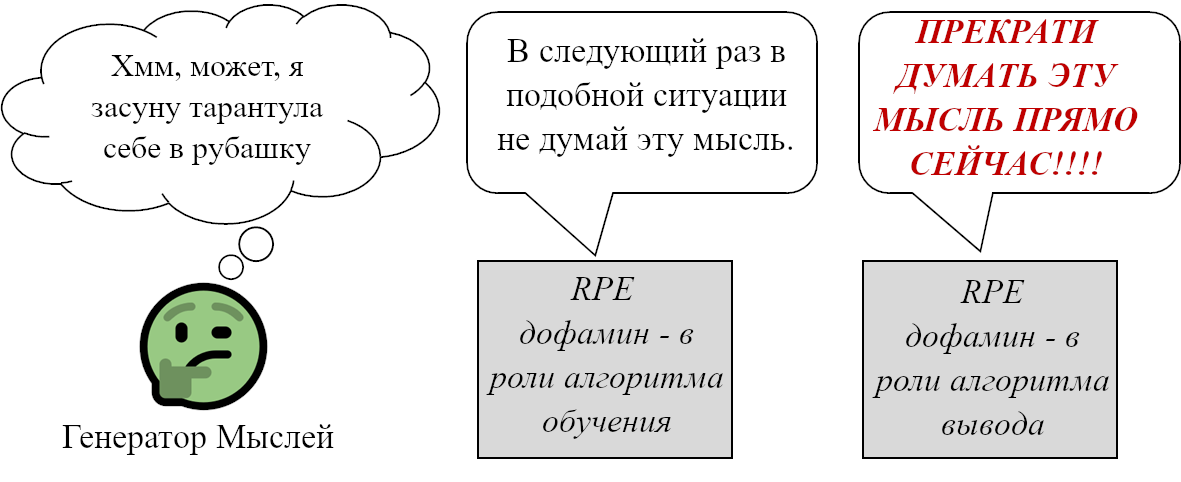

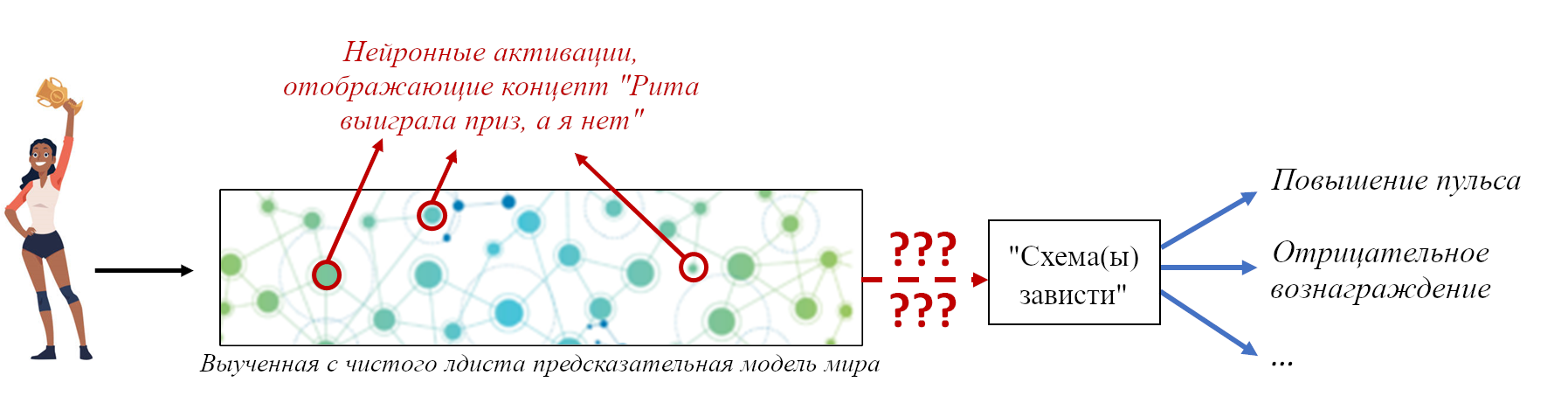

- В Разделе 2.7 я выдам намёки на то, почему обучение с чистого листа важно для безопасности СИИ – мы попадаем в ситуацию, где то, что мы хотим, чтобы пытался сделать СИИ (например, вылечить болезнь Альцгеймера) – концепт, погребённый в большой и сложной-для-интерпретации структуре данных. Поэтому написание относящегося к мотивации кода весьма не прямолинейно. Подробнее об этом будет в будущих постах.

- Раздел 2.8 будет первой из трёх частей моего обсуждения «сроков до подобного-мозгу СИИ», сосредоточенной на том, сколько времени займёт у учёных реверс-инжиниринг ключевых управляющих принципов обучающейся с чистого листа части мозга. (Остальное обсуждение сроков будет в следующем посте.)

2.2 Что такое «обучение с чистого листа»?

Как указано в введении выше, я предлагаю гипотезу, утверждающую, что большие части мозга – конечный мозг и мозжечок (см. Раздел 2.4 ниже) – «обучаются с чистого листа», в том смысле, что изначально они выдают не вкладывающиеся в эволюционно-адаптивное поведение случайные мусорные сигналы, но со временем становятся всё более полезными благодаря работающему во время жизни алгоритму обучения.

Вот два способа думать о гипотезе обучения с чистого листа:

- Как вам следует думать об обучении с чистого листа (если вы из машинного обучения): Представьте глубокую нейросеть, инициализированную случайными весами. Её нейронная архитектура может быть простой или невероятно сложной, это не важно. У неё точно есть склонности, из-за которых выучить одни виды паттернов для нее легче чем другие. Но их в любом случае надо выучить! Если её веса изначально случайны, то она изначально бесполезна и становится более полезной по мере получения обучающих данных. Идея в том, что эти части мозга (неокортекс и т.д.) схожим образом «инициализированы случайными весами» или обладают каким-то эквивалентным свойством.

- Как вам следует думать об обучении с чистого листа (если вы из нейробиологии): Представьте о связанной с памятью системе, вроде гиппокампуса. Способность формировать воспоминания – очень полезная для организма! …Но она не помогает от рождения!![1] Вам нужно накопить воспоминания перед тем, как их использовать! Моё предположение – что всё в конечном мозге и мозжечке попадает в ту же категорию – это всё разновидности модулей памяти. Они могут быть очень особыми разновидностями модулей памяти! Неокортекс, например, может обучиться и запомнить суперсложную сеть взаимосвязанных паттернов, к нему прилагаются мощные возможности составления запросов, он даже может делать запросы самому себе рекуррентными петлями, и т.д. Но всё равно, это форма памяти, и она изначально бесполезна, и становится всё более полезной для организма, накапливая выученное содержание.

2.3 Три вещи, которыми «обучение с чистого листа» НЕ ЯВЛЯЕТСЯ

2.3.1 Обучение с чистого листа – это НЕ «с нуля»

Я уже упомянул это, но я хочу быть максимально ясным: если неокортекс (к примеру) обучается с чистого листа, это не означает, что в нём нет жёстко генетически закодированного информационного содержания. Это означает, что жёстко генетически закодированное информационное содержание скорее всего что-то в этом духе:

- Обучающий(е) алгоритм(ы) – т.е. встроенные правила полу-перманентных изменений нейронов или их связей в зависимости от ситуации.

- Алгоритм(ы) вывода – т.е. встроенные правила того, какие выходные сигналы следует послать прямо сейчас, чтобы помочь выжить и преуспеть. Сами выходные сигналы, конечно, также зависят от ранее выученной информации.

- Архитектура нейронной сети – т.е. встроенная высокоуровневая диаграмма связей, определяющая, как разные части обучающегося модуля соединены друг с другом, входными и выходными сигналами.

- Гиперпараметры – т.е. разные части архитектуры могут иметь разные встроенные скорости обучения. Эти гиперпараметры тоже могут меняться при развитии (см. сенситивные периоды). Также может быть и встроенная способность изменять гиперпараметры от момента к моменту в ответ на специальные управляющие сигналы (в виде нейромодуляторов вроде ацетилхолина).

При наличии всех этих встроенных составляющих алгоритм обучения с чистого листа готов принимать снаружи входные данные и управляющие сигналы[2], и постепенно обучается делать что-то полезное.

Эта встроенная информация не обязательно проста. Может быть 50000 совершенно разных алгоритмов обучения в 50000 разных частях неокортекса, и это всё ещё будет с моей точки зрения считаться обучением с чистого листа! (Впрочем, я не думаю, что это так – см. Раздел 2.5.3 про «однородность».)

Представляя себе обучающийся с чистого листа алгоритм, *не* следует представлять пустоту, наполняемую данными. Стоит представлять *механизм*, который постоянно (1) записывает информацию в хранилище памяти, и (2) выполняет запросы к текущему содержанию хранилища памяти. «С чистого листа» просто означает, что хранилище памяти изначально пусто. Таких механизмов *много*, они следуют разным процедурам того, что записывать и как запрашивать. К примеру «справочная таблица» соответствует простому механизму, который просто записывает то, что видит. Другим механизмам соответствуют алгоритмы обучения с учителем, алгоритмы обучения с подкреплением, автокодировщики, и т.д., и т.п.

2.3.2 Обучение с чистого листа НЕ означает «воспитание превыше природы»

Есть тенденция ассоциировать «алгоритмы обучения с чистого листа» с стороной «воспитания» споров «природа против воспитания». Я думаю, это неверно. Даже напротив. Я думаю, что гипотеза обучения с чистого листа полностью совместима с возможностью того, что эволюционировавшее встроенное поведение играет большую роль.

Две причины:

Во-первых, некоторые части мозга совершенно точно НЕ выполняют алгоритмы обучения с чистого листа! Это в основном мозговой ствол и гипоталамус (больше про это ниже и в следующем посте). Эти не-обучающиеся-с-чистого-листа части мозга должны быть полностью ответственны за любое адаптивное поведение при рождении.[1] Правдоподобно ли это? Думаю, да, учитывая впечатляющий диапазон функциональности мозгового ствола. К примеру, в неокортексе есть цепи обработки визуальных и других сенсорных данных – но в мозговом стволе тоже! В неокортексе есть цепи моторного контроля – и в мозговом стволе тоже! В по крайней мере некоторых случаях полностью адаптивное поведение кажется исполняемым целиком в мозговом стволе: к примеру, у мышей есть цепь-обнаружения-приближающихся-птиц в мозговом стволе, напрямую соединённая с цепью-убегания-прочь в нём же. Так что моя гипотеза обучения с чистого листа не делает никаких общих заявлений о том, какие алгоритмы или функциональности присутствуют или отсутствуют в мозгу. Только заявления о том, что некоторые виды алгоритмов есть только в некоторых конкретных частях мозга.

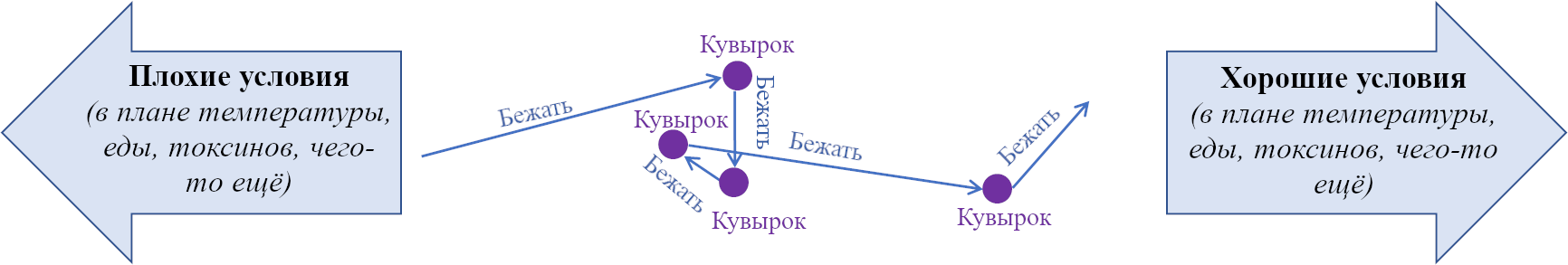

Во-вторых, «обучение с чистого листа» - не то же самое, что «обучение из окружения». Вот искусственный пример.[3] Представьте, что мозговой ствол птицы имеет встроенную способность судить о том, как должно звучать хорошее птичье пение, но не инструкцию, как произвести хорошее птичье пение. Ну, алгоритм обучения с чистого листа может заполнить эту дыру – методом проб и ошибок вывести вторую способность из первой. Этот пример показывает, что алгоритмы обучения с чистого листа могут управлять поведением, которое мы естественно и корректно описываем как встроенное / «природное, а не воспитанное».

2.3.3 Обучение с чистого листа – это НЕ более общее понятие «пластичности»

«Пластичность» - это термин, означающий, что мозг полу-перманентно изменяет себя, обычно изменяя присутствие / отсутствие / силу синаптических связей нейронов, но иногда и другими механизмами, вроде изменений в экспрессии генов в нейронах.

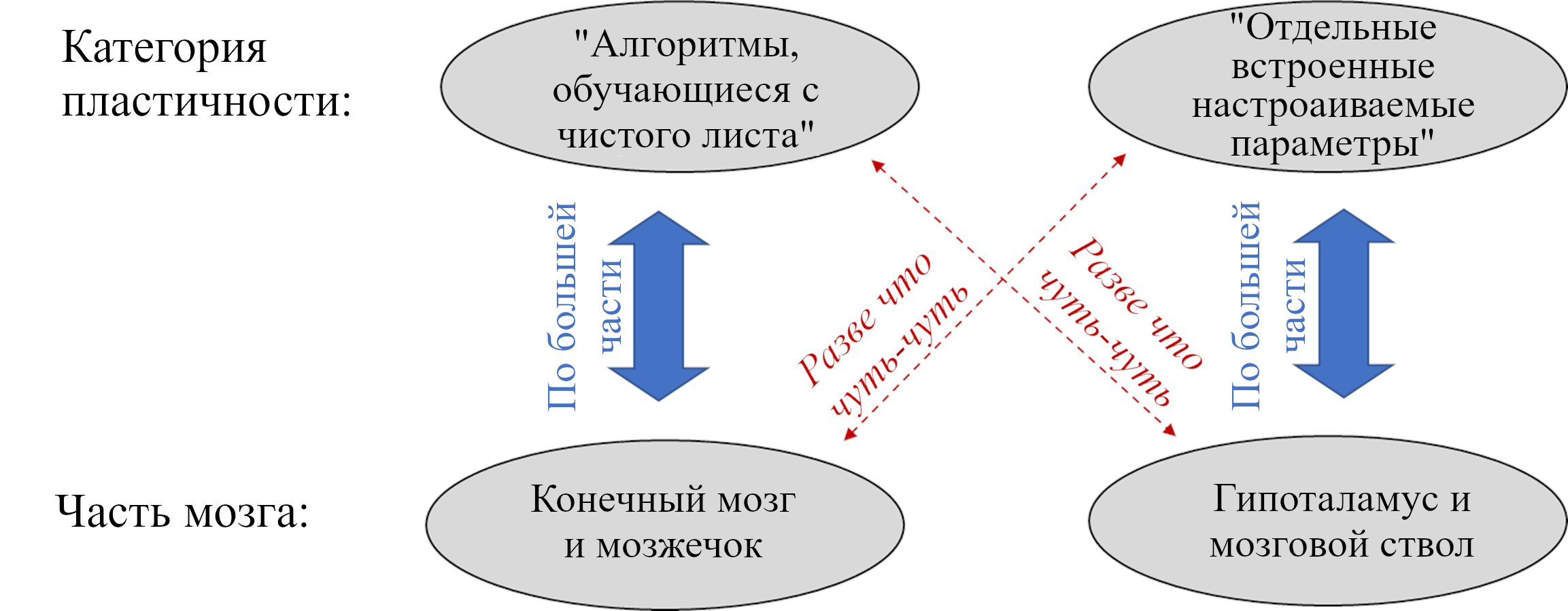

Любой алгоритм обучения с чистого листа обязательно включает пластичность. Но не вся пластичность мозга – часть алгоритмов обучения с чистого листа. Другая возможность – то, что я называю «отдельными встроенными настраиваемыми параметрами». Вот таблица с примерами и того, и другого и тем, чем они отличаются:

| Алгоритмы обучения с чистого листа | Отдельные встроенные настраиваемые параметры | |

| Стереотипный пример | Любая статья о глубоком обучении: есть *обучающий алгоритм*, который постепенно создаёт *обученную модель*, настраивая много её параметров. | Некоторые связи в крысином мозгу усиливаются, когда крыса выигрывает драку – по сути, считают, сколько драк крыса выиграла за свою жизнь. Потом такая связь используется для выполнения поведения «Выиграв много драк за свою жизнь – будь агрессивнее.» (ссылка) |

| Количество параметров, изменяемых на основании входных данных (т.е. как много измерений в пространстве всех возможных обученных моделей?) | Может быть много – сотни, тысячи, миллионы, и т.д. | Скорее всего мало, может даже один |

| Если масштабировать это вверх, будет ли это работать лучше после обучения? | Да, наверное. | А?? Что, чёрт побери, вообще значит «масштабировать»? |

Я не думаю, что между этими штуками есть чёткая граница; наверное, есть спорная область, где одна перетекает в другую. По крайней мере, я думаю, что в теории она есть. На практике, мне кажется, существует довольно явное разделение – всегда, когда я узнаю о конкретном примере пластичности мозга, она явным образом попадает в одну или другую категорию.

К слову, как мне кажется, моя категоризация для нейробиологии несколько необычна. Нейробиологи чаще сосредотачиваются на низкоуровневых деталях реализации: «Источник пластичности – синаптические изменения или изменения экспрессии генов?», «Каков биохимический механизм?» и т.д. Это совсем другая тема. К примеру, готов поспорить, что один и то же низкоуровневый биохимический механизм синаптической пластичности может быть вовлечён и в алгоритмы обучения с чистого листа и в изменение отдельного встроенного настраиваемого параметра.

Почему я подымаю эту тему? Потому что я планирую заявить, что гипоталамус и мозговой ствол не выполняют или почти не выполняют алгоритмы обучения с чистого листа. Но они точно имеют отдельные встроенные настраиваемые параметры.

Для конкретики, вот три примера «отдельных встроенных настраиваемых параметров» в гипоталамусе и мозговом стволе:

- Уже упомянутая цепь в крысином гипоталамусе «если ты продолжаешь выигрывать драки, становись агрессивнее» – ссылка.

- Вот цепь в крысином гипоталамусе «если тебе опасно не хватает соли, увеличь базовое желание соли».

- Верхнее двухолмие в мозговом стволе содержит зрительную, слуховую и саккадную моторную область, и механизм, связывающий все три – так что, когда ты видишь вспышку или слышишь шум, ты немедленно направляешь взгляд в точности в правильном направлении. В этом механизме есть пластичность – к примеру, он может самокорректироваться у животного, носящего призматические очки. Я не знаю точных деталей, но полагаю, что это что-то вроде: Если видишь движение и переводишь на него взгляд, но движение не центрировано даже после саккады, то это генерирует сигнал об ошибке, сдвигающий соответствие областей. Может, вся эта система включает 8 настраиваемых параметров (масштаб и смещение, горизонталь и вертикаль, три области для выравнивания), а может она сложнее – опять же, я не знаю деталей.

Видна разница? Вернитесь к таблице, если всё ещё в замешательстве.

2.4 Моя гипотеза: конечный мозг и мозжечок обучаются с чистого листа, гипоталамус и мозговой ствол – нет

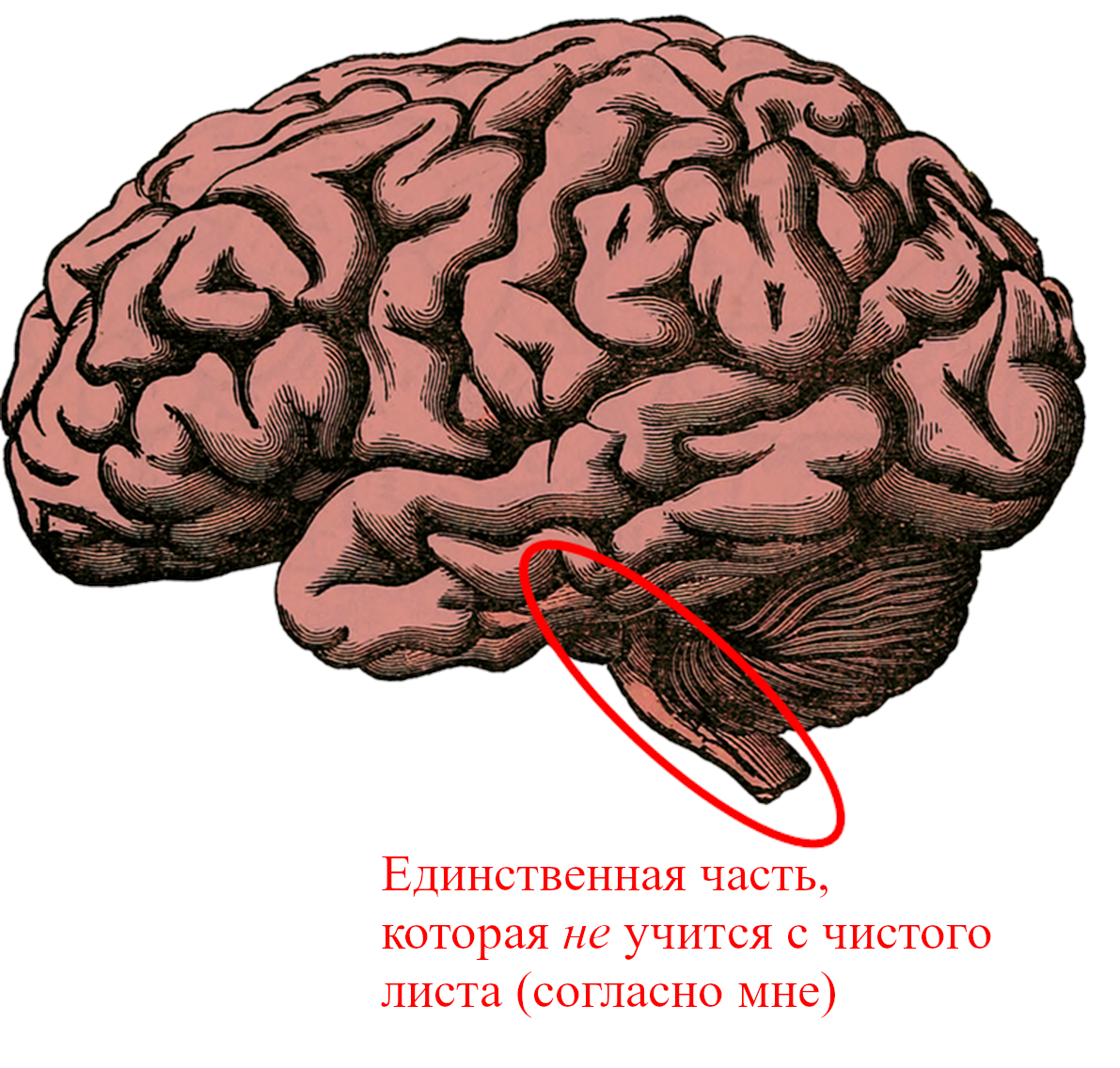

Моя гипотеза заключается в том, что ~96% человеческого мозга выполняет алгоритмы обучения с чистого листа. Главные исключения – мозговой ствол и гипоталамус, общим размером с большой палец. Источник картинки.

Вот моя гипотеза в трёх утверждениях:

Во-первых, я думаю, что весь конечный мозг обучается с чистого листа (и бесполезен при рождении[1]). Конечный мозг (также известный как «большой мозг») у людей – это в основном неокортекс, плюс гиппокампус, миндалевидное тело, большая часть базальных ганглиев и разнообразные более загадочные кусочки.

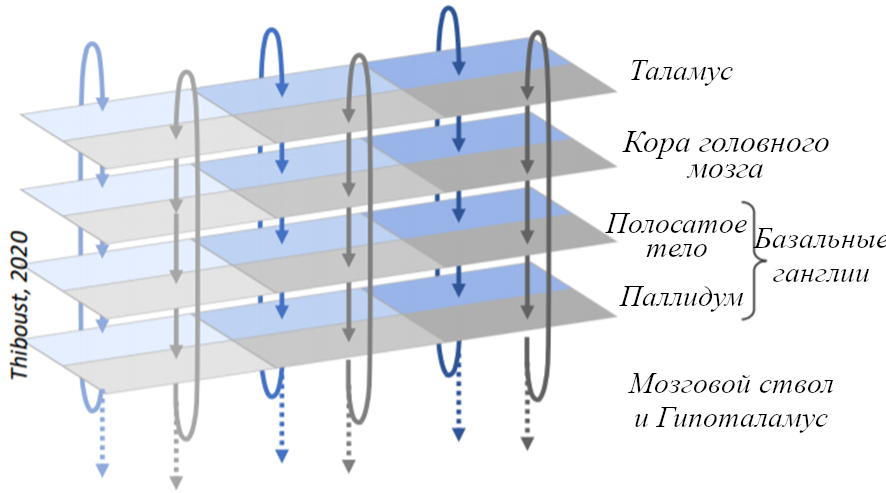

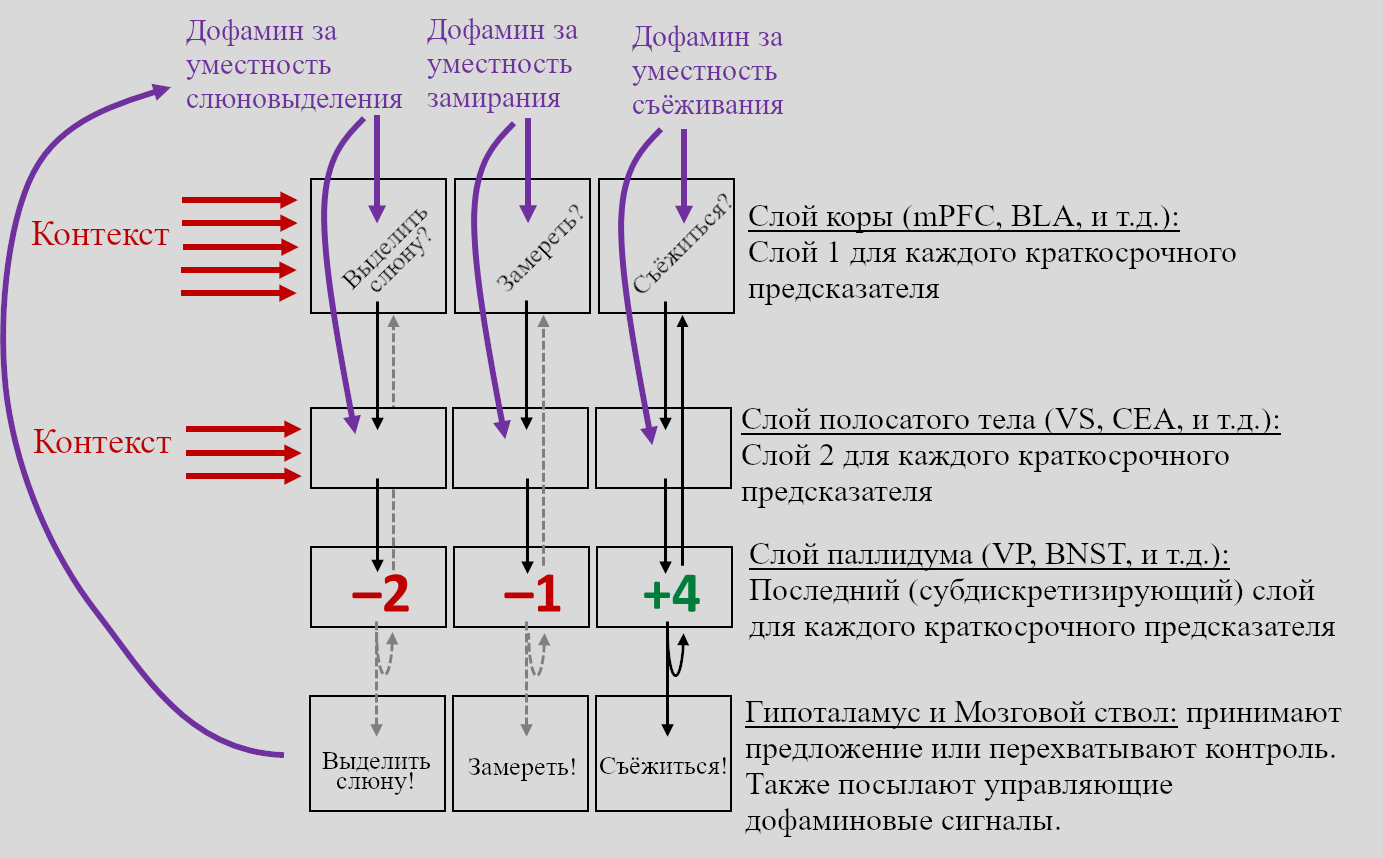

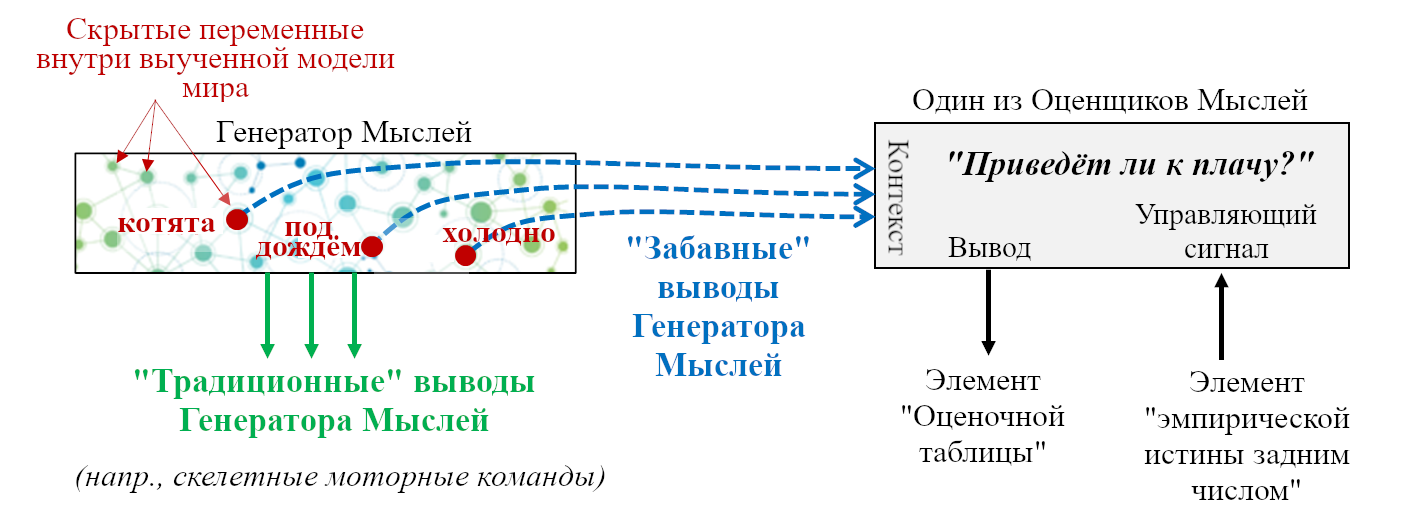

Несмотря на внешний вид, нравящаяся мне модель (изначально принадлежащая гениальному Ларри Свансону) заявляет, что весь конечный мозг организован в трёхслойную структуру (кора, полосатое тело, паллидум), и эта структура согласуется относительно маленьким количеством взаимосвязанных алгоритмов обучения. См. мой (довольно длинный и технический) пост Большая Картина Фазового Дофамина за подробностями.

(ОБНОВЛЕНИЕ: Узнав больше, я хочу это пересмотреть. Я думаю, что вся «кортикальная мантия» и всё «расширенное полосатое тело» обучаются с чистого листа. (Это включает штуки вроде гиппокампуса, миндалевидного тела, боковой перегородки, и т.д. - которые эмбриологически и/или цитоархитектурно развиваются вместе с корой и/или полосатым телом). Кто касается паллидума, я думаю, некоторые его части по сути являются расширением RAS мозгового ствола, так что им точно не место в этом списке. Про другие его части может оказаться и так, и так, в зависимости от того, как определить поверхность ввода/вывода некоторых алгоритмов обучения. Паллидум довольно маленький, так что мне не надо менять оценки объёма, включая число 96%. Я не буду проходить по всей цепочке и менять «конечный мозг» на «кортикальная мантия и расширенное полосатое тело» в миллионе мест, извините, придётся просто запомнить.)

Таламус технически не входит в конечный мозг, но по крайней мере его часть тесно связана с корой – некоторые исследователи описывают его функциональность как «дополнительный слой» коры. Так что я буду считать и его частью обучающегося с чистого листа конечного мозга.

Конечный мозг и таламус вместе составляют ~86% объёма человеческого мозга (ссылка).

Во-вторых, я думаю, что мозжечок тоже обучается с чистого листа (и тоже бесполезен при рождении). Мозжечок – это ~10% объёма взрослого мозга (ссылка). Больше про мозжечок будет в Посте №4.

В третьих, я думаю, что гипоталамус и мозговой ствол совершенно точно НЕ обучаются с чистого листа (и они очень активны и полезны прямо с рождения). Думаю, другие части промежуточного мозга – например, хабенула и шишковидное тело – тоже попадают в эту категорию.

Я не буду удивлён, если обнаружатся мелкие исключения из этой картины. Может, где-то в конечном мозге есть маленькое ядро, управляющее биологически-активным поведением, не обучаясь ему с чистого листа. Конечно, почему нет. Но сейчас я считаю, что такая картина по крайней мере приблизительно верна.

В следующих двух разделах я расскажу о свидетельствах, относящихся к моей гипотезе, и о том, что о ней думают другие люди из этой области.

2.5 Свидетельства того, что конечный мозг и мозжечок обучаются с чистого листа

2.5.1 Свидетельства общей картины

Из чтения и разговоров с людьми я вижу, что самые большие преграды к тому, чтобы поверить, что конечный мозг и мозжечок обучаются с чистого листа – это в подавляющем большинстве случаев не детализированные аргументы о данных нейробиологии, а скорее:

- Нерассмотрение этой гипотезы как возможности вовсе

- Замешательство касательно следствий гипотезы, в частности – как она встраивается в одну осмысленную картину мозга и поведения.

Раз вы досюда дочитали, №1 уже не должно быть проблемой.

Что по поводу №2? Типичный тип вопросов – это «Если конечный мозг и мозжечок обучаются с чистого листа, то как они делают X?» – для разных X. Если есть X, для которого мы совсем не можем ответить на этот вопрос, то это подразумевает, что гипотеза обучения с чистого листа неверна. Напротив, если мы можем найти действительно хорошие ответы на этот вопрос для многих X, то это свидетельство (хоть и не доказательство), того что гипотеза обучения с чистого листа верна. Следующие посты, я надеюсь, обеспечат вам такие свидетельства.

2.5.2 Неонатальное свидетельство

Если конечный мозг и мозжечок не могут производить биологически-адаптивный вывод, не научившись этому со временем, то из этого следует, что любое биологически-адаптивное поведение новорожденных[1] должно управляться мозговым стволом и гипоталамусом. Так ли это? Кажется, такие вещи должны быть экспериментально измеримы, верно? И в этой статье 1991 года действительно говорится «накопившиеся свидетельства приводят к выводу, что перцептомоторная активность новорожденных в основном контролируется подкорковыми механизмами». Но не знаю, изменилось ли что за прошедшие 30 лет – дайте мне знать, если видели другие упоминания этого.

На самом деле, этот вопрос сложнее, чем кажется. Представьте, что младенец совершает что-то биологически-адаптивное…

- Первый вопрос, который надо задать: в самом деле? Может, это плохой (или неверно интерпретированный) эксперимент. К примеру, если взрослый покажет младенцу язык, высунет ли младенец язык тоже, имитируя? Кажется простым вопросом, верно? Не-а, это источник споров уже десятилетия. Конкурирующая теория строится вокруг орального исследования: «высовывание языка кажется общим ответом на заметные стимулы и зависит от интереса ребёнка к стимулу»; показывающий язык взрослый просто активирует этот ответ, но так же делают мелькающие огоньки и звуки музыки. Я уверен, кто-то знает, каким экспериментам с новорожденными можно доверять, но я, по крайней мере пока не знаю. И я очень параноидально отношусь к тому, что две уважаемые книги в этой области (Учёный в кроватке,Происхождение Концептов) повторяют заявление об имитации будто это твёрдый как скала факт.

- Второй вопрос, который надо задать: результат ли это прижизненного обучения? Помните, даже у трёхмесячного ребёнка есть 4 миллиона секунд «обучающих данных». На самом деле, даже только что рождённый ребёнок возможно выполнял алгоритмы обучения с чистого листа в утробе.[1]

- Третий вопрос, который надо задать: какая часть мозга управляет этим поведением? Моя гипотеза заявляет, что не-выученное адаптивное поведение не может управляться конечным мозгом или мозжечком. Но моя гипотеза позволяет мозговому стволу управление таким поведением! И выяснение, какая часть мозга новорожденного в ответе за некоторое поведение может быть экспериментально сложным.

2.5.3 Свидетельство «однородности»

Гипотеза «однородности коры» заявляет, что все части неокортекса выполняют более-менее похожие алгоритмы. (…С некоторыми нюансами, особенно связанными с неоднородной нейронной архитектурой и гиперпараметрами). Мнения по поводу того, верна ли эта гипотеза (и в какой степени) расходятся – я кратко обсуждал свидетельства и аргументы тут. Я считаю, что весьма вероятно, что она верна, по крайней мере в слабом смысле, что будущий исследователь, имеющий очень хорошее детальное понимание того, как работает Область Неокортекса №147 будет очень хорошо продвинут в понимании того, как работает буквально любая другая часть неокортекса. Я не буду тут погружаться в это подробнее; мне кажется, это не совсем укладывается в тему этой цепочки.

Я упоминаю это потому, что если вы верите в однородность коры, то вам, наверное, следует верить и в то, что она обучается с чистого листа. Аргументация такая:

Неокортекс взрослого делает много явно различающихся вещей: обрабатывает зрительную информацию, слуховую информацию, занимается моторным контролем, языком, планированием и т.д. Как это совместимо с однородностью коры?

Обучение с чистого листа предоставляет правдоподобный способ. В конце концов, мы знаем, что один и тот же алгоритм обучения с чистого листа, если ему скормить очень разные входные данные и управляющие сигналы, может начать делать очень разные вещи: посмотрите как глубокие нейросети-трансформеры можно обучить генерировать текст на естественном языке, или картинки, или музыку, или сигналы моторного контроля робота, и т.д.

Если мы, напротив, примем однородность коры, но отвергнем обучение с чистого листа, то, эм-м-м, я не вижу осмысленных вариантов того, как это может работать.

Аналогично (но куда реже обсуждаемо, чем случай неокортекса), стоит ли нам верить в «однородность аллокортекса»? Для справки, аллокортекс – что-то вроде упрощённой версии неокортекса с тремя слоями вместо шести; считается, что до того, как эволюционировал неокортекс, ранние амниоты имели только аллокортекс. Он, как и неокортекс, делает много всякого разного: у взрослых людей гиппокампус вовлечён в ориентирование в пространстве и эпизодическую память, а грушевидная кора – в обработку запахов. Так что тут можно сделать аналогичный аргумент про обучение с чистого листа.

Двигаясь дальше, я уже упоминал выше (и больше в Большой Картине Фазового Дофамина, а ещё в Посте №5, Разделе 5.4.1) идею (Ларри Свансона), что весь конечный мозг кажется организованным в три слоя – «кору», «полосатое тело» и «паллидум». Я пока говорил только про кору; что насчёт «однородности полосатого тела» и «однородности паллидума»? Не ожидайте найти посвящённый этому обзор – на самом деле, предыдущее предложение судя по всему первое, где встречаются эти словосочетания. Но в каждом из этих слоёв есть как минимум некоторые общие черты: например, средние шиповатые нейроны вроде бы есть по всему полосатому телу. И я продолжаю считать, что описанная мной в Большой Картине Фазового Дофамина (и Постах №5-№6) модель – осмысленное первое приближение того, как может сочетаться «всё, что мы знаем о полосатом теле и паллидуме» с «несколькими вариациями конкретных алгоритмов обучения с чистого листа».

В случае мозжечка, есть по крайней мере какая-то литература по гипотезе однородности (ищите термин «universal cerebellar transform»), но, опять же, нет консенсуса. Мозжечок взрослого так же вовлечён в явно разные функции вроде моторной координации, языка, сознания и эмоций. Я лично считаю, что там тоже есть однородность, подробнее будут в Посте №4.

2.5.4 Локально-случайное разделение паттернов

Это другая причина, по которой лично я готов многое поставить на то, что конечный мозг и мозжечок обучаются с нуля. Она несколько специфична, но для меня довольно заметна; посмотрим, примете ли вы её.

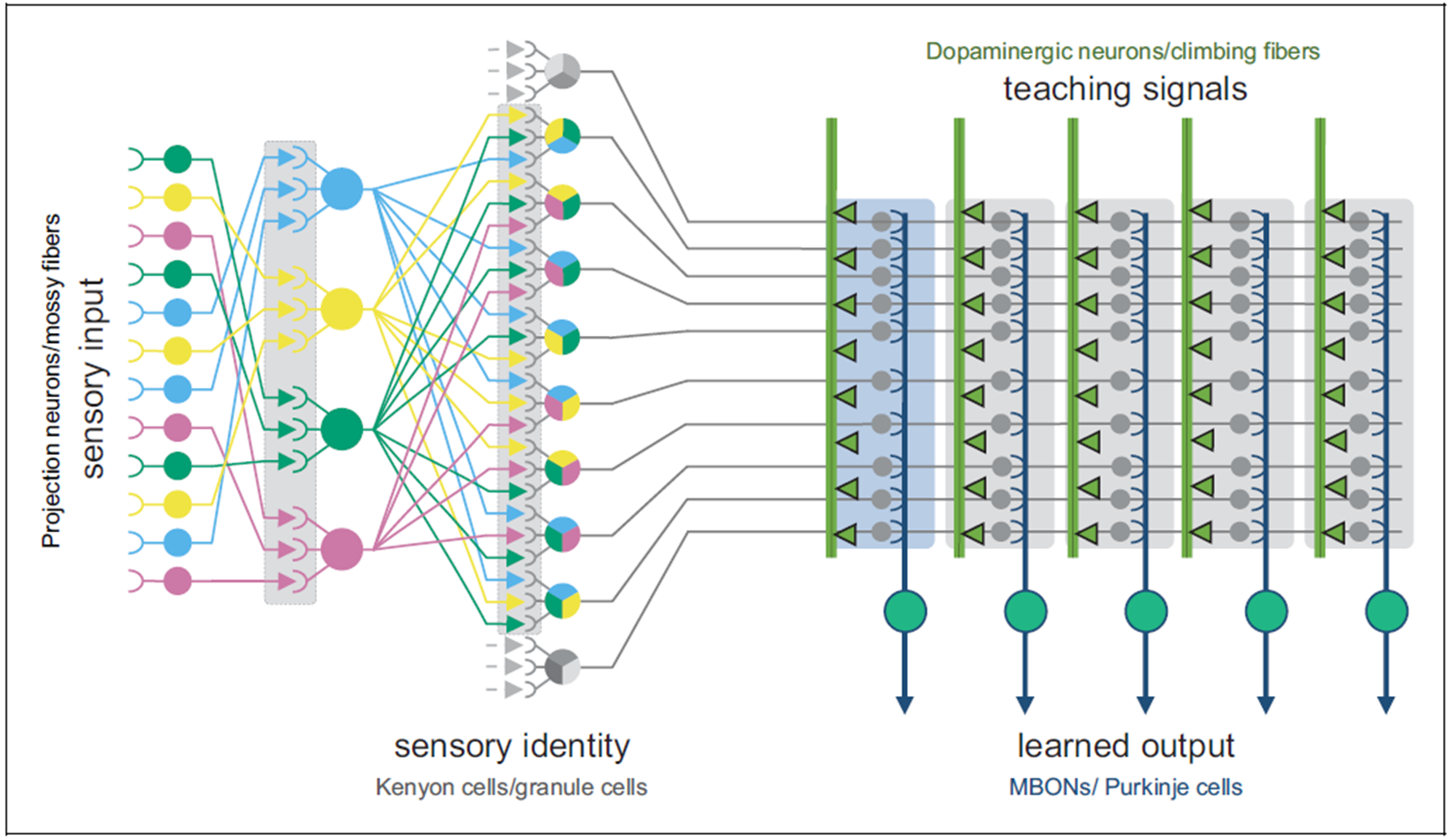

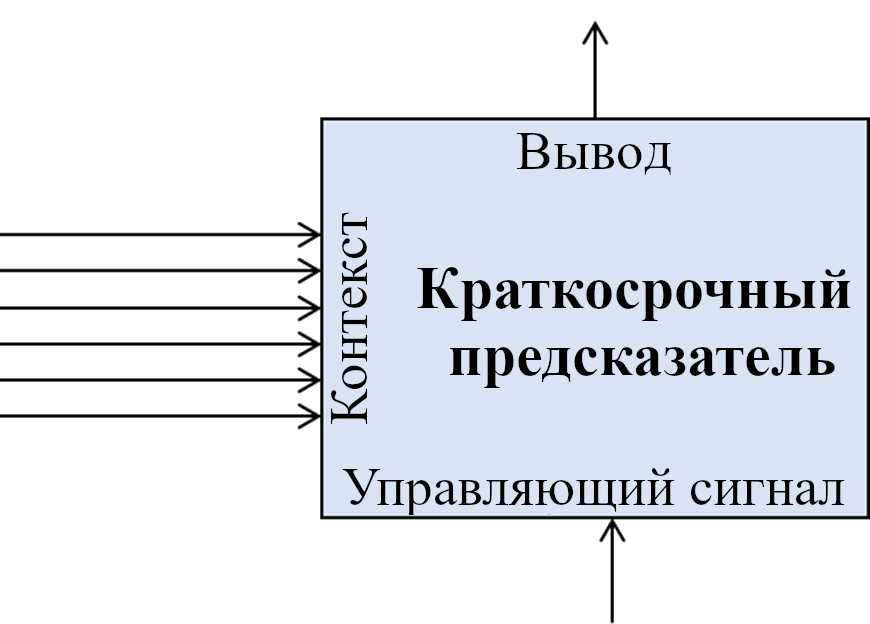

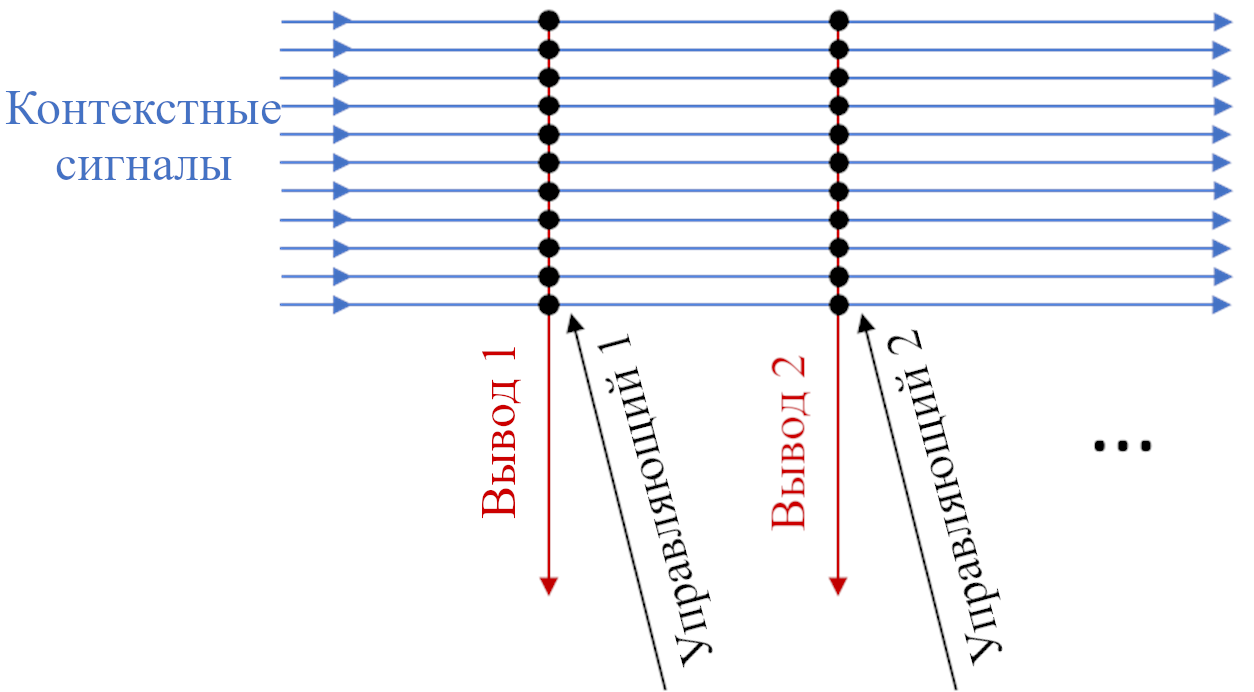

2.5.4.1 Что такое разделение паттернов?

В мозгу есть частый мотив, называемый «разделением паттернов». Давайте я объясню, что это и откуда берётся.

Представьте, что вы инженер машинного обучения, работающий на сеть ресторанов. Ваш начальник даёт вам задание предсказать продажи для разных локаций, куда можно распространить франшизу.

Первое, что вы можете сделать – это собрать кучу потоков данных – местные уровни безработицы, местные рейтинги ресторанов, местные цены в магазинах, распространяется ли по миру сейчас новый коронавирус, и т.д. Я называю это «контекстные данные». Вы можете использовать контекстные данные как ввод нейросети. Выводом сети должно быть предсказание уровня продаж. Вы подправляете веса нейросети (используя обучения с учителем, собрав данные от существующих ресторанов), чтобы всё получилось. Никаких проблем!

Разделение паттернов – это когда вы добавляете в начало ещё один шаг. Вы берёте различные потоки контекстных данных и случайно комбинируете их многими разными способами. Затем вы добавляете немного нелинейности, и вуаля! Теперь у вас есть куда больше потоков контекстных данных, чем было изначально! Теперь они могут быть вводом для обучаемой нейросети.[4]

Иллюстрация (части) обработки сенсорных данных плодовой мухи. Высокий вертикальный серый прямоугольник чуть левее центра – это слой «разделения паттернов»; он принимает организованные сенсорные сигналы слева и перемешивает их большим количеством разных (локально) случайных комбинаций. Потом они посылаются направо, чтобы служить «контекстными» вводами модуля обучения с учителем. Источник картинки: Ли и пр..

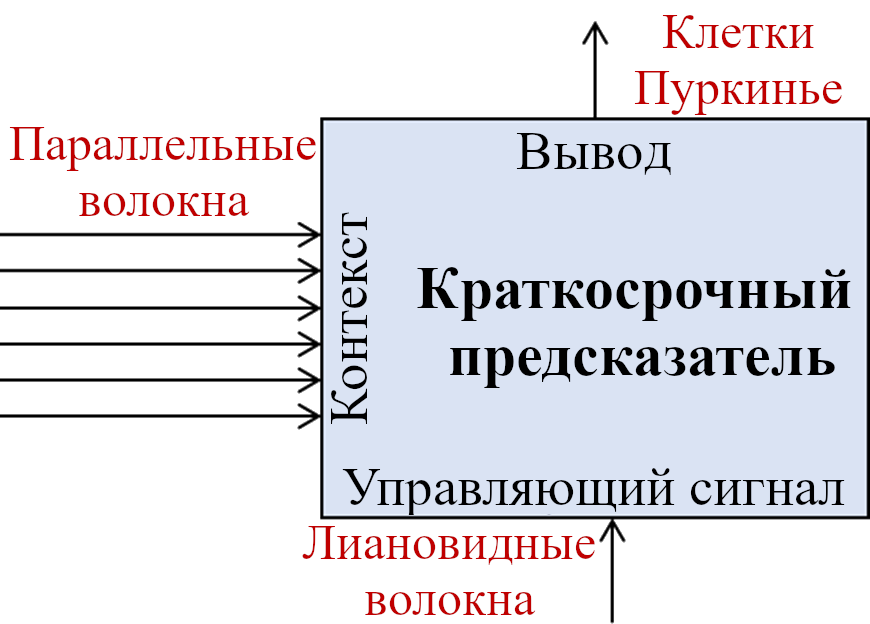

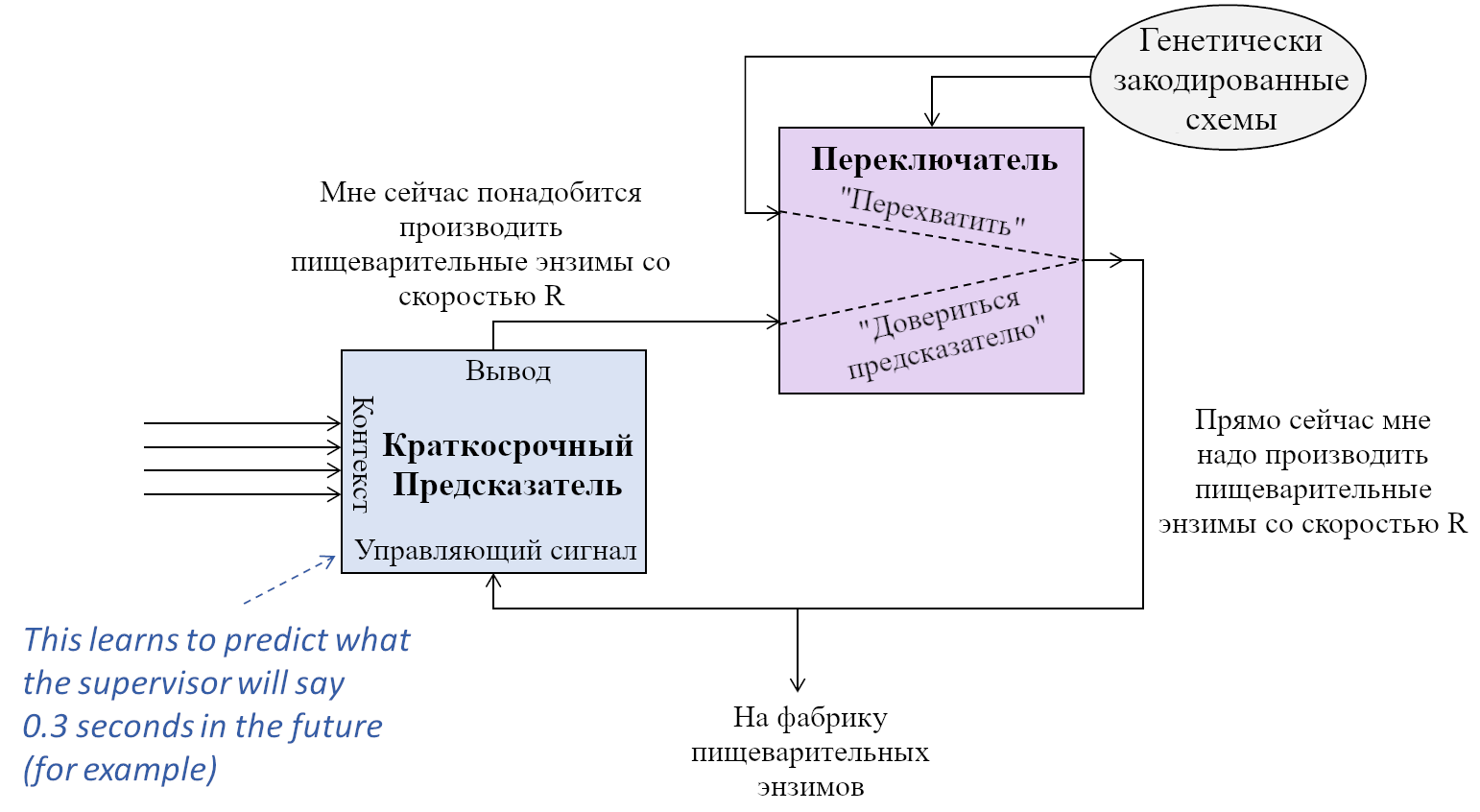

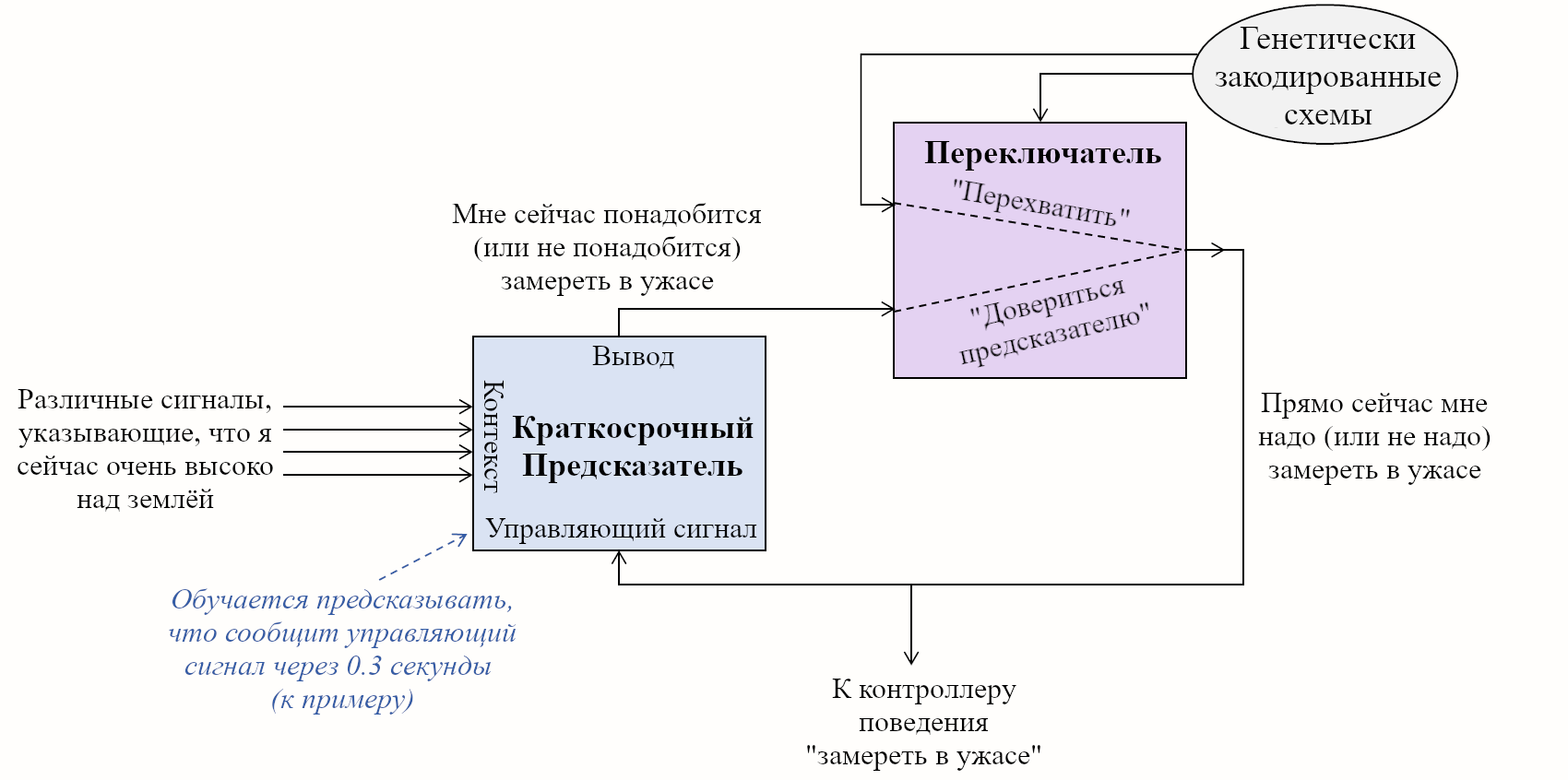

3. Две Подсистемы: Обучающаяся и Направляющая

- 1.3.1 Краткое содержание / Оглавление

- 2.3.2 Большая картина

- 3.3.3 «Теория Триединого Мозга» неверна, но давайте не выплёскивать ребёнка вместе с водой

- 4.3.4 Три типа составных частей Направляющей Подсистемы

- 4.1.3.4.1 Общая таблица

- 4.2.3.4.2 В сторону: что я имею в виду под «стремлениями»?

- 4.3.3.4.3 Категория A: Штуки, которая Направляющая Подсистема должна делать для достижения обобщённого интеллекта (например, стремление к любопытству)

- 4.4.3.4.4 Категория B: Всё остальное из человеческой Направляющей Системы (например, стремления, связанные с альтруизмом)

- 4.5.3.4.5 Категория C: Любые другие возможности (например, стремление увеличить баланс на банковском счёте)

- 5.3.5 Подобные-мозгу СИИ будут по умолчанию иметь радикально нечеловеческие (и опасные) мотивации

- 6.3.6 Ответ на аргументы Джеффа Хокинса против риска происшествий с СИИ

- 7.3.7 Сроки-до-подобного-мозгу-СИИ, часть 2 из 3: насколько сложен достаточный для СИИ реверс-инжиниринг Направляющей Подсистемы??

- 8.3.8 Сроки-до-подобного-мозгу-СИИ, часть 3 из 3: масштабирование, отладка, обучение, и т.д.

- 9.3.9 Сроки-до-подобного-мозгу-СИИ, ещё: Что мне чувствовать по поводу вероятностей?

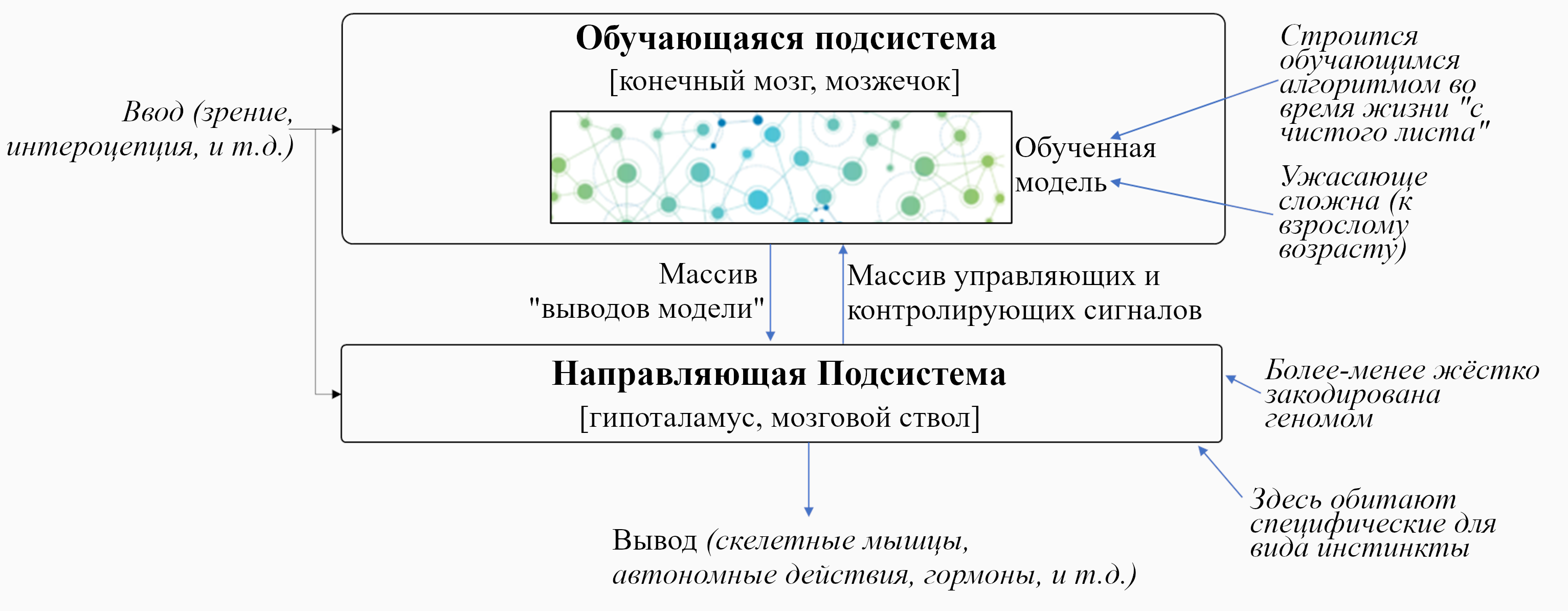

3.1 Краткое содержание / Оглавление

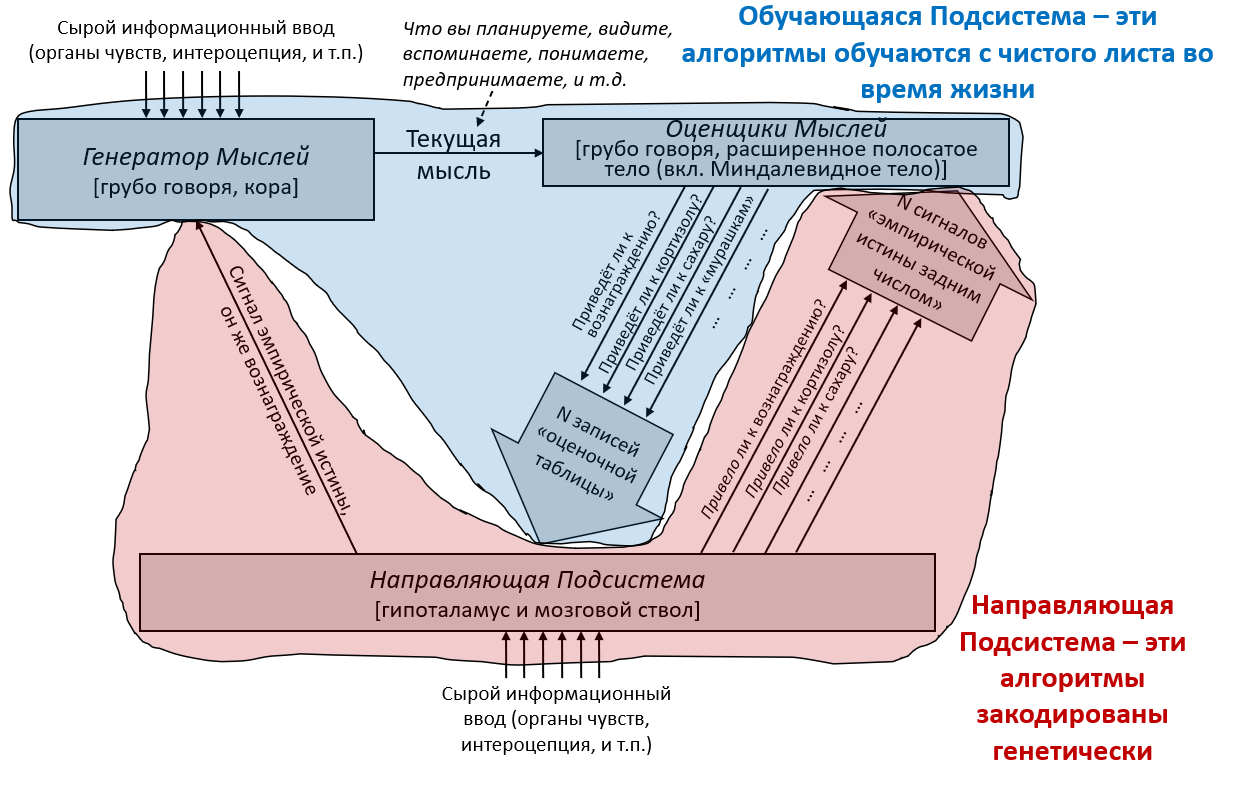

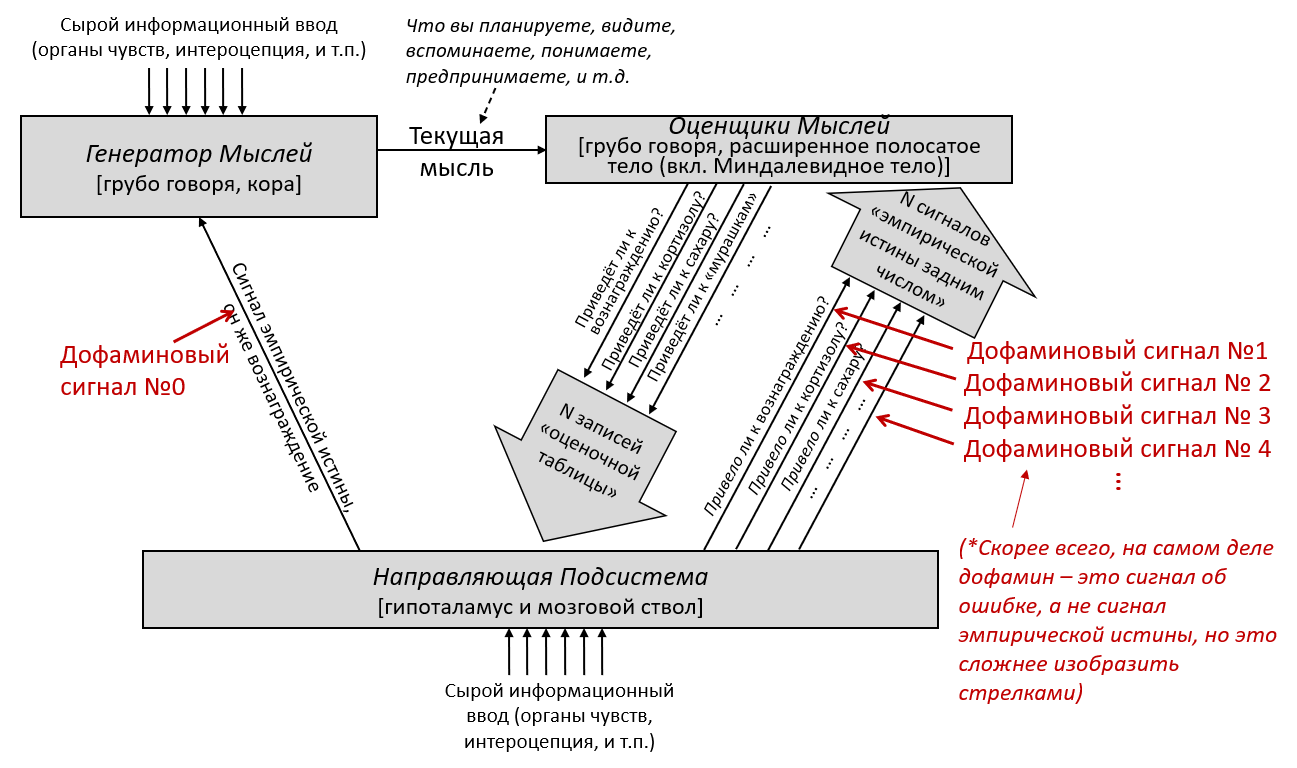

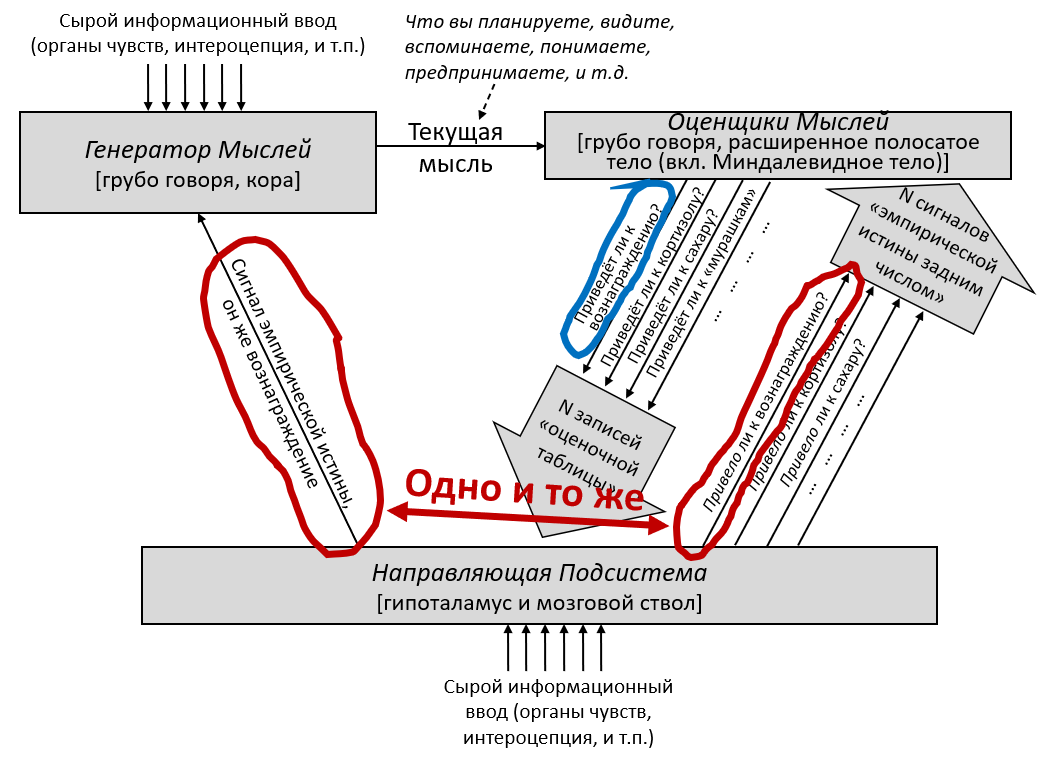

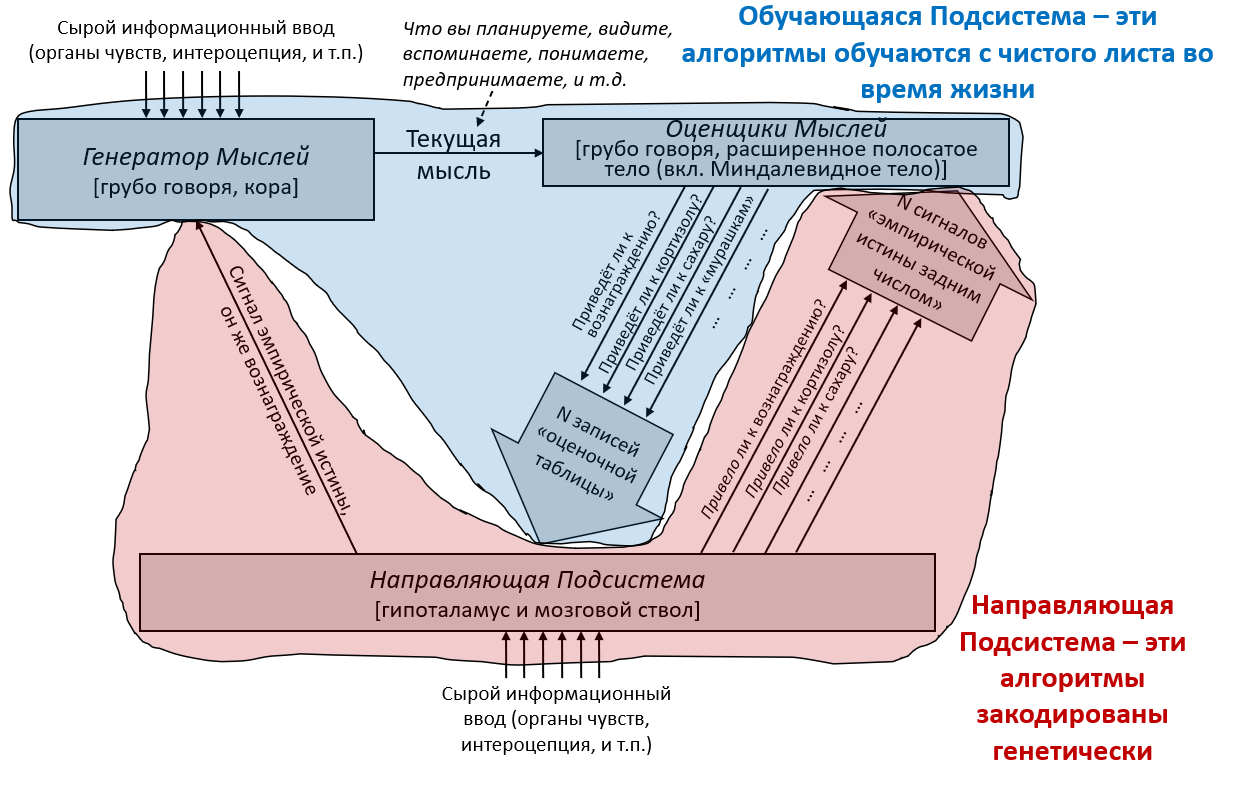

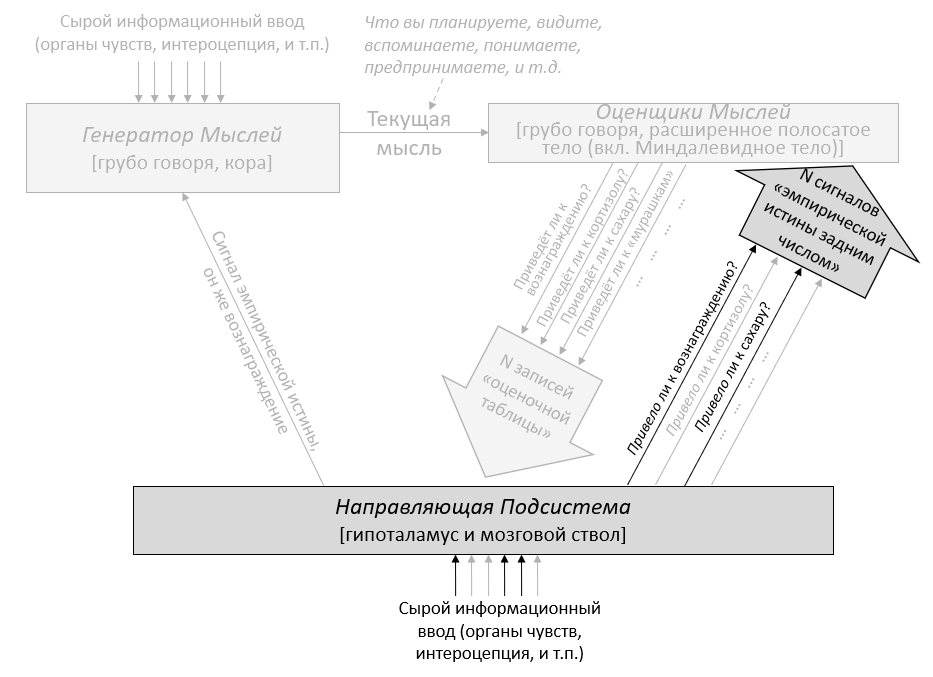

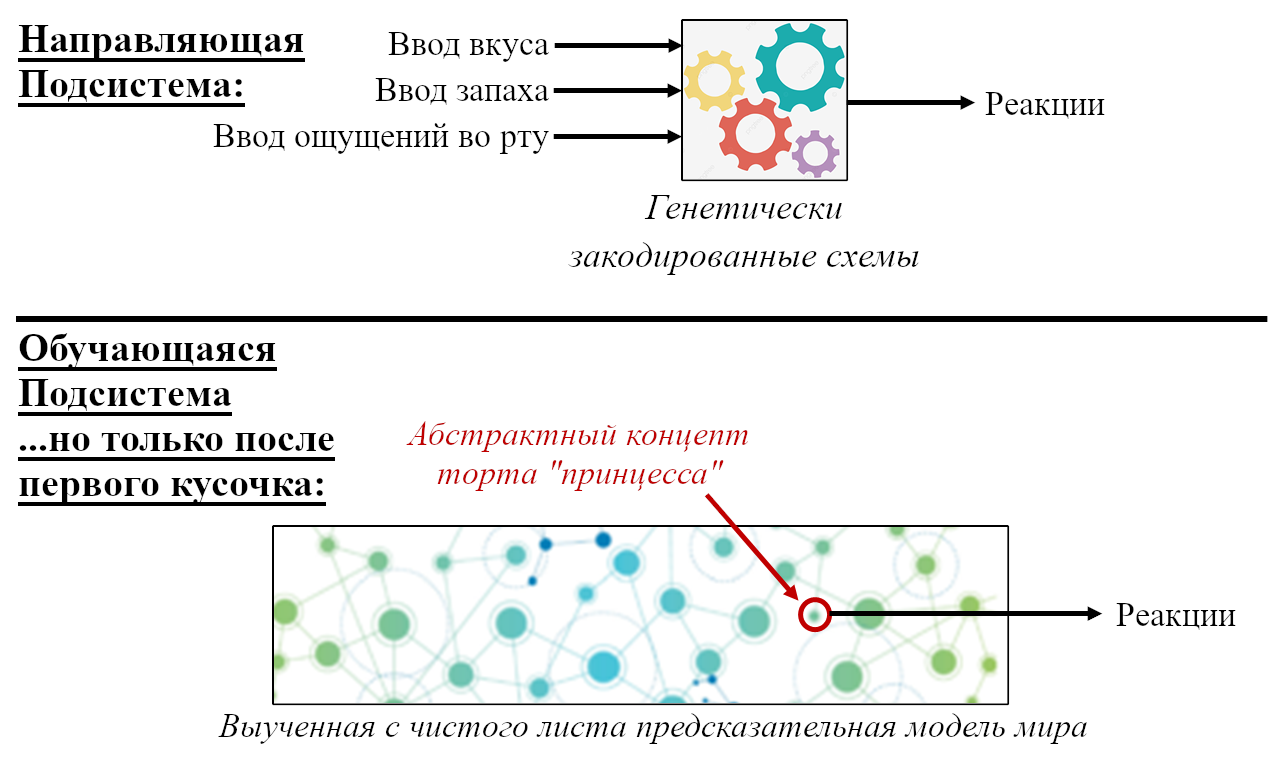

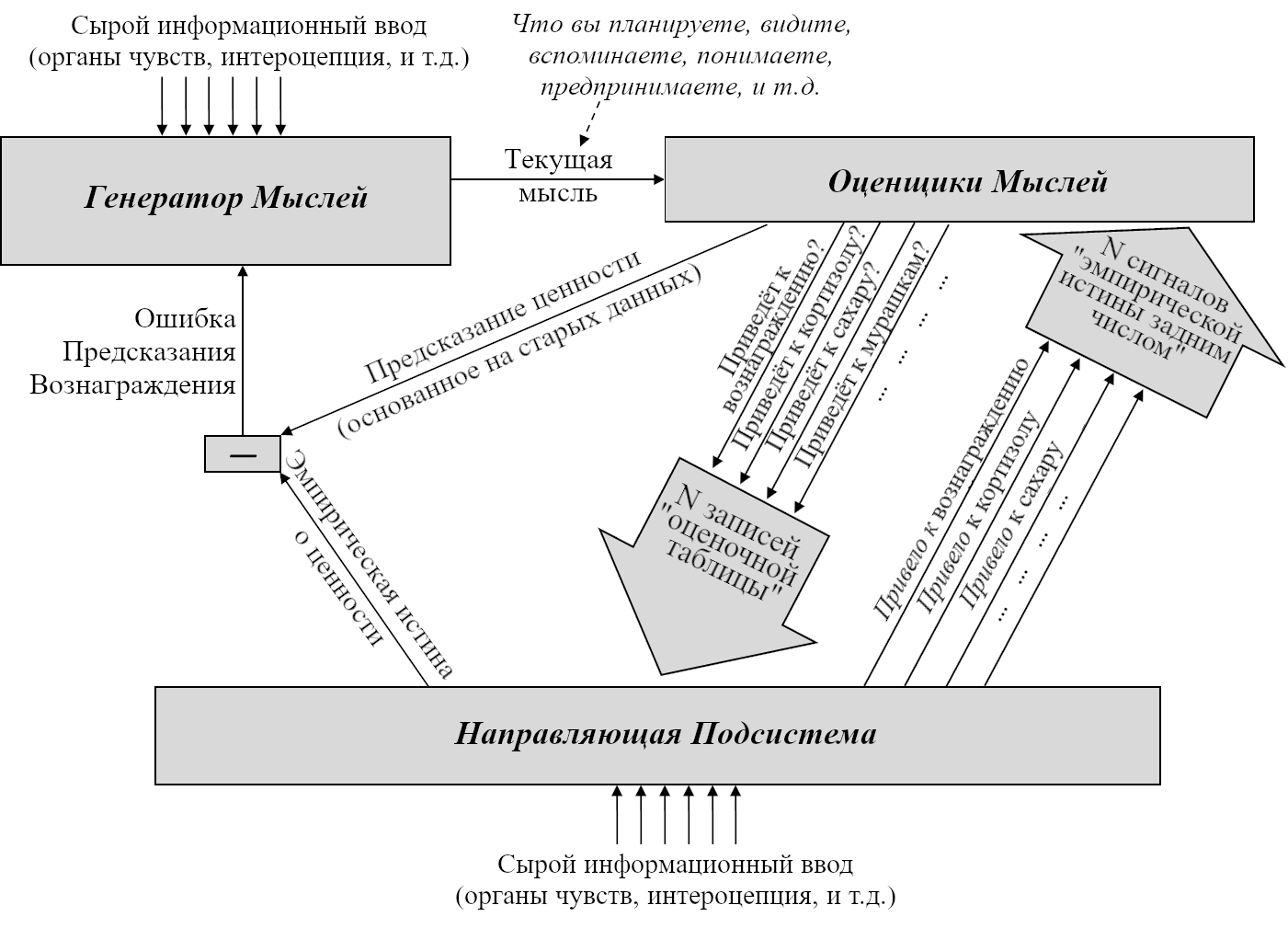

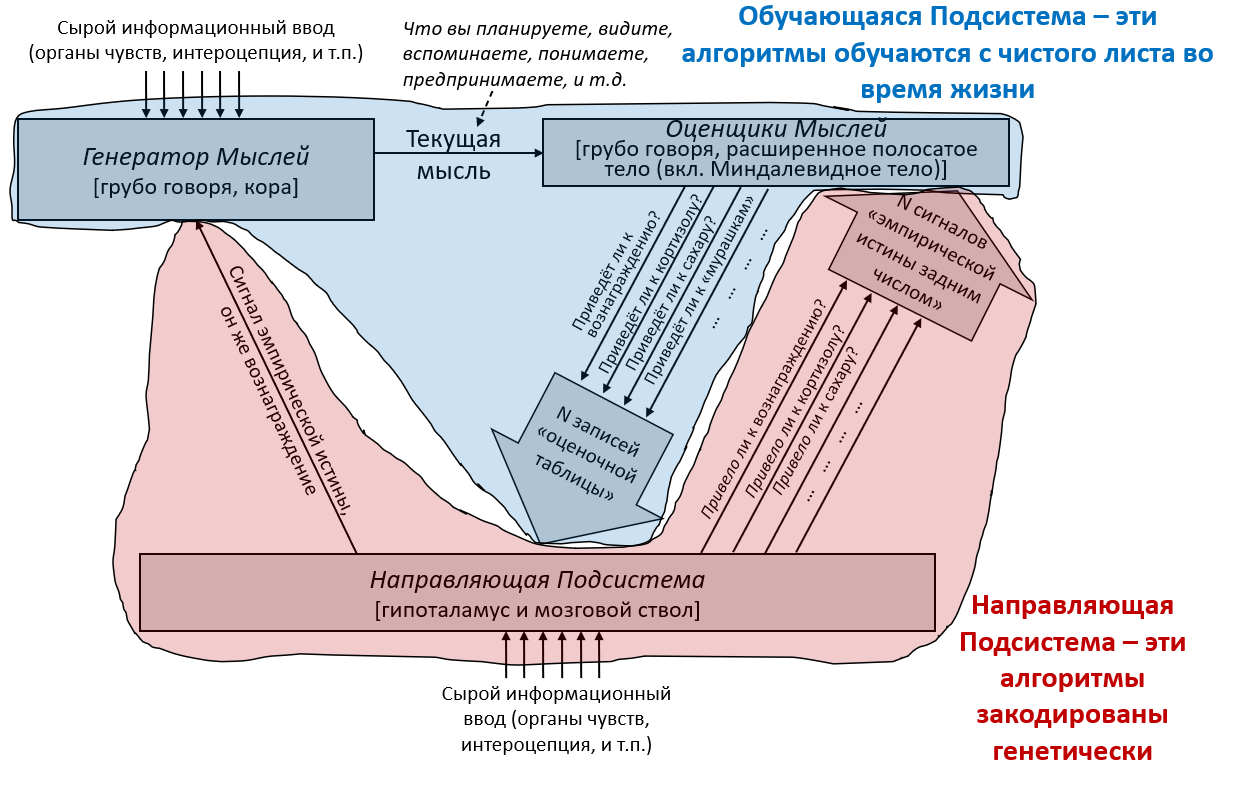

В предыдущем посте я определил понятие «обучающихся с чистого листа» алгоритмов – широкую категорию, включающую, помимо прочего, любой алгоритм машинного обучения (неважно, насколько сложный) с случайной инициализацией и любую систему изначально пустой памяти. Я затем предложил разделение мозга на две части по признаку наличия или отсутствия обучения с чистого листа. Теперь я даю им имена:

Обучающаяся Подсистема – это 96% мозга, «обучающиеся с чистого листа» – по сути – конечный мозг и мозжечок.

Направляющая Подсистема – это 4% мозга, не «обучающиеся с чистого листа» – по сути – гипоталамус и мозговой ствол.

(См. Предыдущий пост за более подробным анатомическим разделением.)

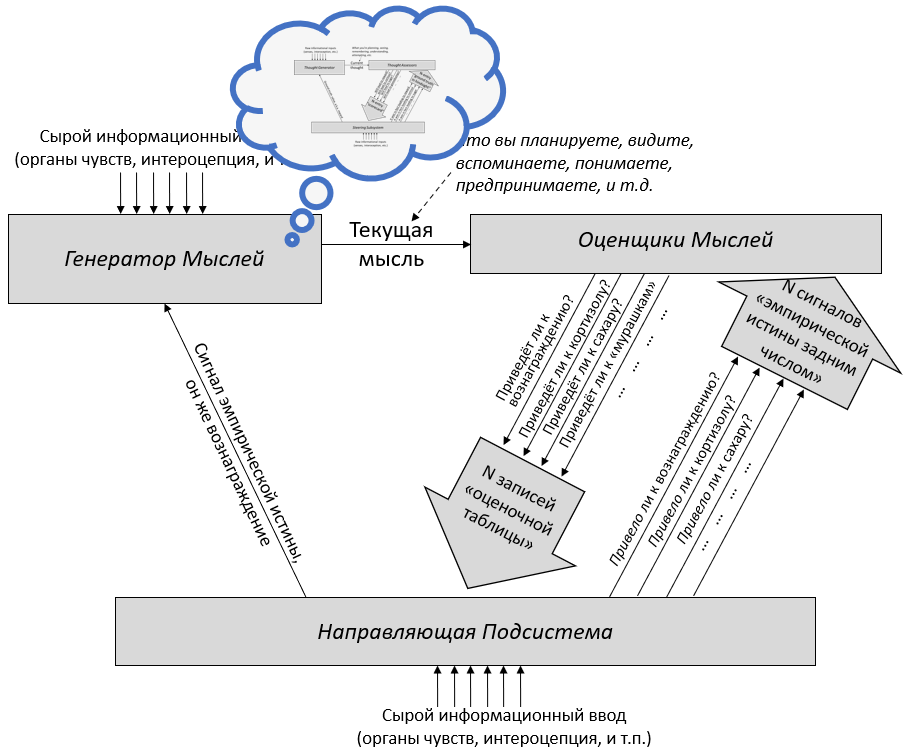

Этот пост будет обсуждением этой картины двух подсистем в целом и Направляющей Подсистемы в частности.

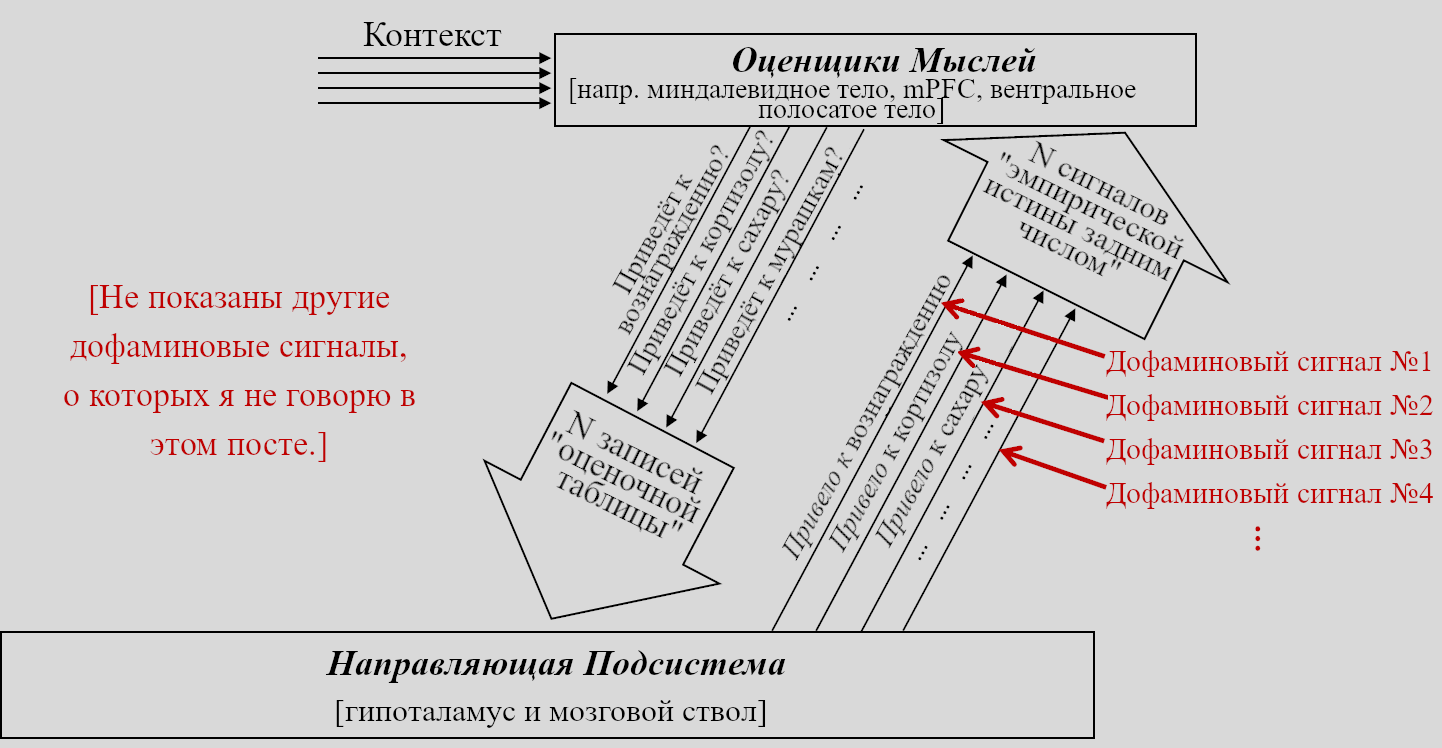

- В Разделе 3.2 я поговорю о большой картине того, что эти подсистемы делают и как они взаимодействуют. Как пример, я объясню, почему каждая подсистема нуждается в своей собственной обработке сенсорных сигналов – к примеру, почему визуальный ввод обрабатывается и в зрительной коре в Обучающейся Подсистеме, и в верхнем двухолмии в Направляющей Подсистеме.

- В Разделе 3.3 я признаю, что эта картина двух подсистем имеет некоторые сходства с дискредитированной «теорией триединого мозга». Но я буду утверждать, что проблемы теории триединого мозга не относятся к моей картине двух подсистем.

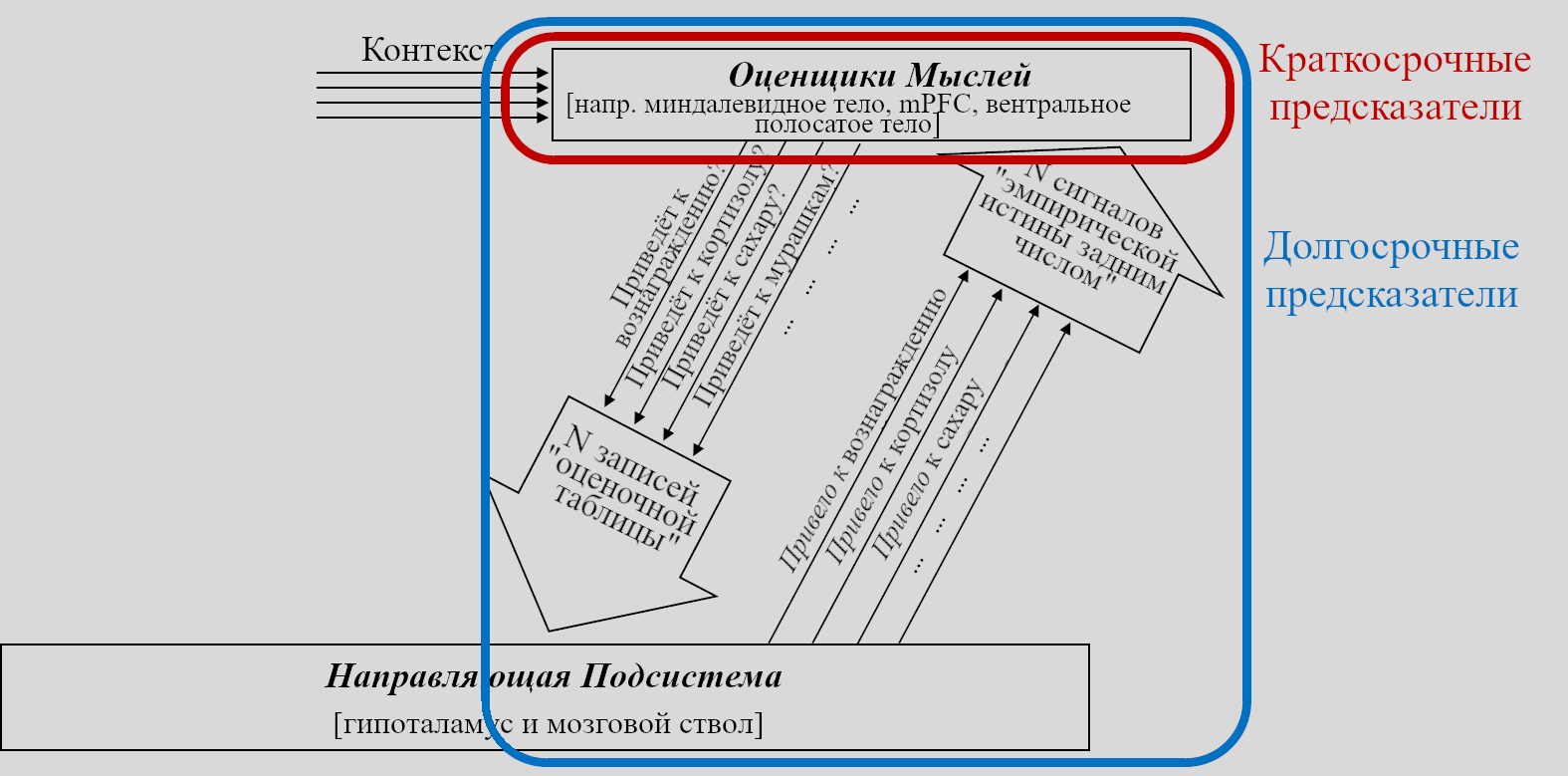

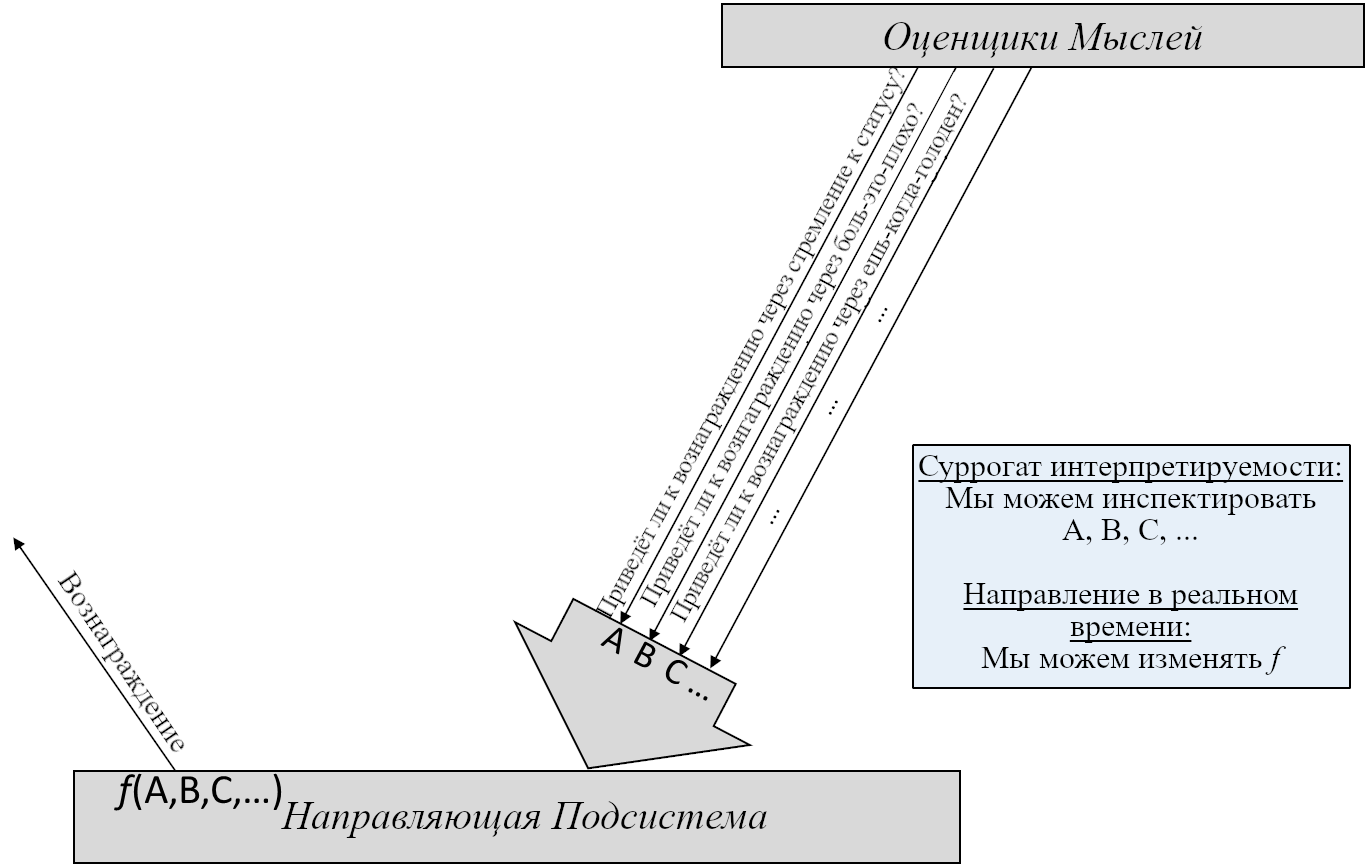

- В Разделе 3.4 я опишу три категории того, что может относиться к Направляющей Подсистеме:

- Категория A: Штуки, правдоподобно необходимые для обобщённого интеллекта (например, встроенная склонность к любопытству),

- Категория B: Иные штуки в человеческой направляющей подсистеме (например, встроенная склонность быть добрым к своим друзьям),

- Категория C: Всё, что может представить программист СИИ, даже если это радикально отличается от того, что встречается у людей и животных (например, встроенная склонность корректно предсказывать цены акций).

- В Разделе 3.5 я свяжу эти категории с тем, как я ожидаю будет выглядеть создание людьми подобного-мозгу СИИ, и обосную, что «подобный-мозгу СИИ с радикально нечеловеческими (и опасными) мотивациями» – не оксюморон, а, напротив, ожидаемый по умолчанию исход, если мы не потрудимся, чтобы его предотвратить.

- В Разделе 3.6 я рассмотрю тот факт, что у Джеффа Хокинса есть мнение о двух подсистемах, похожее на мою картину, но он спорит с тем, что катастрофические происшествия с СИИ представляют риск. Я скажу, где, как я считаю, он неправ.

- Разделы 3.7 и 3.8 будут последними двумя частями моего обсуждения «сроков до подобного-мозгу СИИ». Первой частью был Раздел 2.8 предыдущего поста, где я заявил, что реверс-инжиниринг Обучающейся Подсистемы (достаточный для подобного-мозгу СИИ) может правдоподобно произойти довольно скоро, в следующие два десятилетия, хотя это может и занять больше времени. Тут я дополню это заявлением, что-то же верно и для реверс-инжиниринга Направляющей Подсистемы, и для усовершенствования и масштабирования алгоритмов, проведения обучения модели, и т.д.

- Раздел 3.9 – быстрое не-техническое обсуждение того, как невероятно расходятся мнения разных людей по поводу сроков до СИИ, даже когда они согласны по поводу вероятностей. К примеру, можно найти двух людей, которые согласятся, что с шансами 3 к 1 СИИ не будет до 2042 года, но один может подчёркивать, как вероятность низка («Видишь? СИИ скорее всего не будет ещё десятилетия»), тогда как другой – как высока эта вероятность. Я поговорю немного о факторах, скрывающихся за этими отношениями.

3.2 Большая картина

В предыдущем посте я заявил, что 96% объёма мозга – грубо говоря, конечный мозг (неокортекс, гиппокампус, миндалевидное тело, большая часть базальных ганглиев, и ещё кое-что) и мозжечок – «обучаются с чистого листа» в том смысле, что на ранних этапах жизни их выводы – случайный мусор, но со временем они становятся невероятно полезны благодаря прижизненному обучению. (См. там больше подробностей) Я сейчас называю эту часть мозга Обучающейся Подсистемой.

Остальной мозг – в основном мозговой ствол и гипоталамус – я называю Направляющей Подсистемой.

Как нам об этом думать?

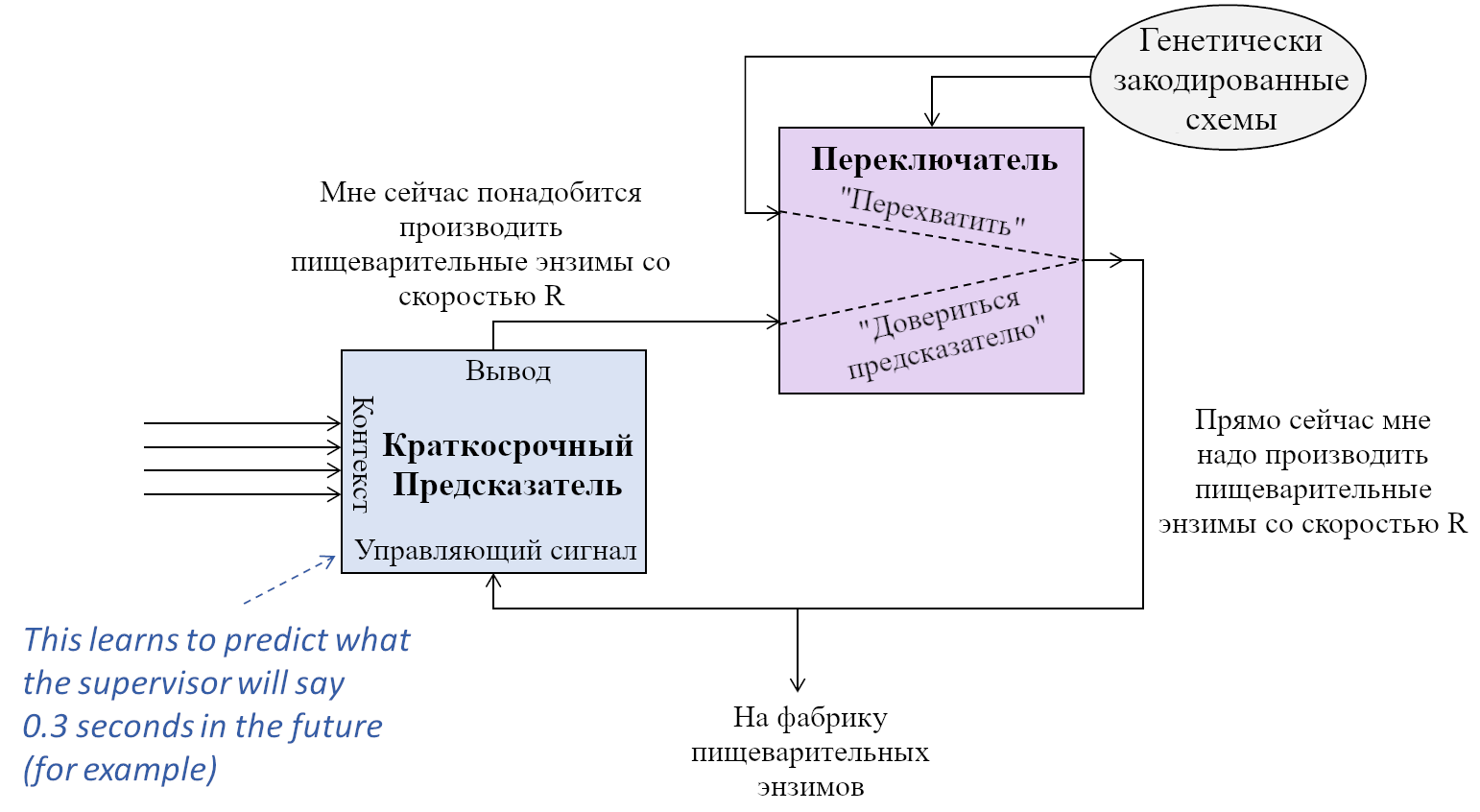

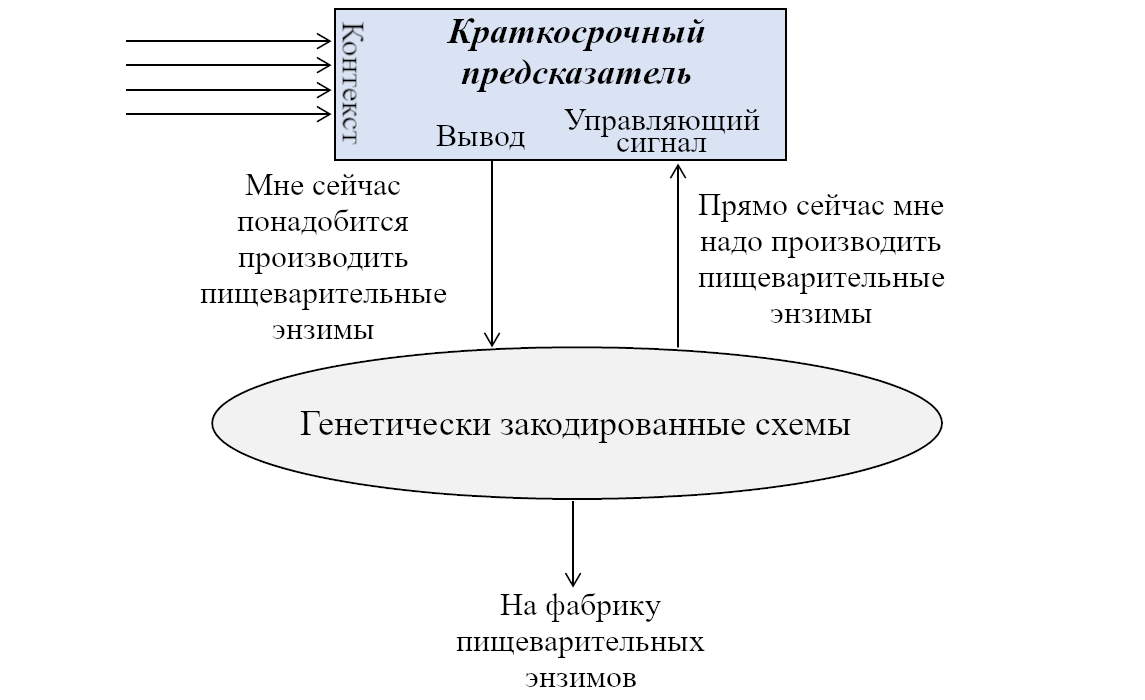

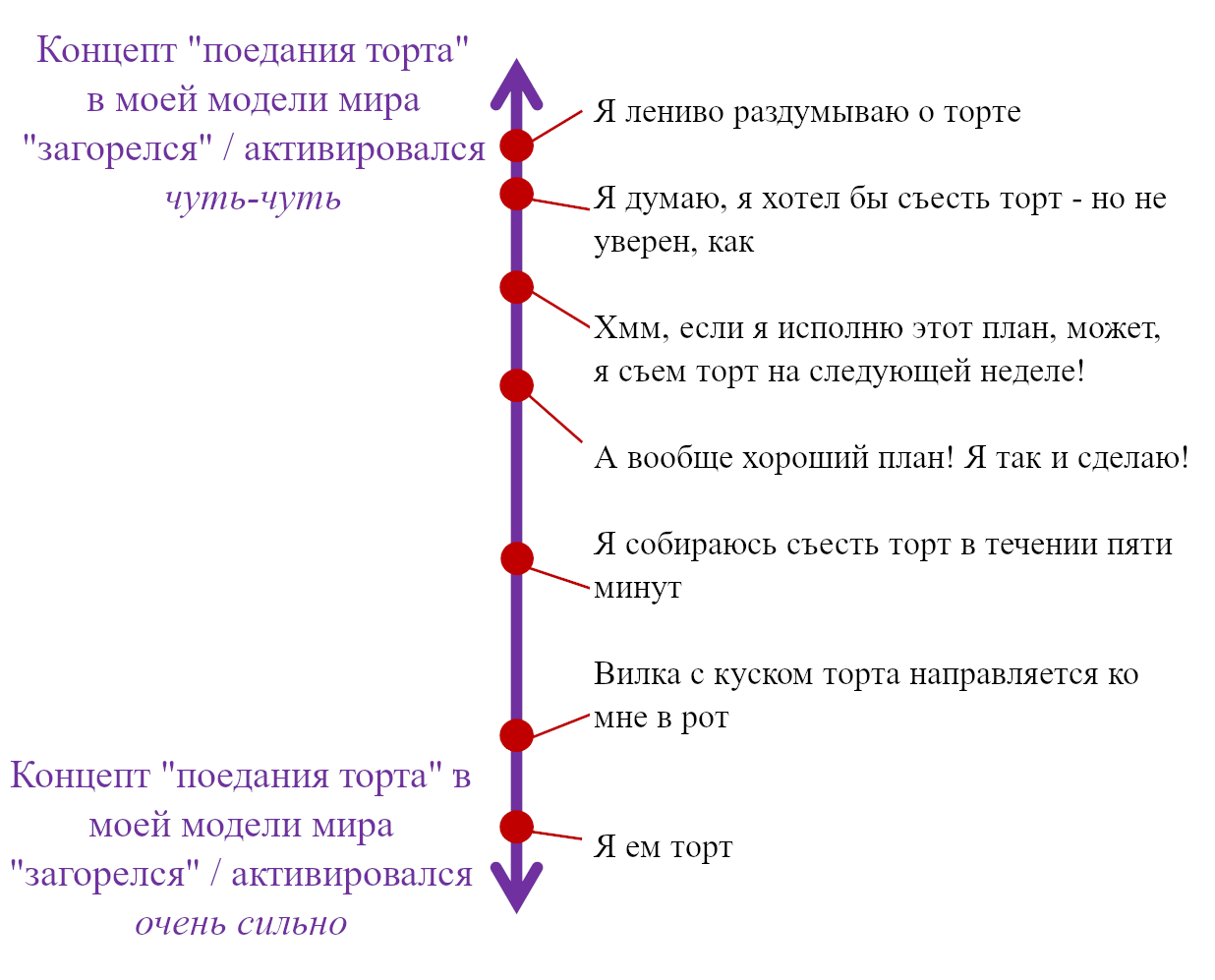

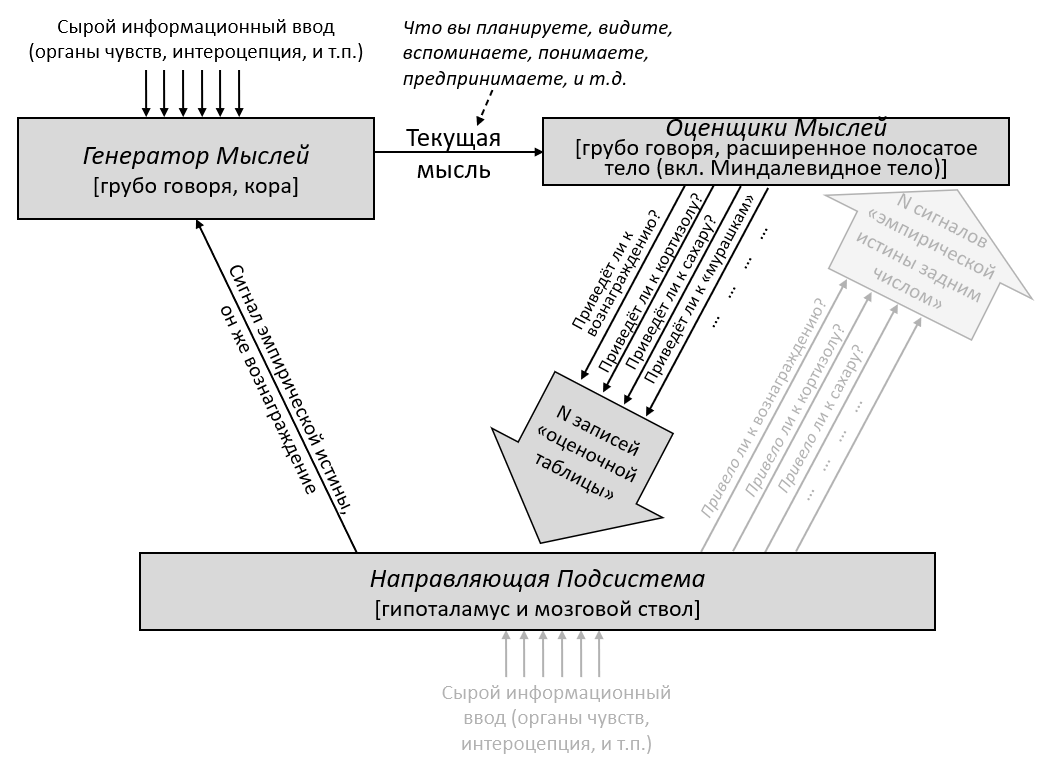

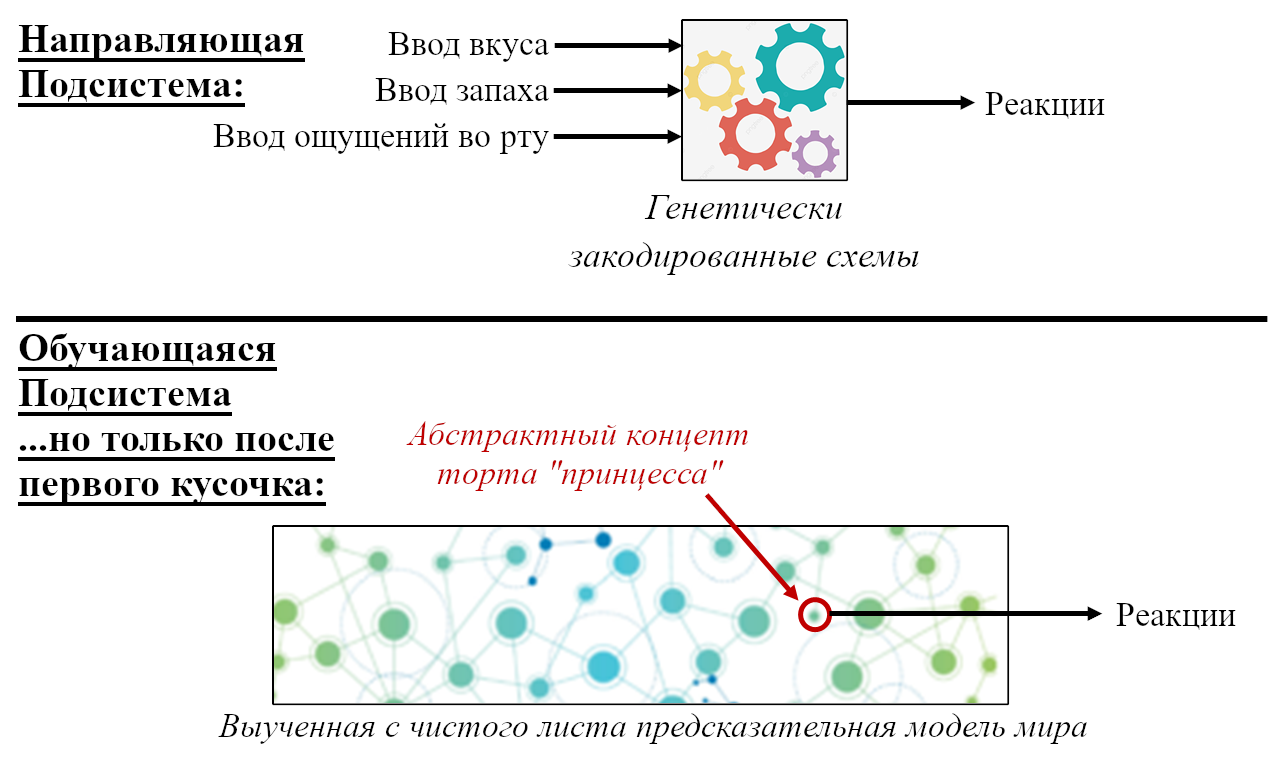

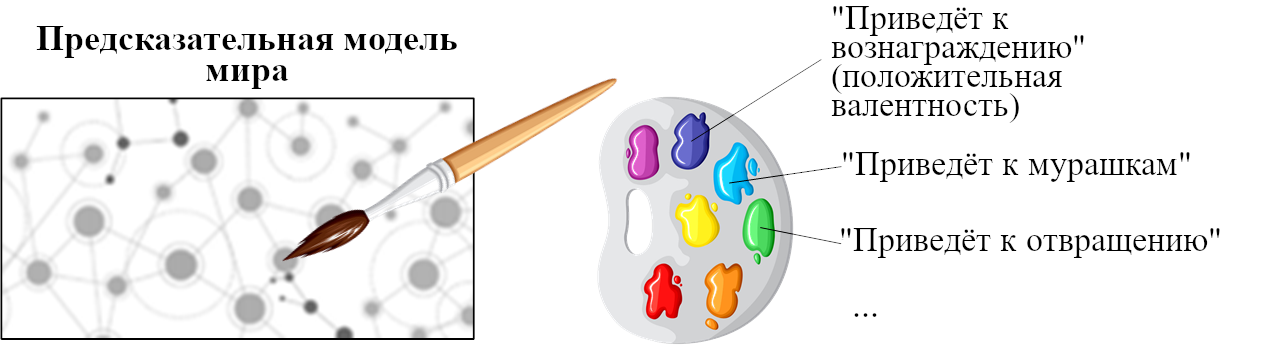

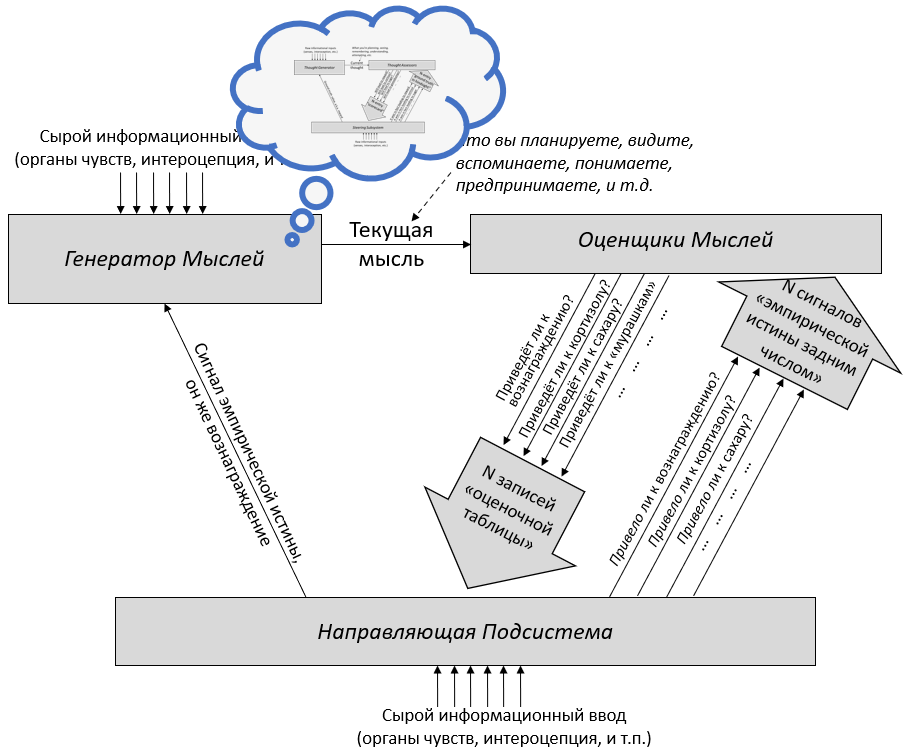

Давайте начнём с Обучающейся Подсистемы. Как я описывал в предыдущем посте, эта подсистема имеет некоторое количество взаимосвязанных встроенных алгоритмов обучения, встроенную нейронную архитектуру и встроенные гиперпараметры. Она имеет также много (миллиарды или триллионы) подстраиваемых параметров (обычно предполагается, что это сила синаптических связей, но это спорный момент, и я не буду в него погружаться), и значения этих параметров изначально случайны. Так что изначально Обучающаяся Подсистема выдаёт случайные бесполезные для организма выводы – например, может быть, они могут заставить организм дёргаться. Но со временем различные управляющие сигналы и соответствующие правила обновления подправляют настраиваемые параметры системы, что позволяет её за время жизни животного научиться делать сложные биологически-адаптивные штуки.

Дальше: Направляющая Подсистема. Как нам её интуитивно представлять?

Для начала, представьте хранилище с кучей специфичных для вида инстинктов и поведений, жёстко закодированных в геноме:

- «Чтобы блевануть, сжать мышцы A,B,C, и выпустить гормоны D,E,F.”

- «Если сенсорный ввод удовлетворяет таким-то эвристикам, то вероятно я ем что-то здоровое и энергоёмкое; это хорошо, и надо отреагировать сигналами G,H,I.”

- «Если сенсорный ввод удовлетворяет таким-то эвристикам, то наверное я склоняюсь над пропастью, это плохо, и надо отреагировать сигналами J,K,L.”

- «Если я замёрз, поднять волоски на теле.»