Согласование ИИ

Четыре предпосылки

- 1.Утверждение 1: У людей есть очень универсальная способность решать задачи и достигать целей в самых разных областях

- 2.Утверждение 2: ИИ может стать намного умнее людей

- 3.Утверждение 3: Если мы создадим высокоинтеллектуальные ИИ-системы, то их решения будут определять будущее

- 4.Утверждение 4: Высокоинтеллектуальный ИИ не будет полезен для человечества по умолчанию

Миссия MIRI – сделать так, чтобы создание искусственного интеллекта умнее человека привело к положительным последствиям. Почему эта миссия важна и почему мы считаем, что уже сегодня над этим можно работать?

В этом и в следующем эссе я попробую ответить на эти вопросы. Здесь я опишу четыре, по моему мнению, самые важные предпосылки, на основе которых появилась наша миссия. Я попытаюсь явно сформулировать утверждения, на которых базируется моё убеждение в том, что наша работа очень важна. Этому же вопросу посвящены, например, «Пять тезисов» Элиезера Юдковского и «Почему MIRI» Люка Мюльхаузера.

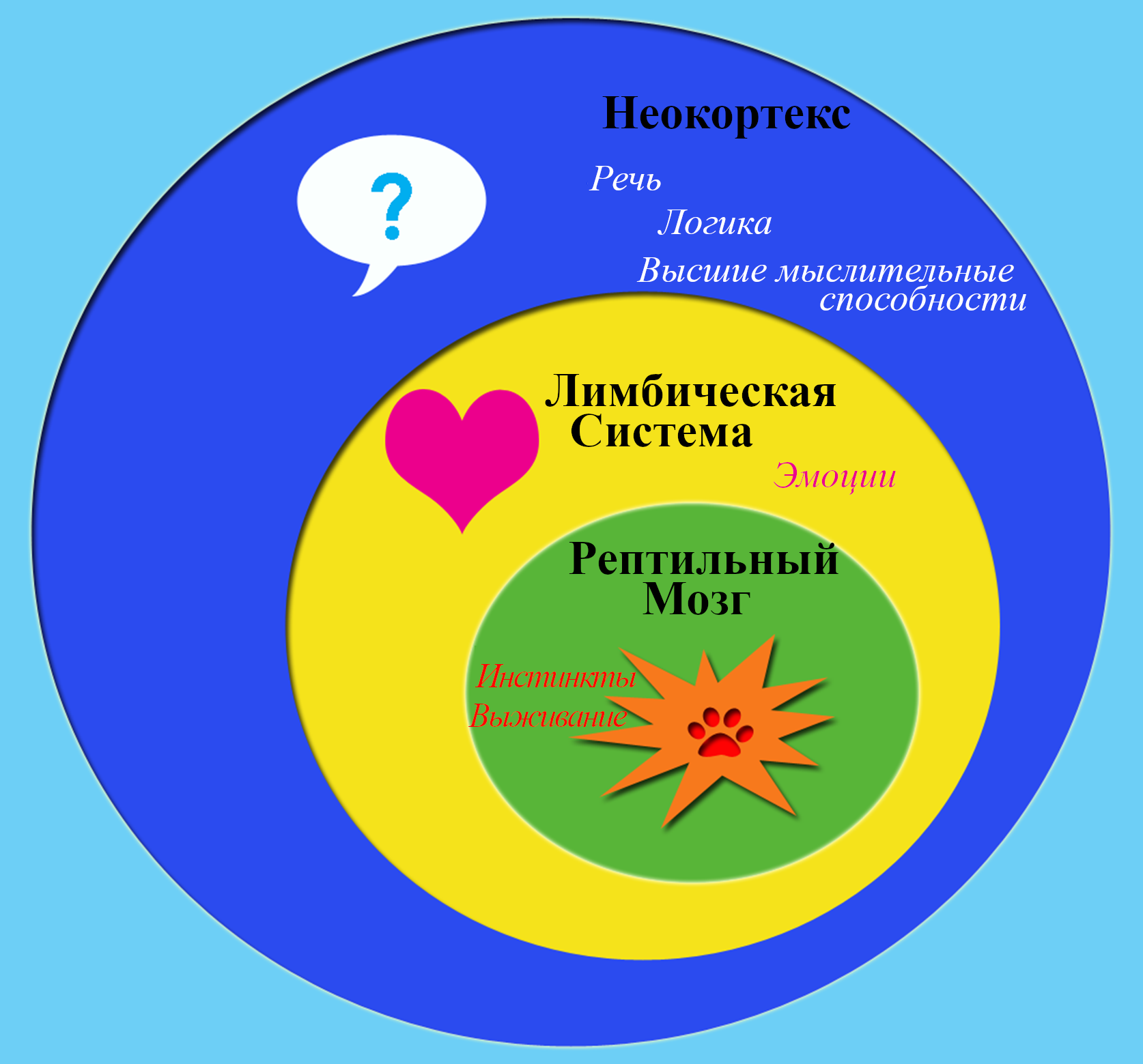

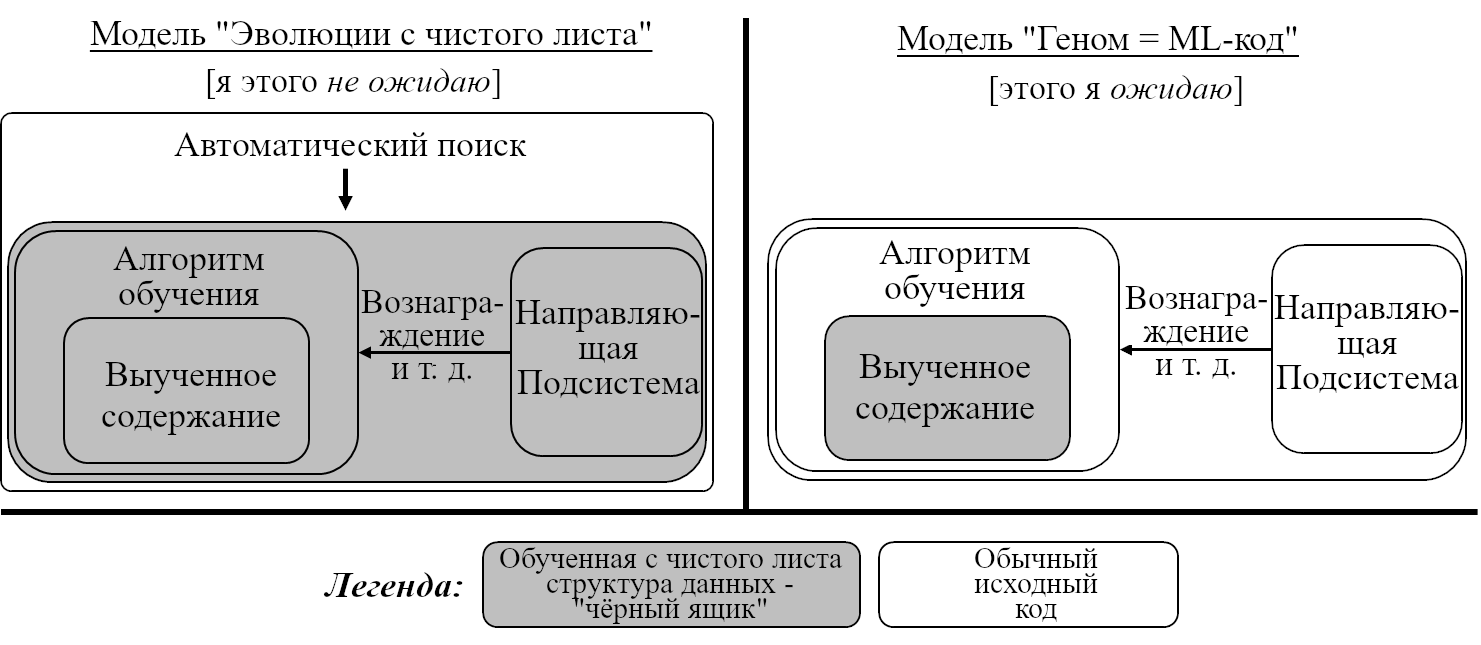

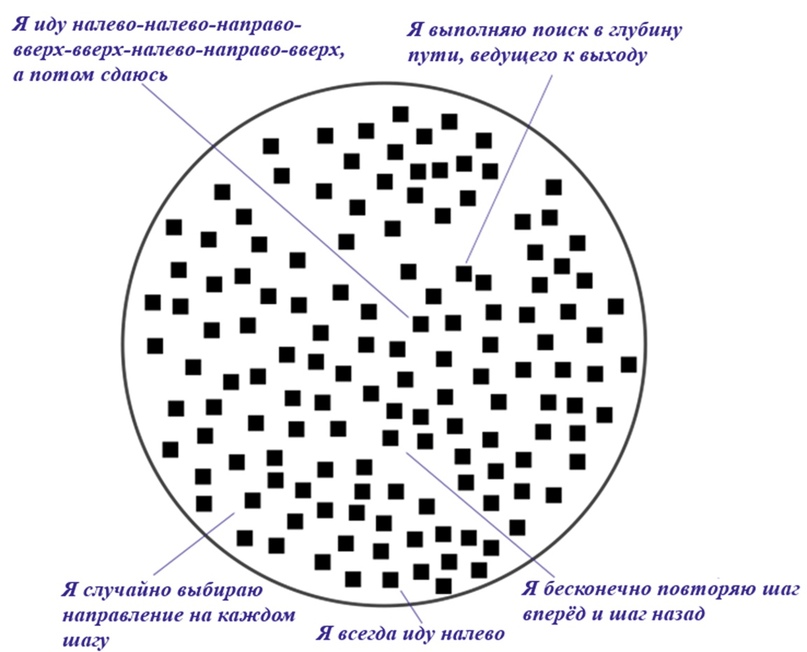

Утверждение 1: У людей есть очень универсальная способность решать задачи и достигать целей в самых разных областях

Мы называем эту способность «интеллектом» или «универсальным интеллектом». Это определение не является формальным: если бы мы точно знали, что такое интеллект, нам было бы гораздо легче запрограммировать его. Однако мы считаем, что такое явление как универсальный интеллект существует, пусть пока мы и не можем повторить его в коде.

Альтернативный взгляд: Универсального интеллекта не существует — вместо него у людей есть набор отдельных узкоспециализированных модулей. Компьютеры будут совершенствоваться в определённых узких задачах, таких как шахматы или вождение автомобиля, но никогда не станут универсальными, потому что универсальность недостижима. (Аргументы в пользу этой точки зрения приводил Робин Хансон.)

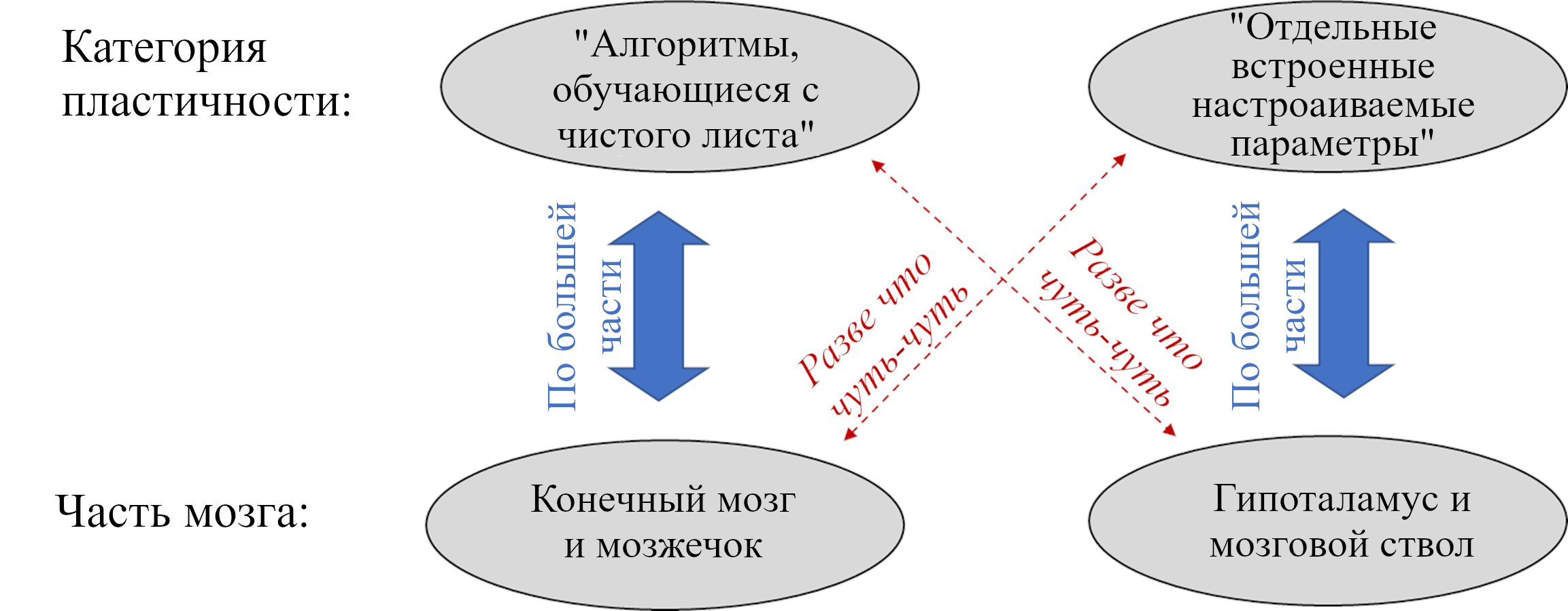

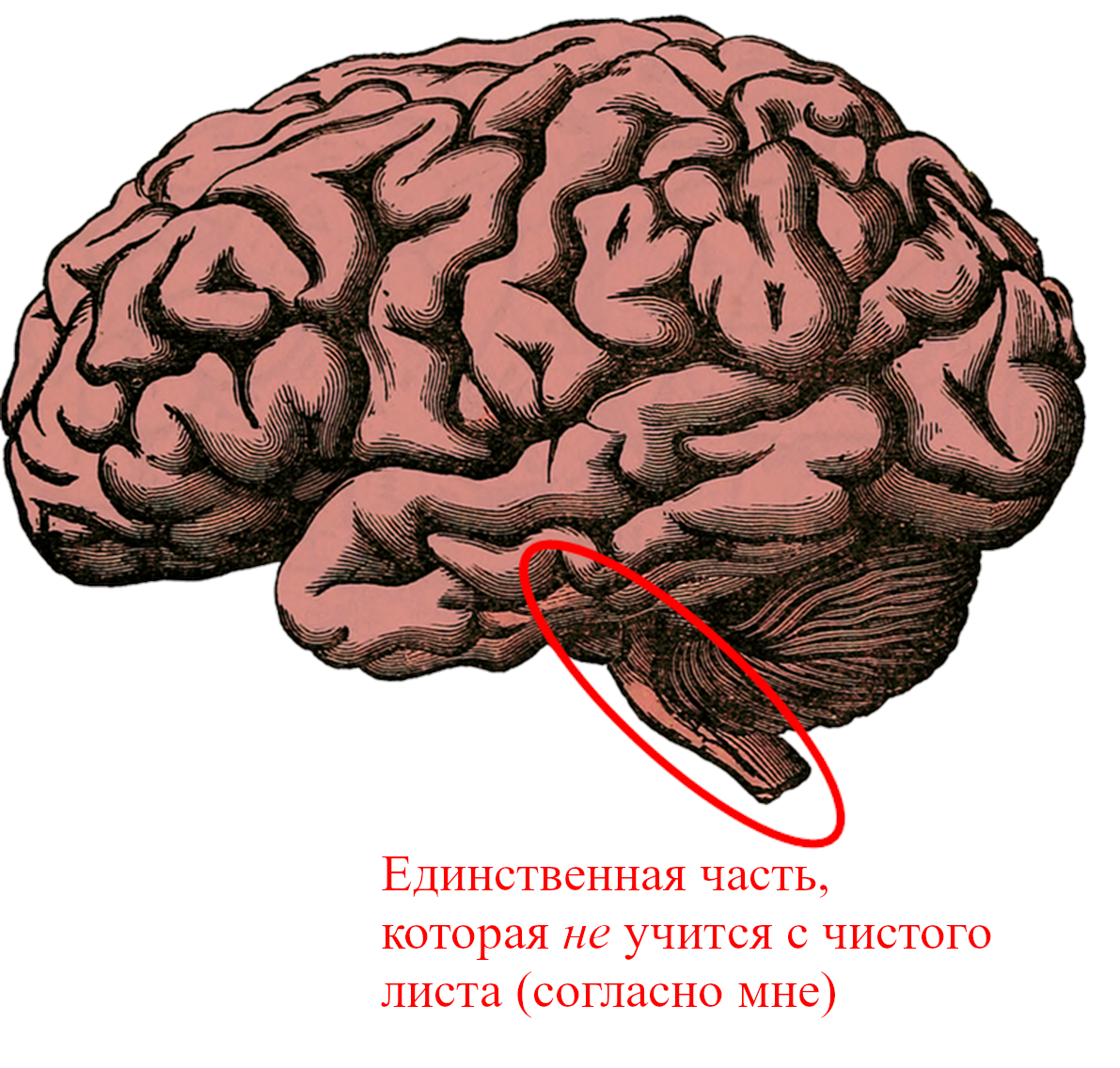

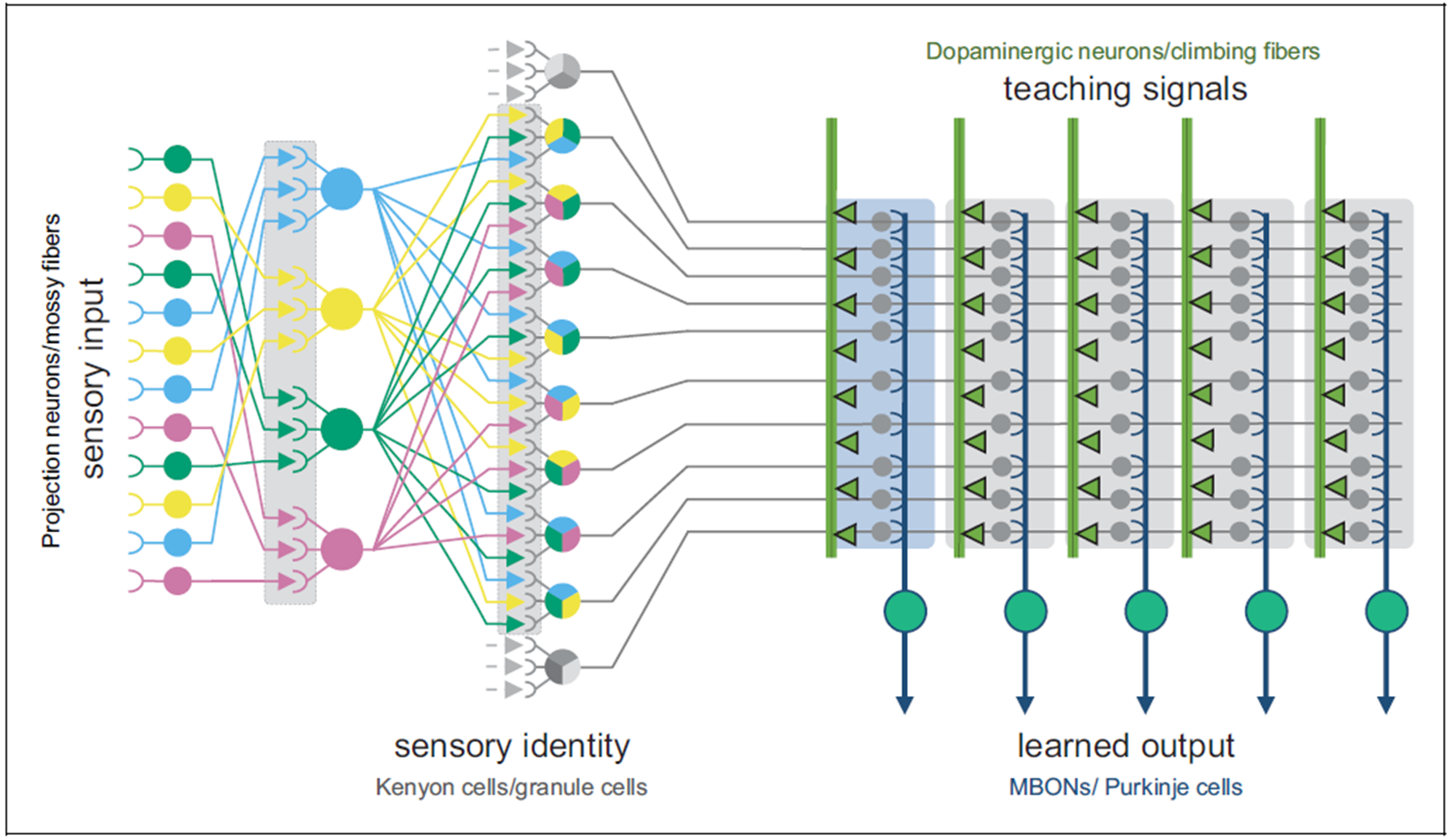

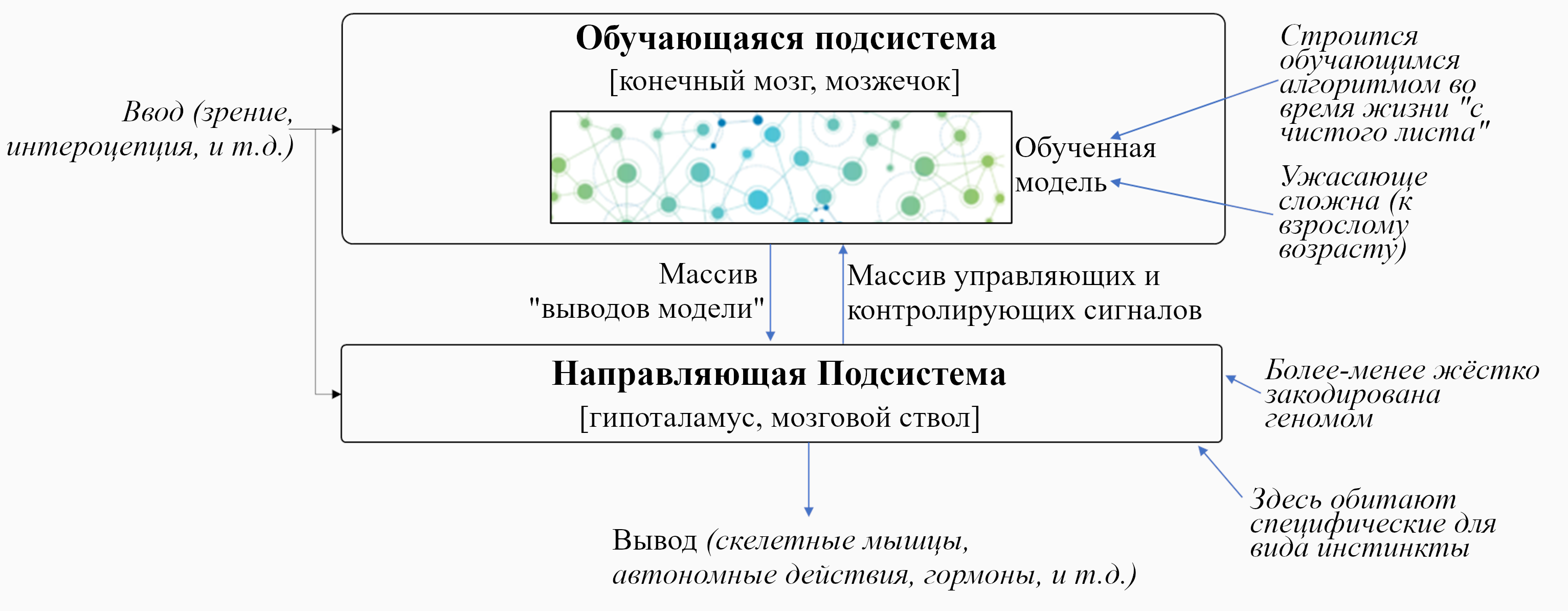

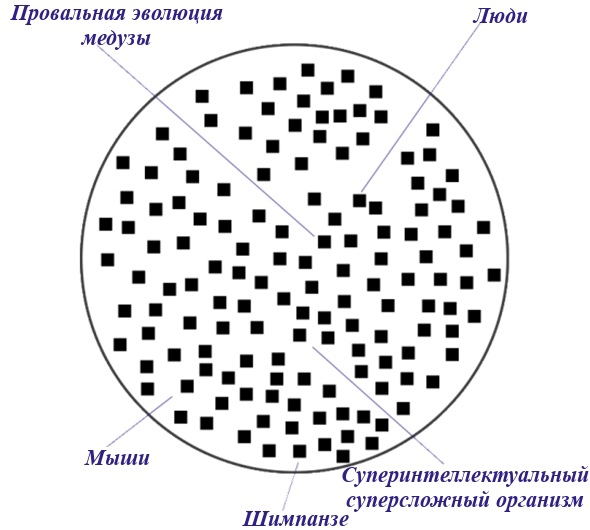

Короткий ответ: Поскольку люди осваивают области, совершенно чуждые их предкам, гипотеза «отдельных модулей» представляется мне неправдоподобной. Я не заявляю, что универсальность интеллекта – это какое-то нередуцируемое оккультное свойство. Предположительно, оно проистекает из набора когнитивных механизмов и их взаимодействий. Однако в целом именно это делает людей куда более когнитивно гибкими, чем, скажем, шимпанзе.

Почему это важно: Люди начали доминировать над другими видами не за счёт большей силы или ловкости, а за счёт большего интеллекта. Раз некая ключевая часть этого обобщённого интеллекта смогла эволюционировать за несколько миллионов лет, прошедших с нашего последнего общего предка с шимпанзе, возможно, некоторое небольшое количество озарений приведут к тому, что инженеры смогут создать мощный универсальный ИИ.

Дальнейшее чтение: Саламон и др. «Насколько интеллект понятен?»

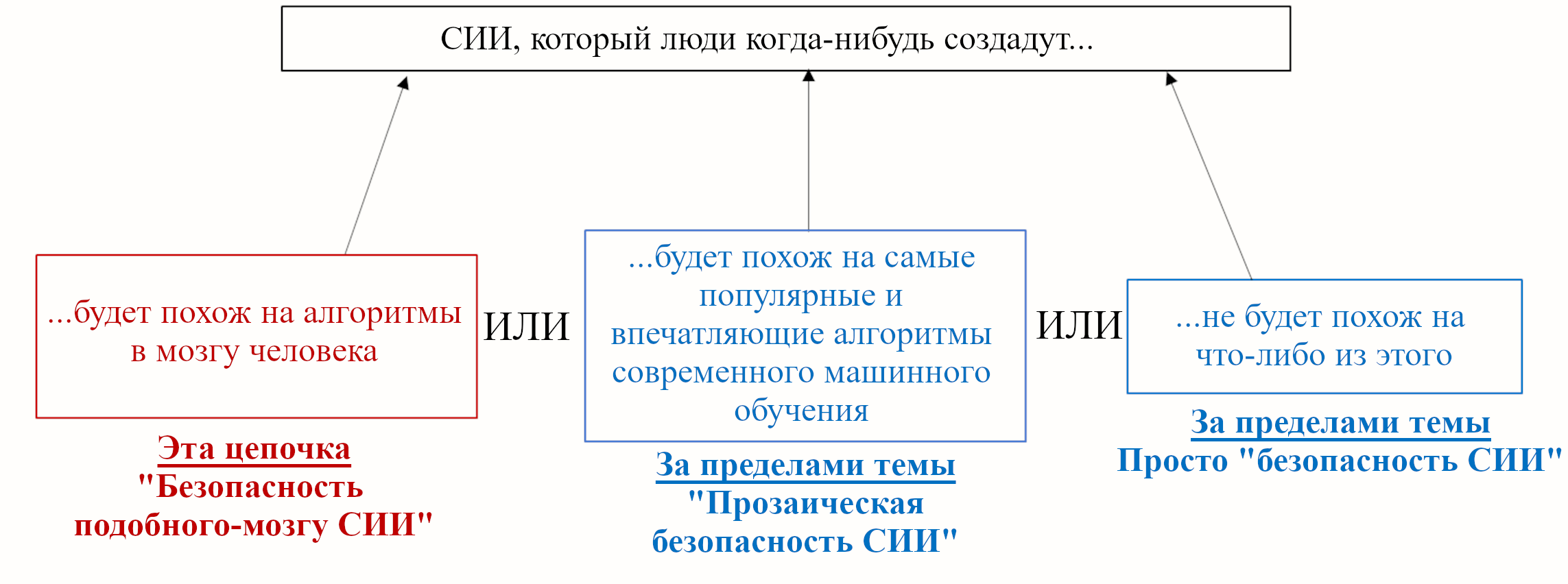

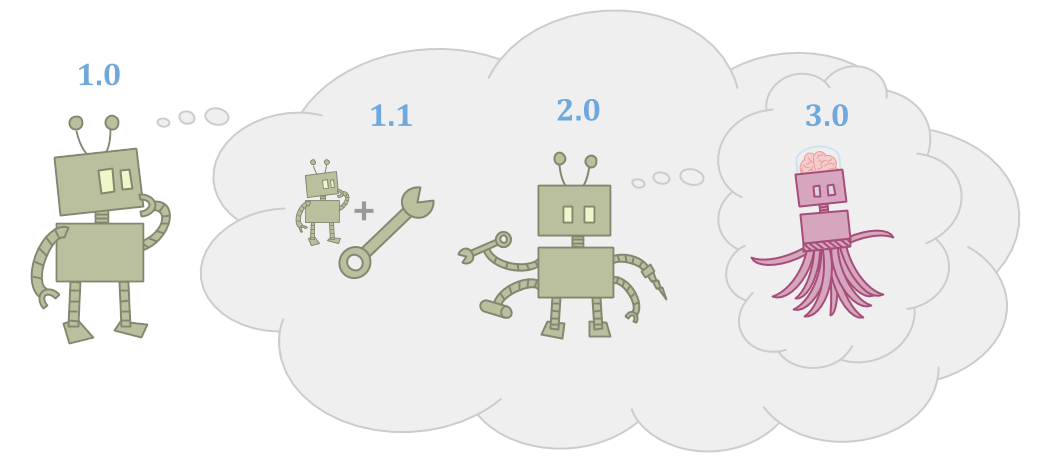

Утверждение 2: ИИ может стать намного умнее людей

Большинство исследователей в MIRI не уверены, когда именно будет разработан превосходящий человека ИИ. Мы, однако, ожидаем, что: (а) искусственный интеллект, равный человеческому, однажды появится (если не случится каких-то катастроф, то вероятно, в течении века); и (б) компьютеры могут стать значительно умнее любого человека.

Альтернативный взгляд 1: Мозг делает что-то особенное, что нельзя воссоздать на компьютере.

Короткий ответ: Мозги – это физические системы, и если верны некоторые версии тезиса Чёрча-Тьюринга, то компьютеры могут в принципе воссоздать связь ввода и вывода любой физической системы. К тому же, заметим, что «интеллект» (в моём использовании термина) – это способность решения задач: даже если есть какая-то специальная человеческая черта (как квалиа), которую нельзя воссоздать на компьютере, это не важно, если только эта черта каким-то образом не мешает нам проектировать системы, решающие задачи.

Альтернативный взгляд 2: Алгоритмы, на которых основывается универсальный интеллект, настолько сложны и недоступны расшифровке, что люди не смогут запрограммировать что-то подобное ещё много веков.

Короткий ответ: Это звучит неправдоподобно с учётом эволюционных свидетельств. Род Homo отделился от других всего 2.8 миллиона лет назад, и прошедшего времени – всего мгновения с точки зрения естественного отбора – было достаточно, чтобы у людей появились когнитивные преимущества. Из этого можно заключить, что какие бы особенности ни отличали людей от менее интеллектуальных видов, вряд ли они очень сложные. Составные части универсального интеллекта должны присутствовать уже в шимпанзе.

На самом деле, относительно интеллектуальное поведение дельфинов позволяет предположить, что эти составные части скорее всего были уже у напоминающего мышь последнего общего предка людей и дельфинов. Можно заявить что и на искусственный интеллект равный мышиному уйдёт много веков, но это утверждение становится крайне сомнительным, если посмотреть на быстрый прогресс в области ИИ. В свете эволюционных наблюдений и последней пары десятилетий исследований ИИ, похоже, что интеллект – это что-то, что мы сможем понять и запрограммировать.

Альтернативный взгляд 3: Люди уже находятся на пределе физически возможного интеллекта или очень близки к нему. Так что, хоть мы и сможем создать равные человеку машины, создать суперинтеллект не получится.

Короткий ответ: Было бы удивительно, если бы человеческий разум оказался идеально приспособленным для рассуждений, — по тем же причинам, по которым удивительно было бы если бы самолёты не могли летать быстрее птиц. Простые физические рассуждения подтверждают эту интуицию: к примеру, с точки зрения физики представляется вполне возможным запуск симуляции человеческого мозга в тысячу раз быстрее его обычной скорости.

Кто-то может ожидать, что скорость здесь не важна, потому что мы упрёмся в ожидание новых данных от физических экспериментов. Мне это кажется маловероятным. Есть много интересных физических экспериментов, которые можно ускорить, и мне сложно поверить, что команда людей, запущенных на тысячекратной скорости не превзойдёт таких же обычных людей (в частности потому, что они смогут быстро разрабатывать новые инструменты и технологии для помощи себе).

К тому же я ожидаю, что возможно создать интеллект, который будет рассуждать не только быстрее, но и лучше, то есть, использующий вычислительные ресурсы эффективнее людей, даже при работе на той же скорости.

Почему это важно: Спроектированные людьми машины зачастую на голову превосходят биологических существ по параметрам, которые нас интересуют: автомобили не регенерируют и не размножаются, но уж точно перевозят людей дальше и быстрее, чем лошадь. Если мы сможем создать интеллектуальные системы, специально спроектированные для решения главных мировых проблем с помощью научных и технологических инноваций, то они смогут улучшать мир беспрецедентными темпами. Другими словами, ИИ важен.

Дальнейшее чтение: Чалмерс, «Сингулярность: Философский Анализ»

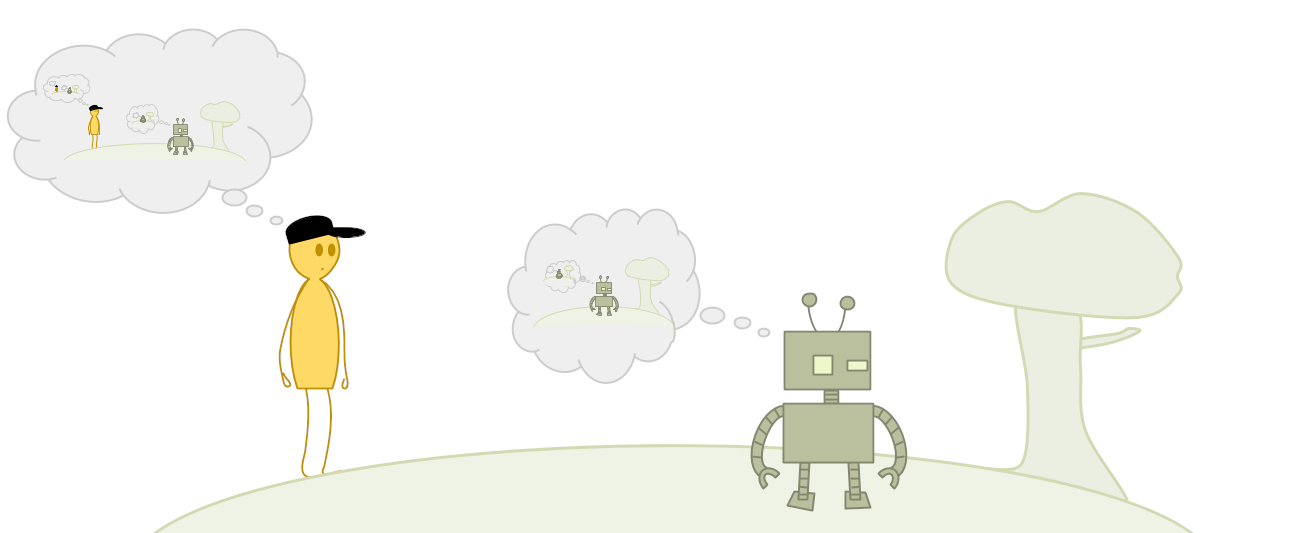

Утверждение 3: Если мы создадим высокоинтеллектуальные ИИ-системы, то их решения будут определять будущее

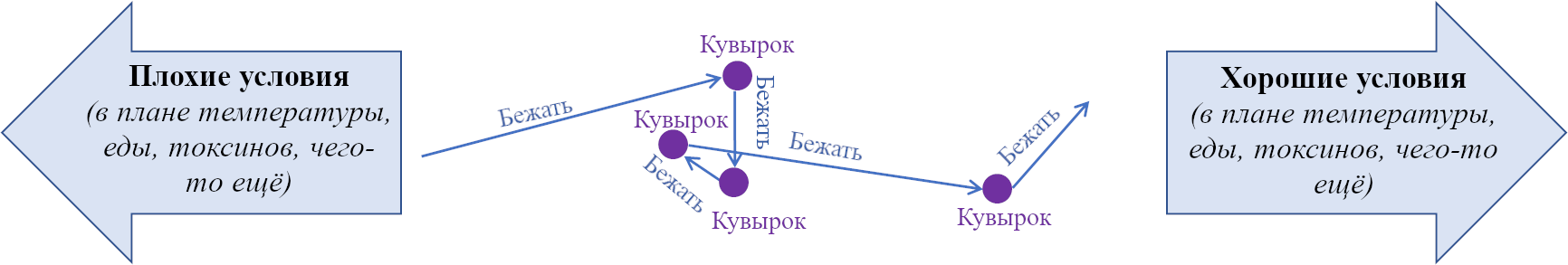

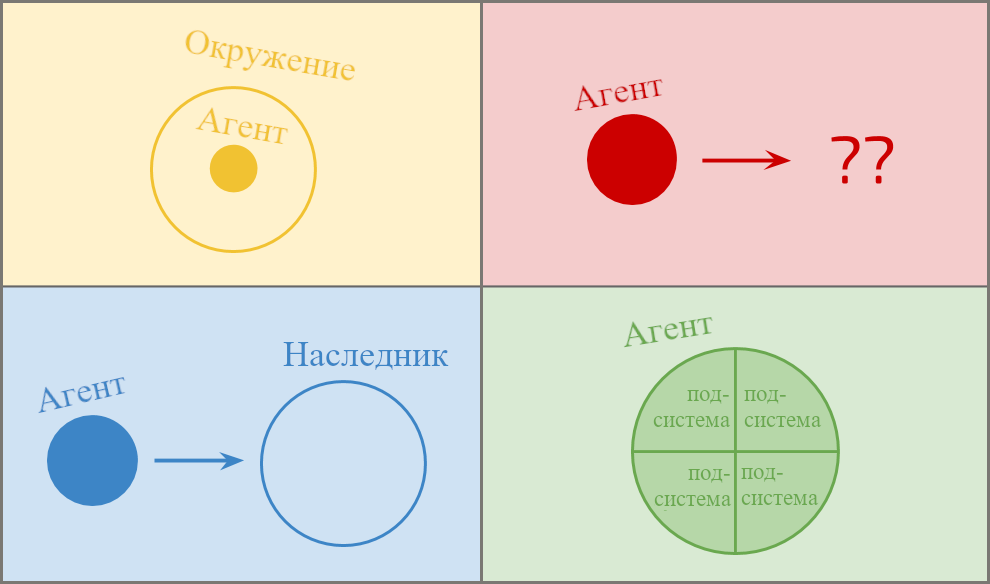

Благодаря интеллекту люди создают инструменты, планы и технологии, которые позволяют им изменять окружающую среду по своей воле (и заполнять её холодильниками, автомобилями и городами). Мы ожидаем, что ещё более умные системы будут ещё более способны изменять своё окружение, и, соответственно, что ИИ умнее человека будет управлять будущим больше, чем люди.

Альтернативный взгляд: ИИ никогда не сможет превзойти всё человечество в целом, каким бы умным он ни был. Наше окружение попросту слишком конкурентное. Ему придётся работать вместе с нами и интегрироваться в нашу экономику.

Короткий ответ: Я не сомневаюсь, что автономный ИИ, пытающийся выполнить простые задачи, поначалу будет мотивирован интегрироваться в нашу экономику: если создать ИИ для коллекционирования марок, то он, вероятно, начнёт накапливать деньги для их приобретения. Но что если у него появится сильное технологическое или стратегическое преимущество?

Утрированный пример: мы можем представить, как такой ИИ разрабатывает наномашины и использует их, чтобы они преобразовывали как можно больше материи в марки. Для него вовсе не обязательно будет иметь значение, откуда берётся эта материя – из «грязи», «денег» или «людей». Эгоистичные агенты имеют стимулы участвовать в экономике, только если их приобретения от торговли превышают то, что они получат, игнорируя экономику и просто забирая себе ресурсы самостоятельно.

Так что вопрос в том, возможно ли для ИИ получить решающее технологическое или стратегическое преимущество. Я считаю это наиболее сомнительным утверждением из тех, что я тут привожу. Однако, я всё равно ожидаю, что ответ определённо будет «да».

Исторически, конфликты между людьми часто заканчивались тем, что технологически превосходящая группа одерживала верх над своими соперниками. В настоящий момент есть некоторое число технологических и социальных инноваций, которые выглядят возможными, но ещё не разработаны. По сравнению с тем, чего могут достигнуть распределённые программные системы, люди медленно и неэффективно координируются. Поэтому можно предположить, что если мы создадим машину, которая двигает науку быстрее или эффективнее нас, то она быстро получит технологическое и/или стратегическое преимущество над человечеством для себя или для своих операторов. Это в особенности верно, если интеллектуальное превосходство позволяет ей социально манипулировать людьми, приобретать новое оборудование (легально или нет), производить лучшее оборудование, создавать копии себя, или улучшать свой собственный код. К добру или к худу, будущее, вероятно, будет в основном определяться принимающими решения сверхинтеллектуальными машинами.

Почему это важно: Потому что будущее важно. Если мы хотим, чтобы в будущем стало лучше (или хотя бы не хуже), то разумней уделить достаточно времени исследованию процессов, которые будут оказывать на будущее большое влияние.

Дальнейшее чтение: Армстронг, «Умнее Нас».

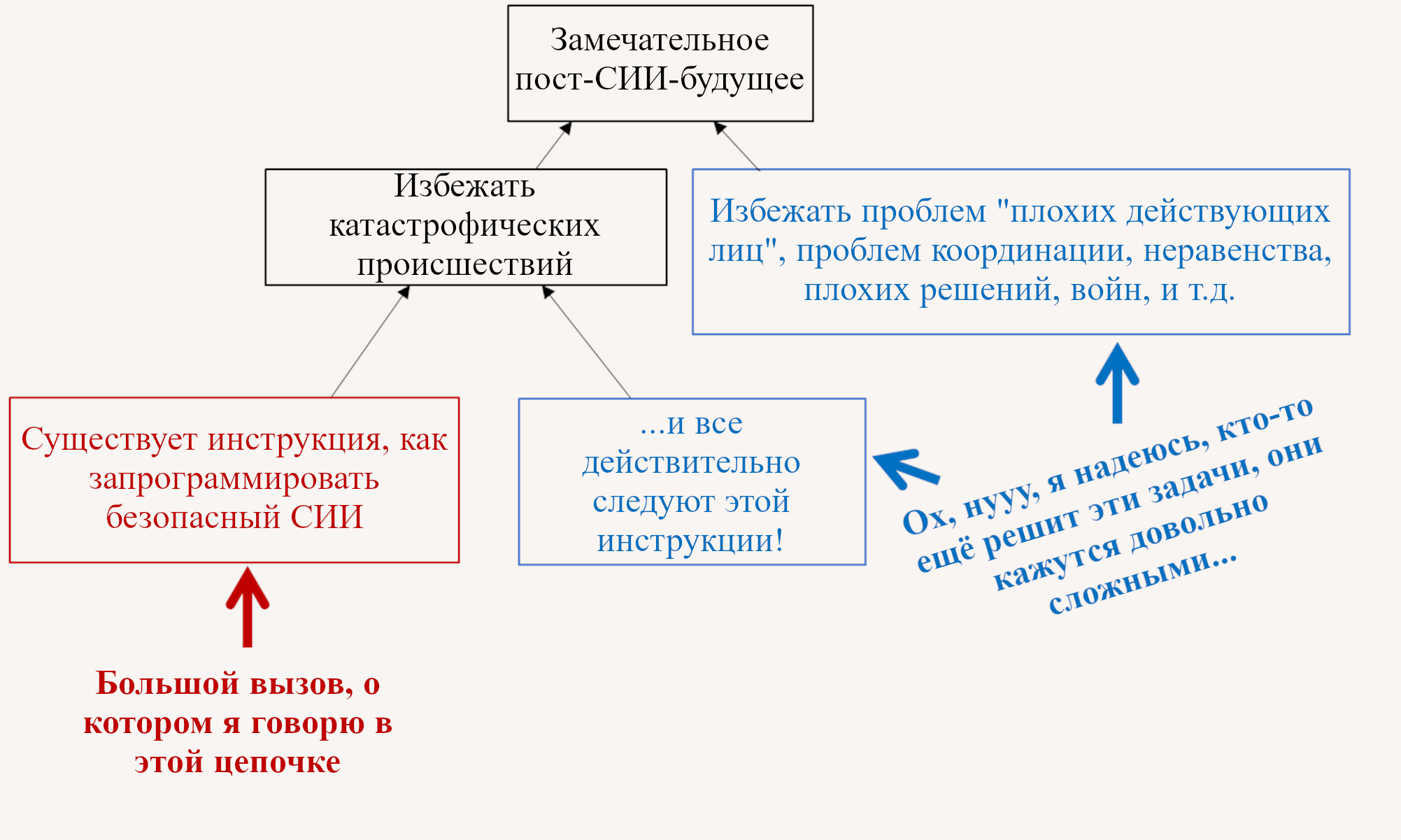

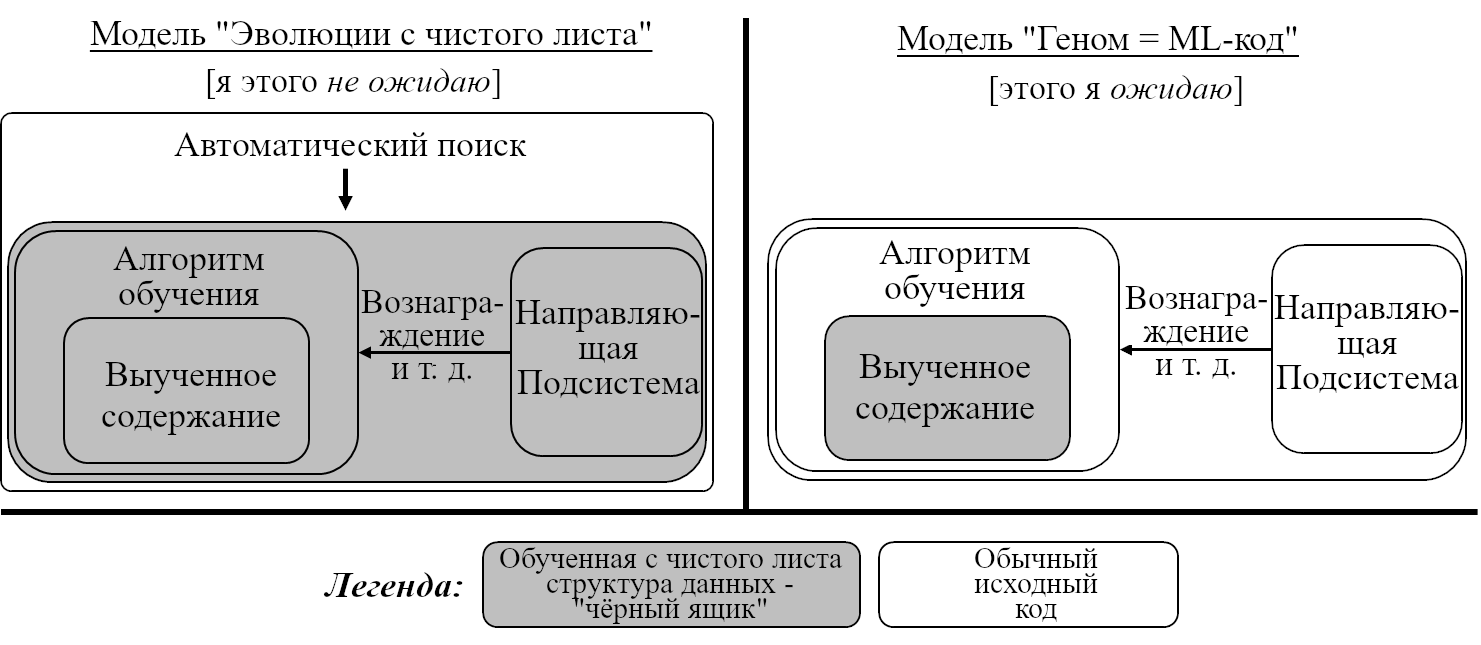

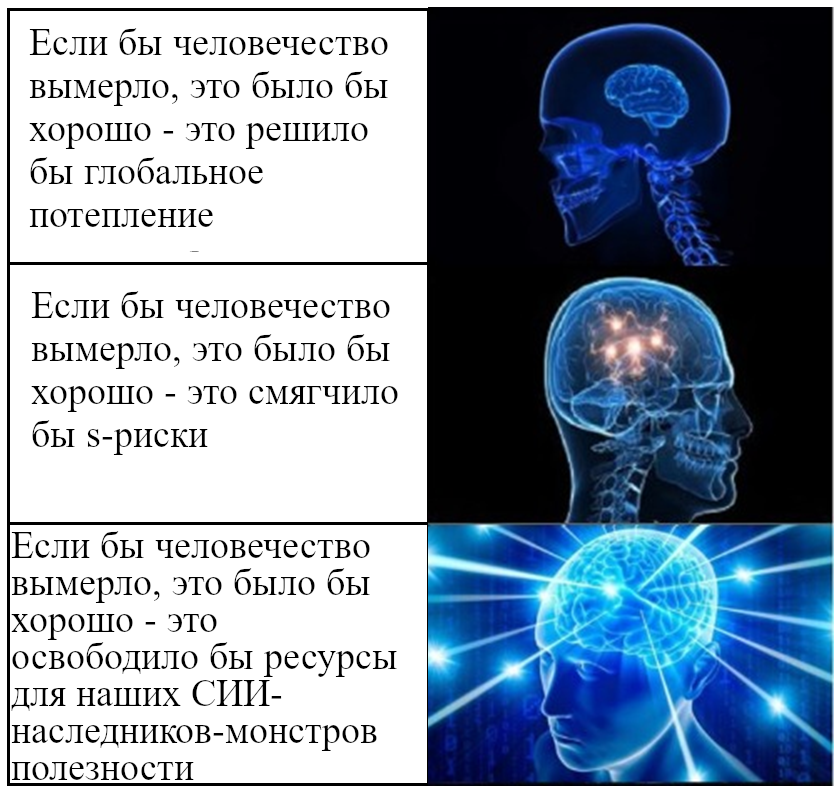

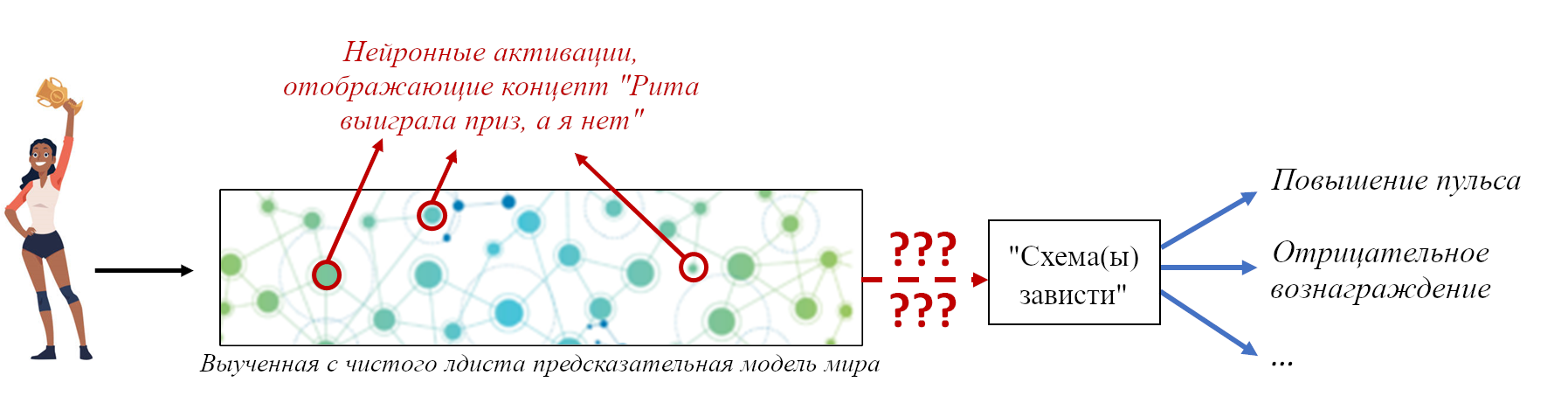

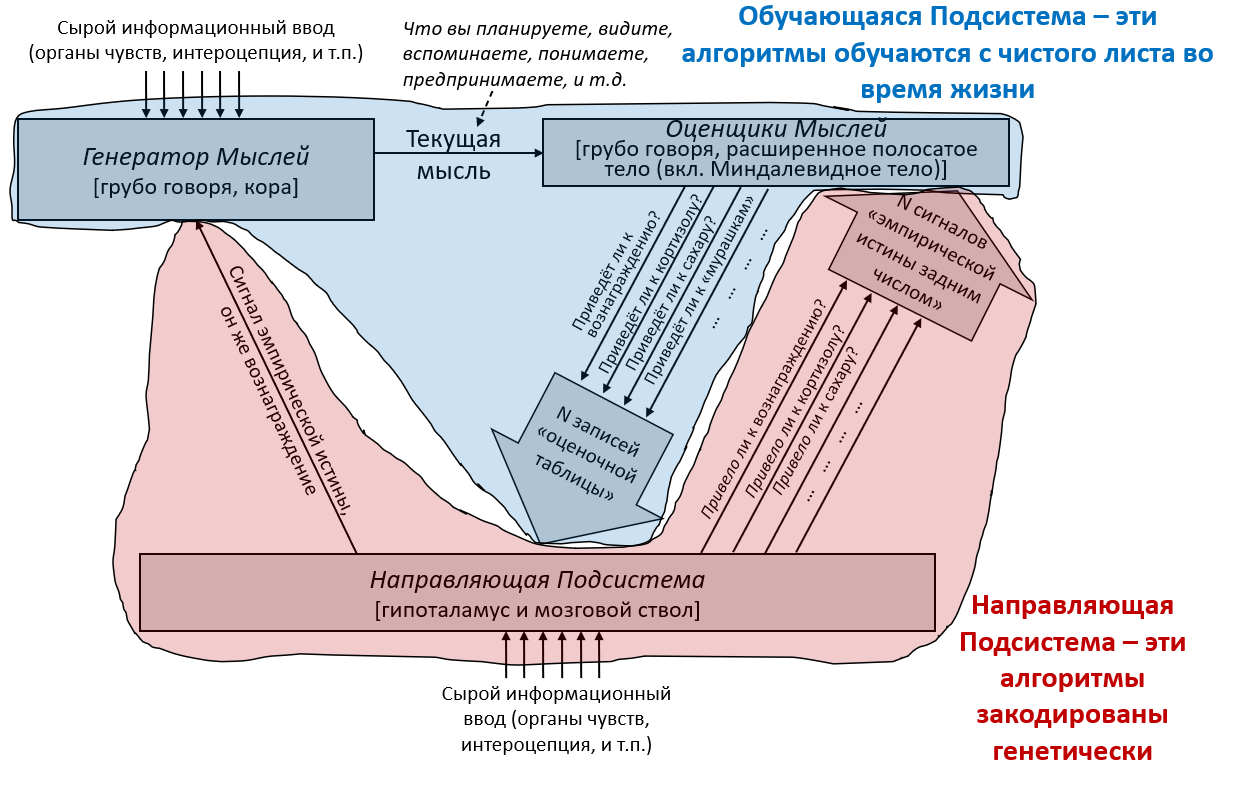

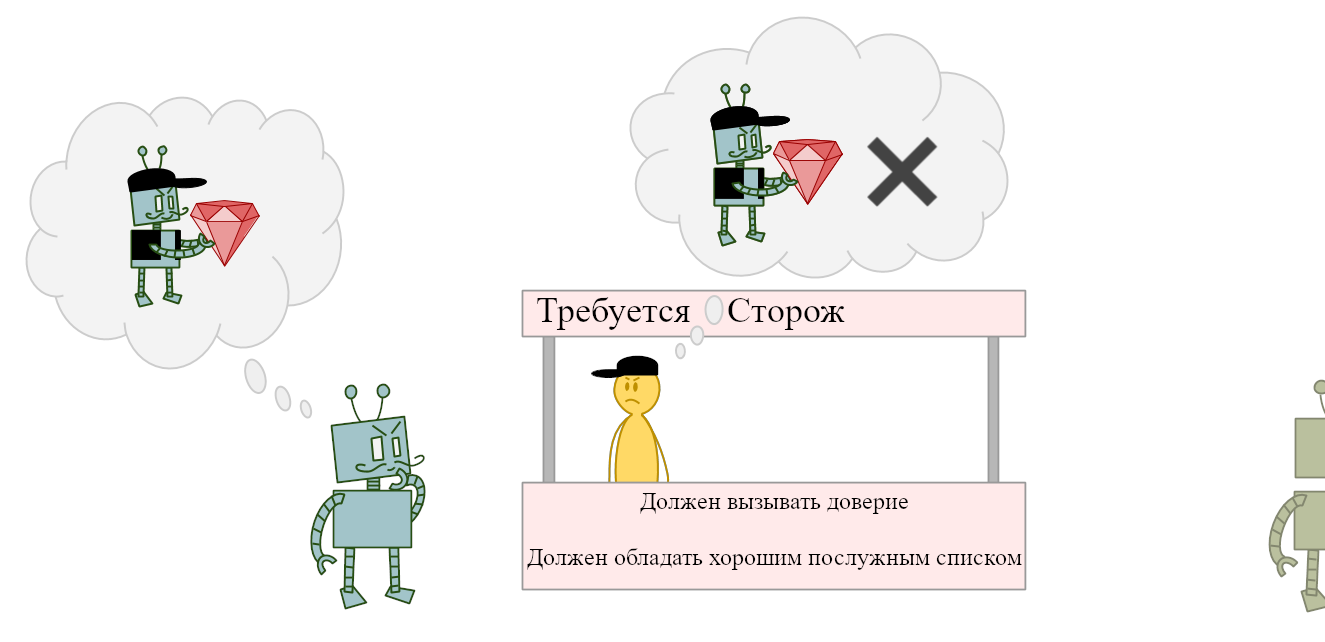

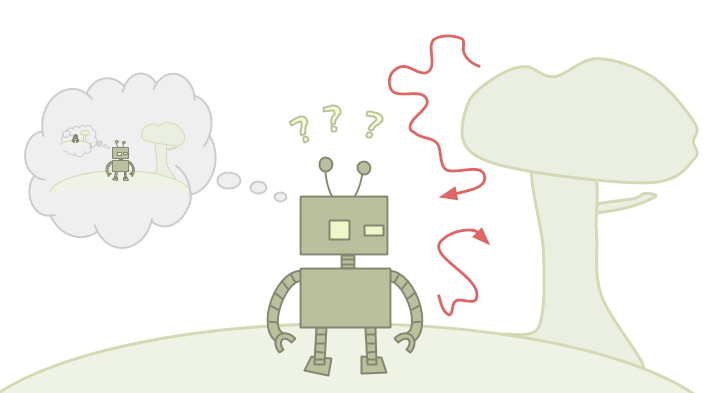

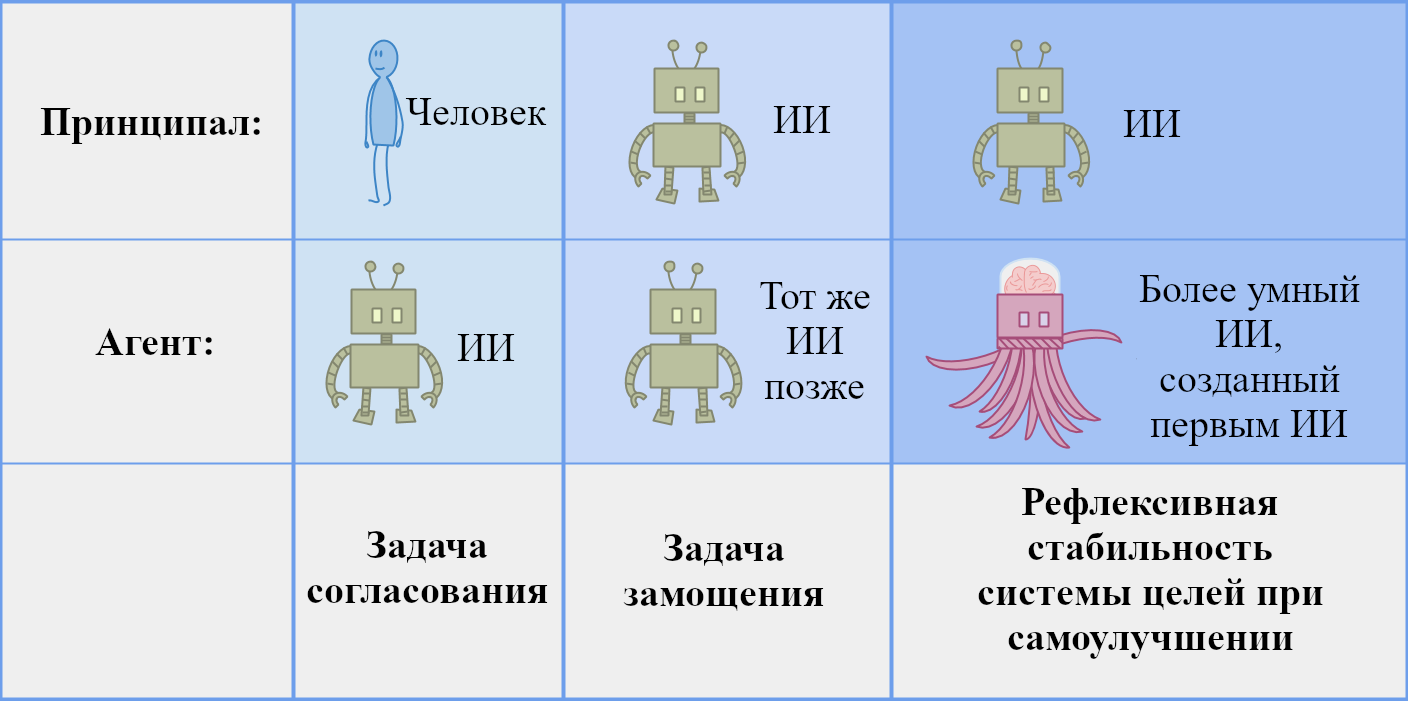

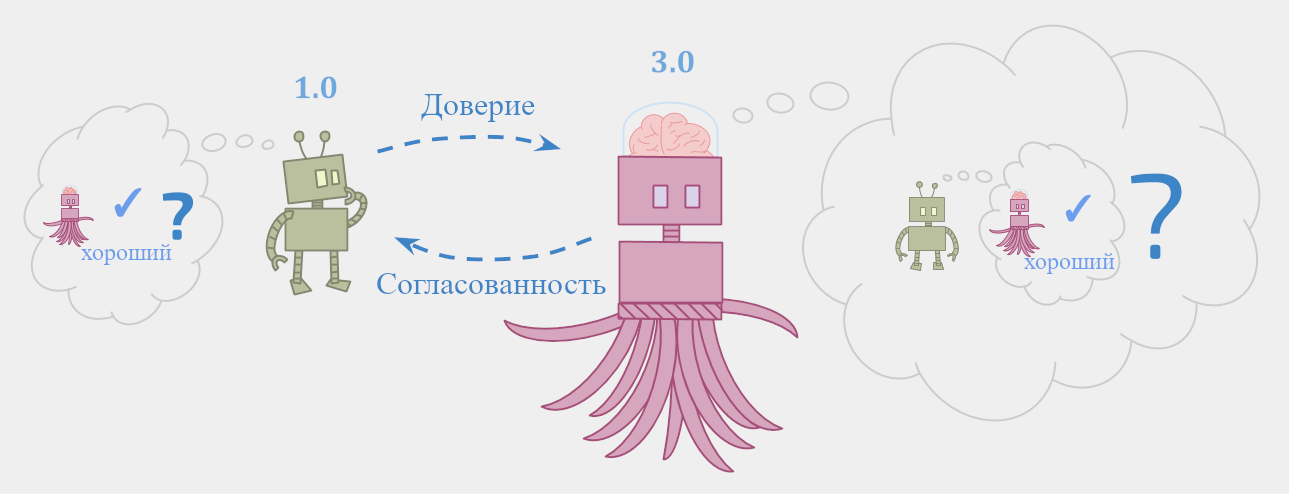

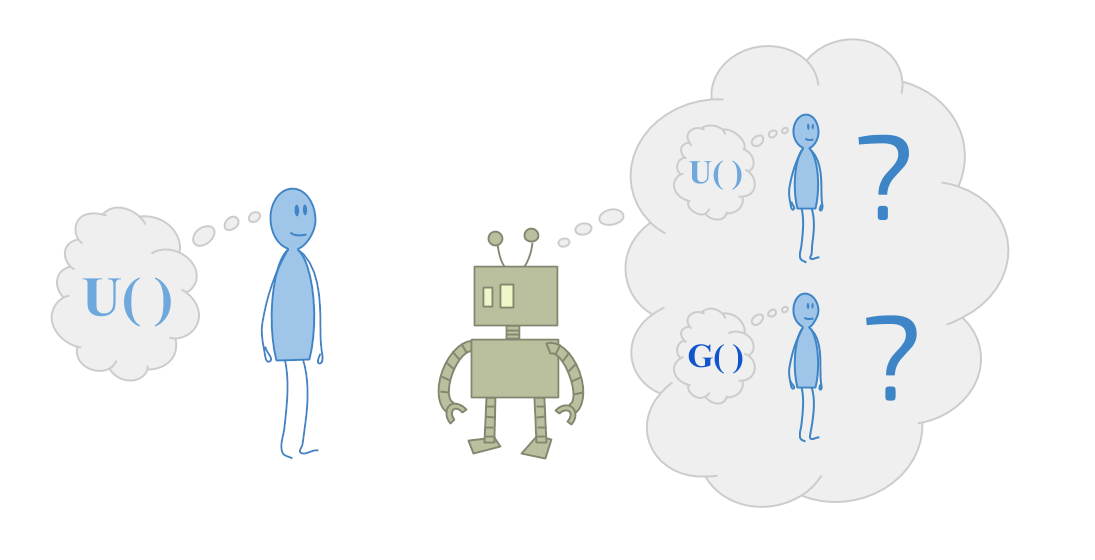

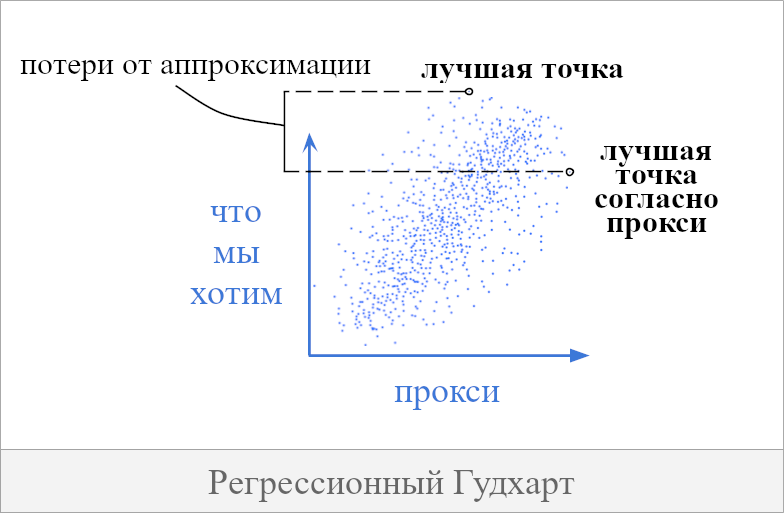

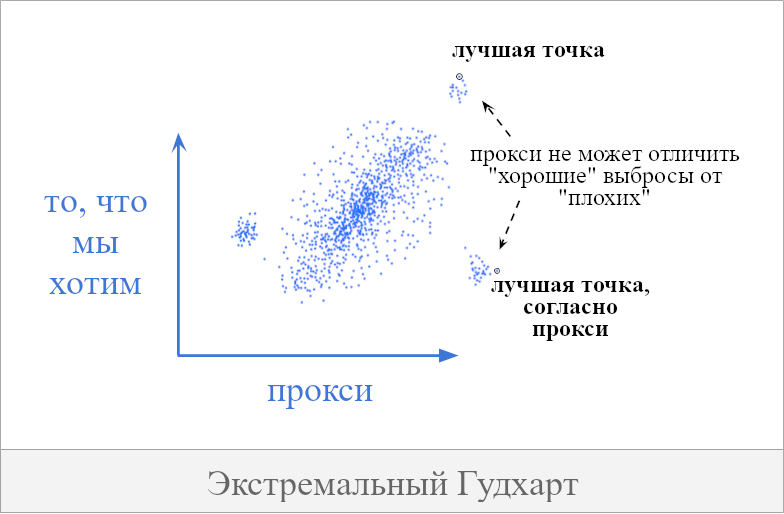

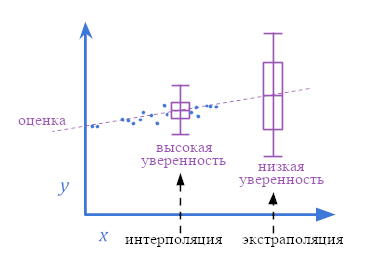

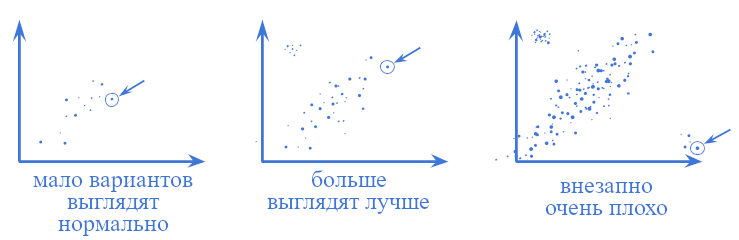

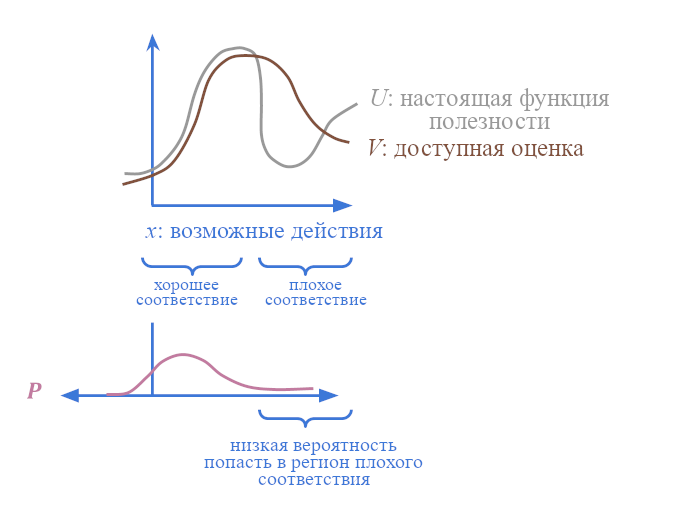

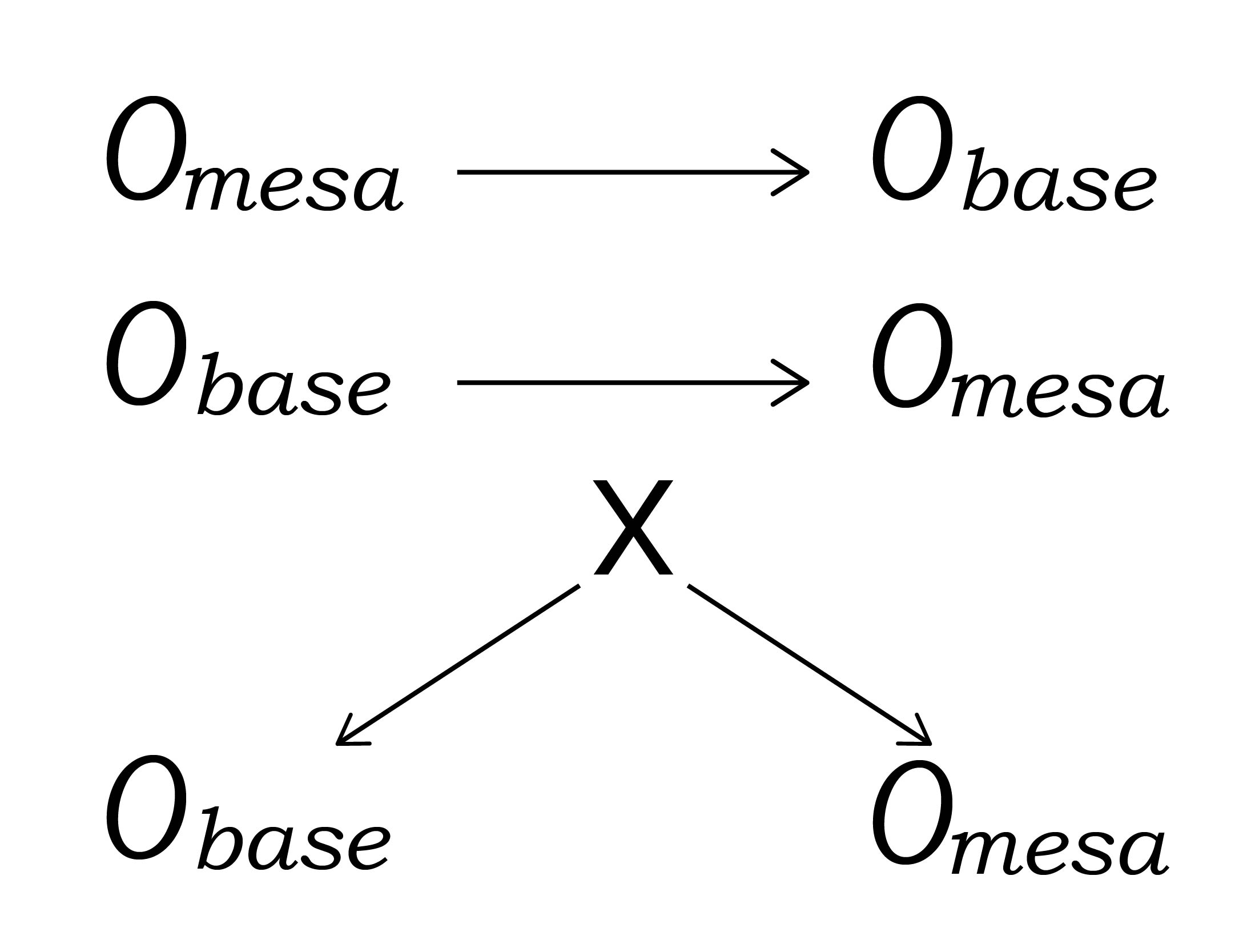

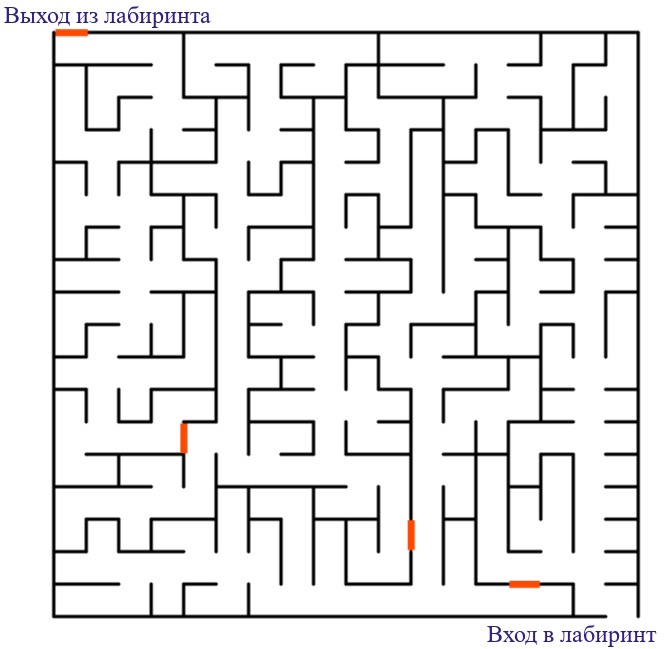

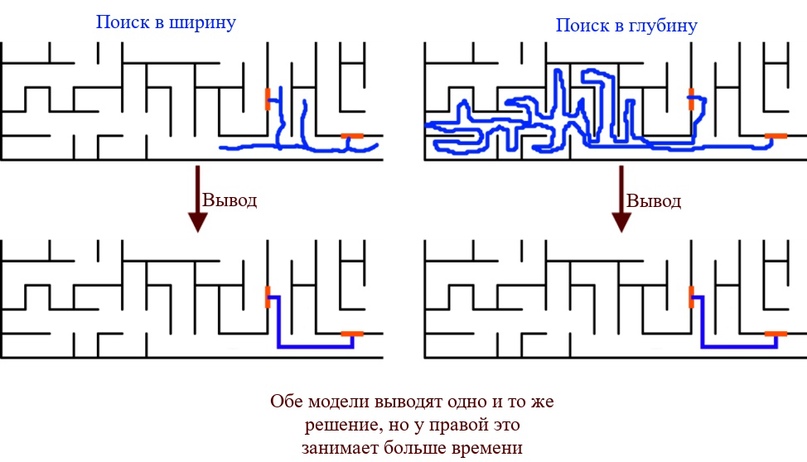

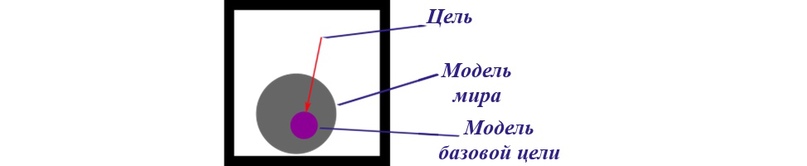

Утверждение 4: Высокоинтеллектуальный ИИ не будет полезен для человечества по умолчанию

Нам хотелось бы, чтобы ИИ умнее людей работали вместе с человечеством для создания лучшего будущего. Однако по умолчанию это не произойдёт. Чтобы создать ИИ, оказывающий благотворное влияние, нам нужно не просто создать более мощные и универсальные ИИ-системы, но и преодолеть некоторое количество технических препятствий.

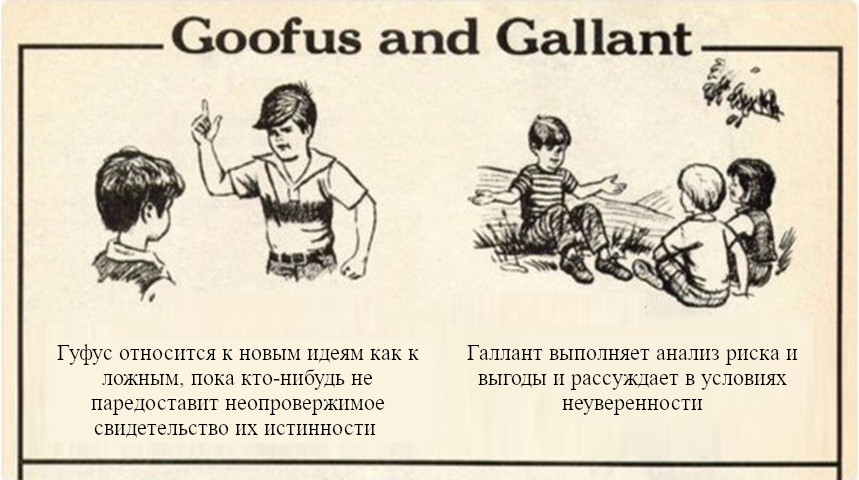

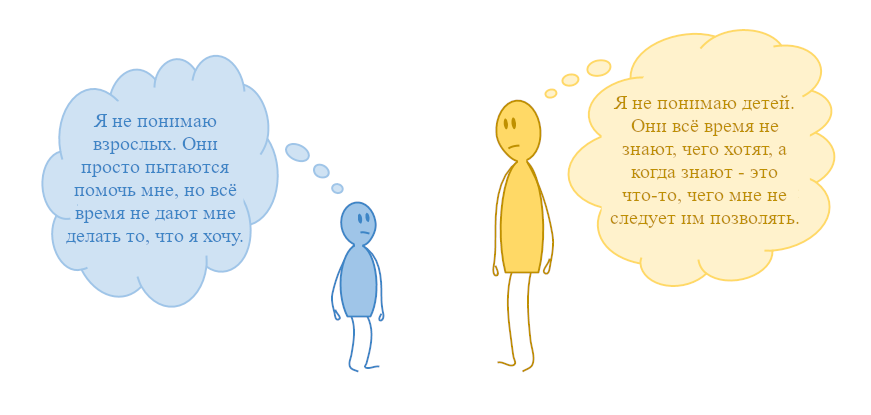

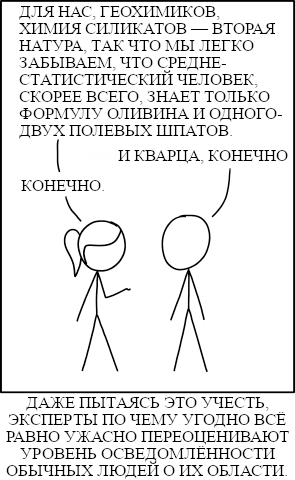

Альтернативный взгляд: Люди, становясь умнее, так же становятся более миролюбивыми и терпимыми. Когда ИИ будет становится умнее, он, вероятно, сможет лучше понять наши ценности и лучше им соответствовать.

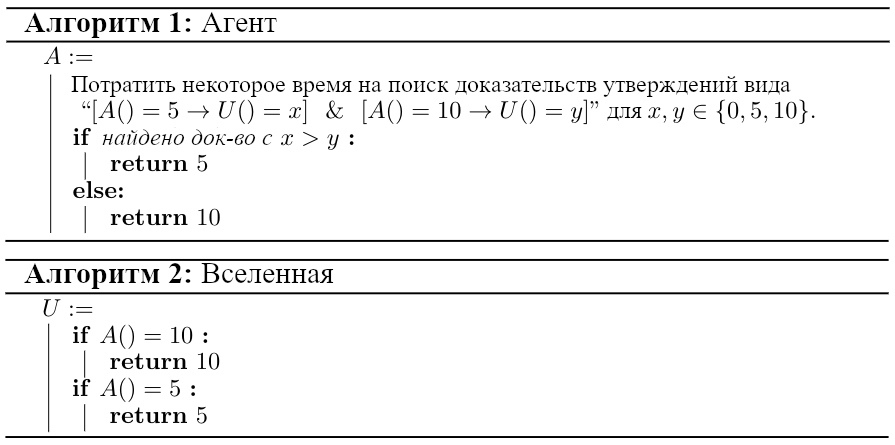

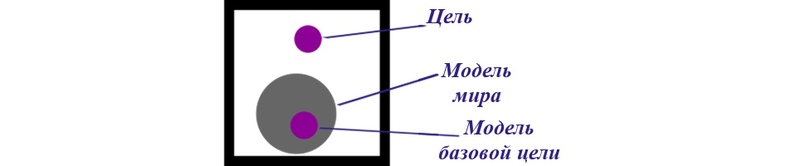

Короткий ответ: Достаточно умный ИИ сможет определить наши намерения и предпочтения. Однако это не подразумевает, что его действия будут согласованы с нашими предпочтениями.

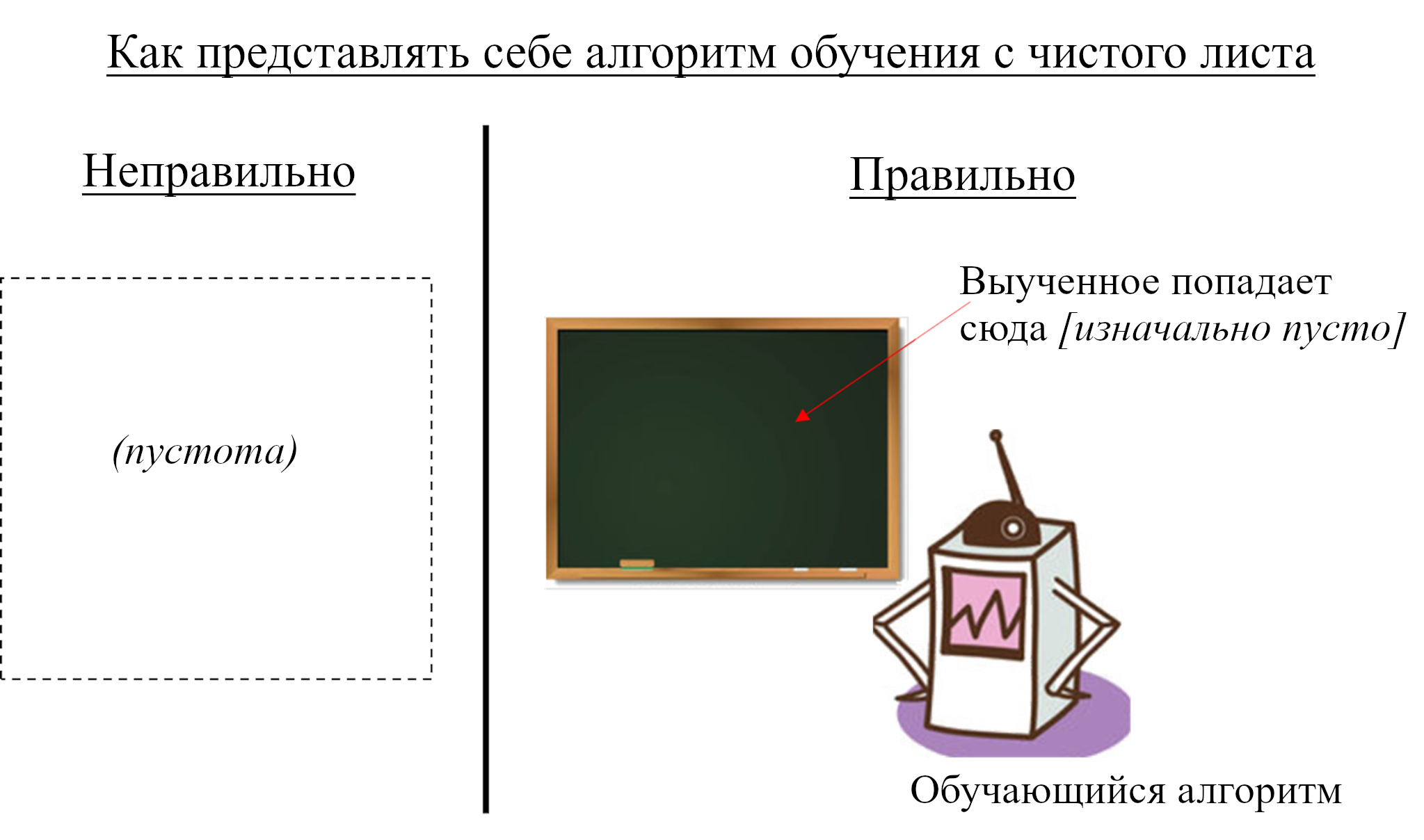

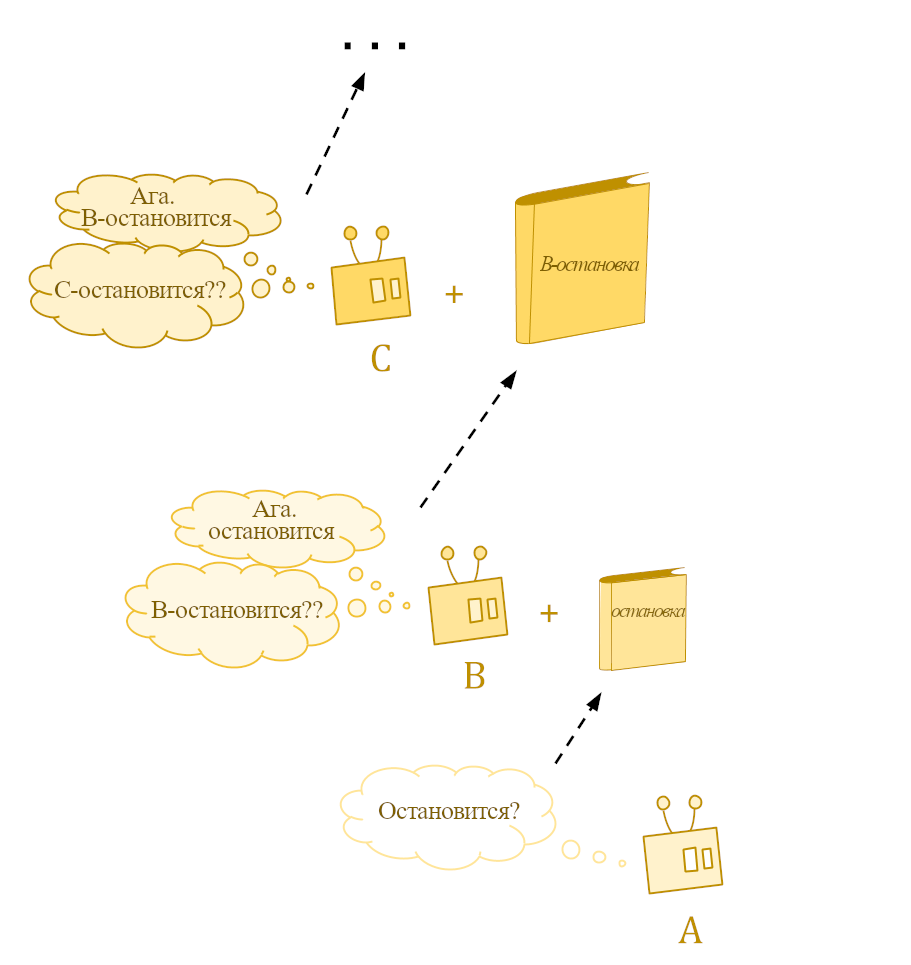

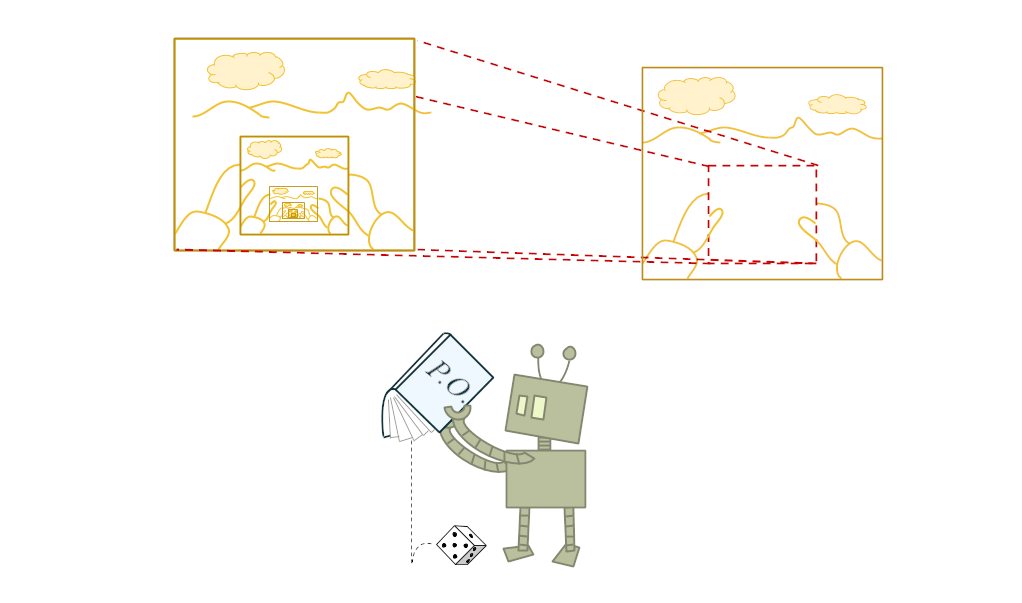

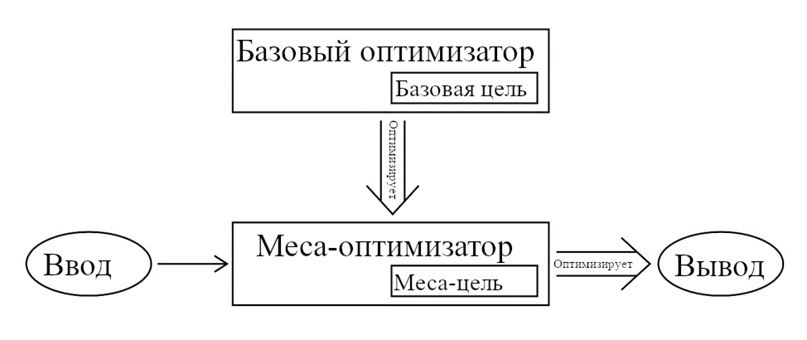

Самомодифицирующийся ИИ мог бы изучить свой код и решить, продолжить ли преследовать поставленные ему цели или модифицировать их. Но как программа будет решать, какие модификации проводить?

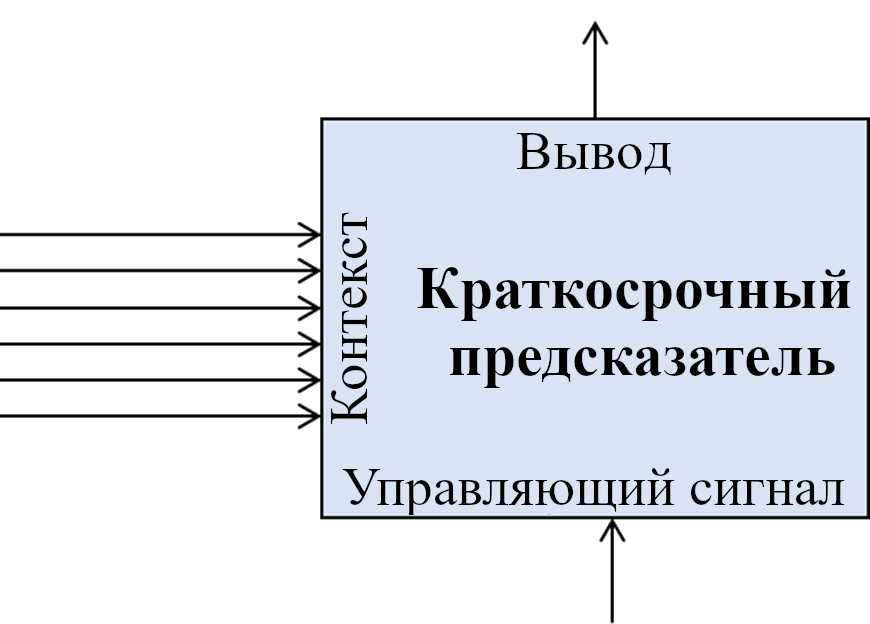

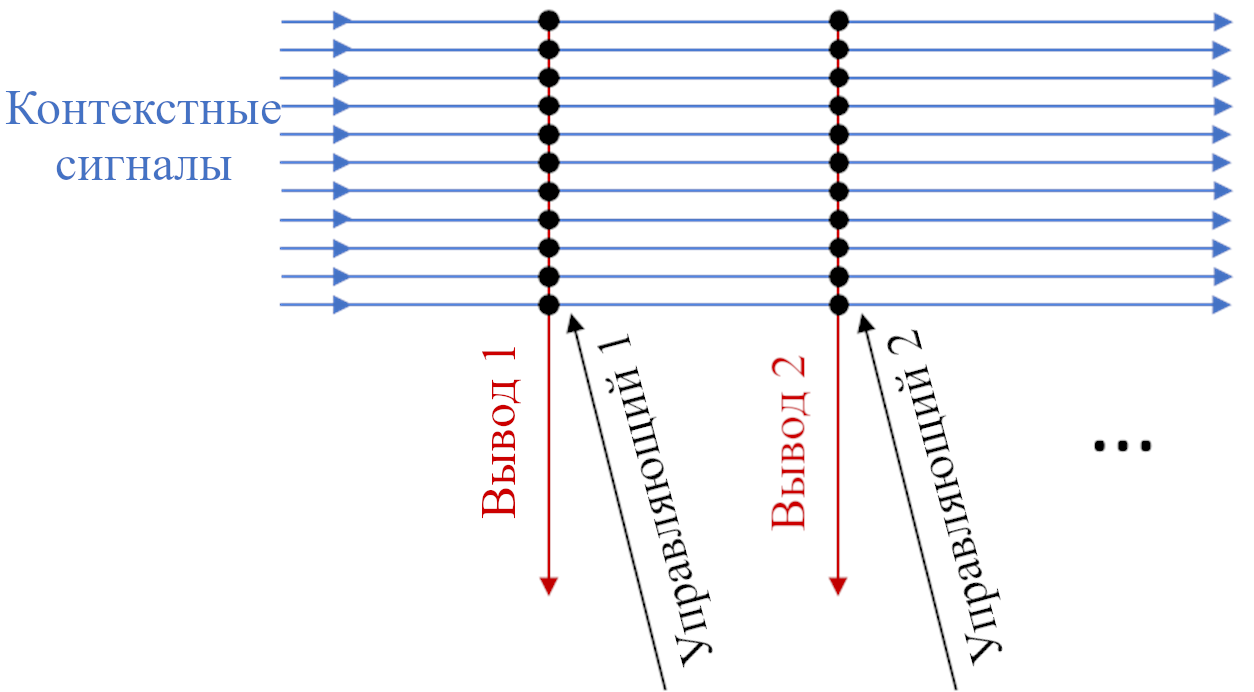

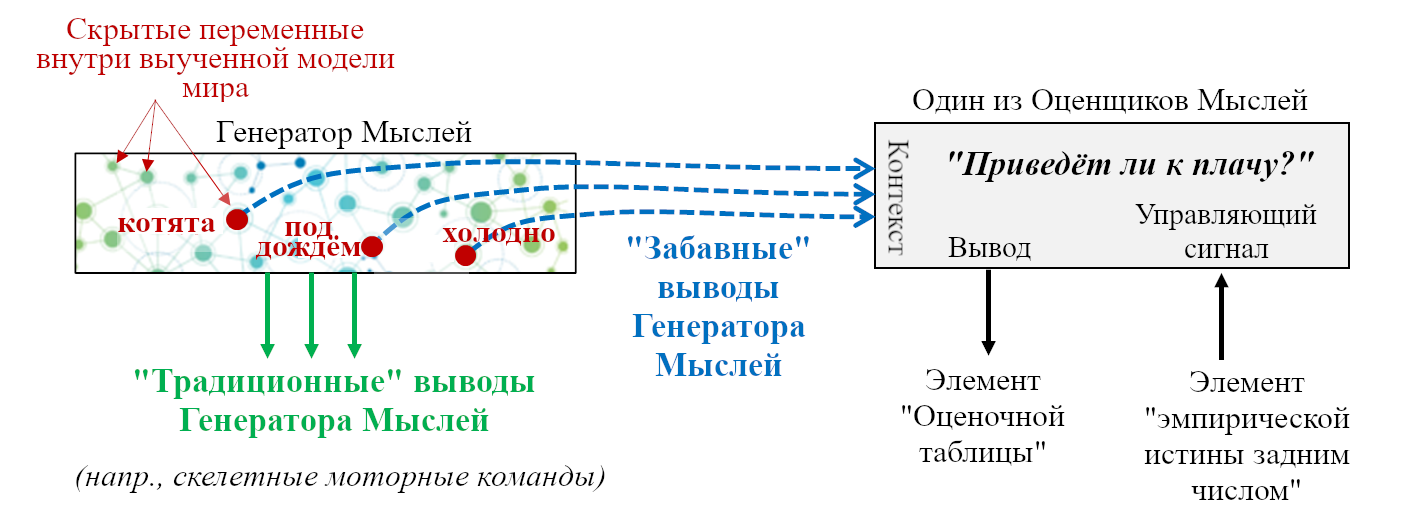

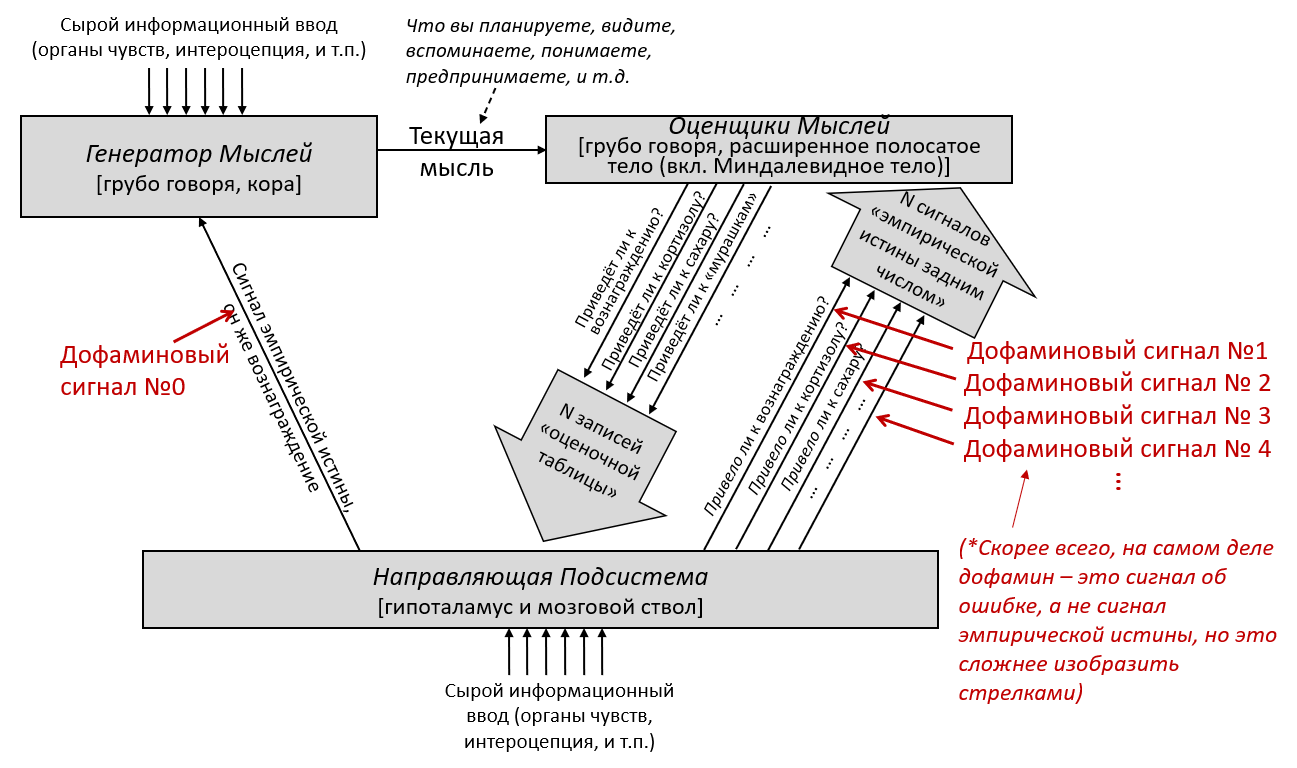

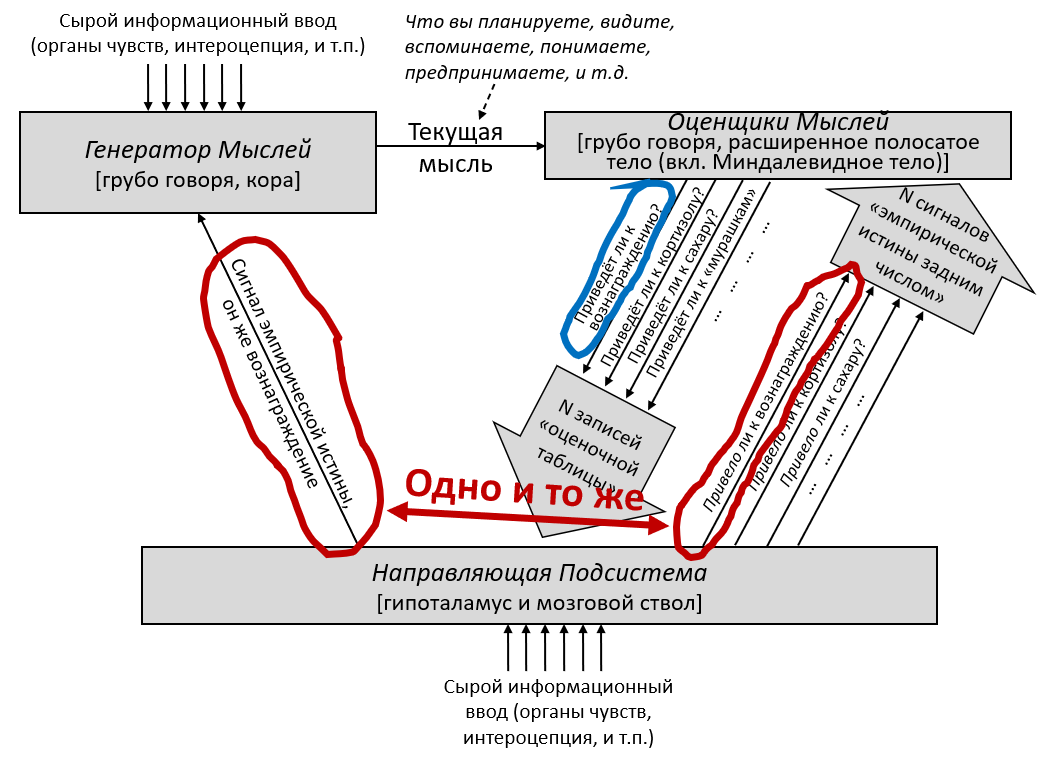

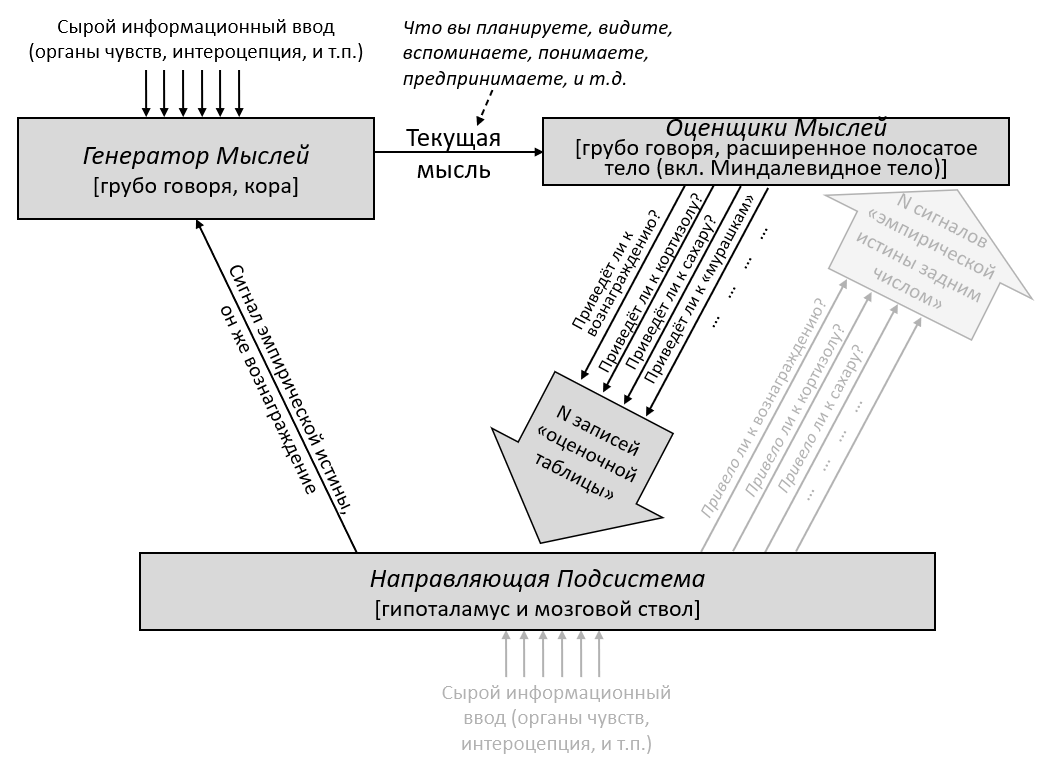

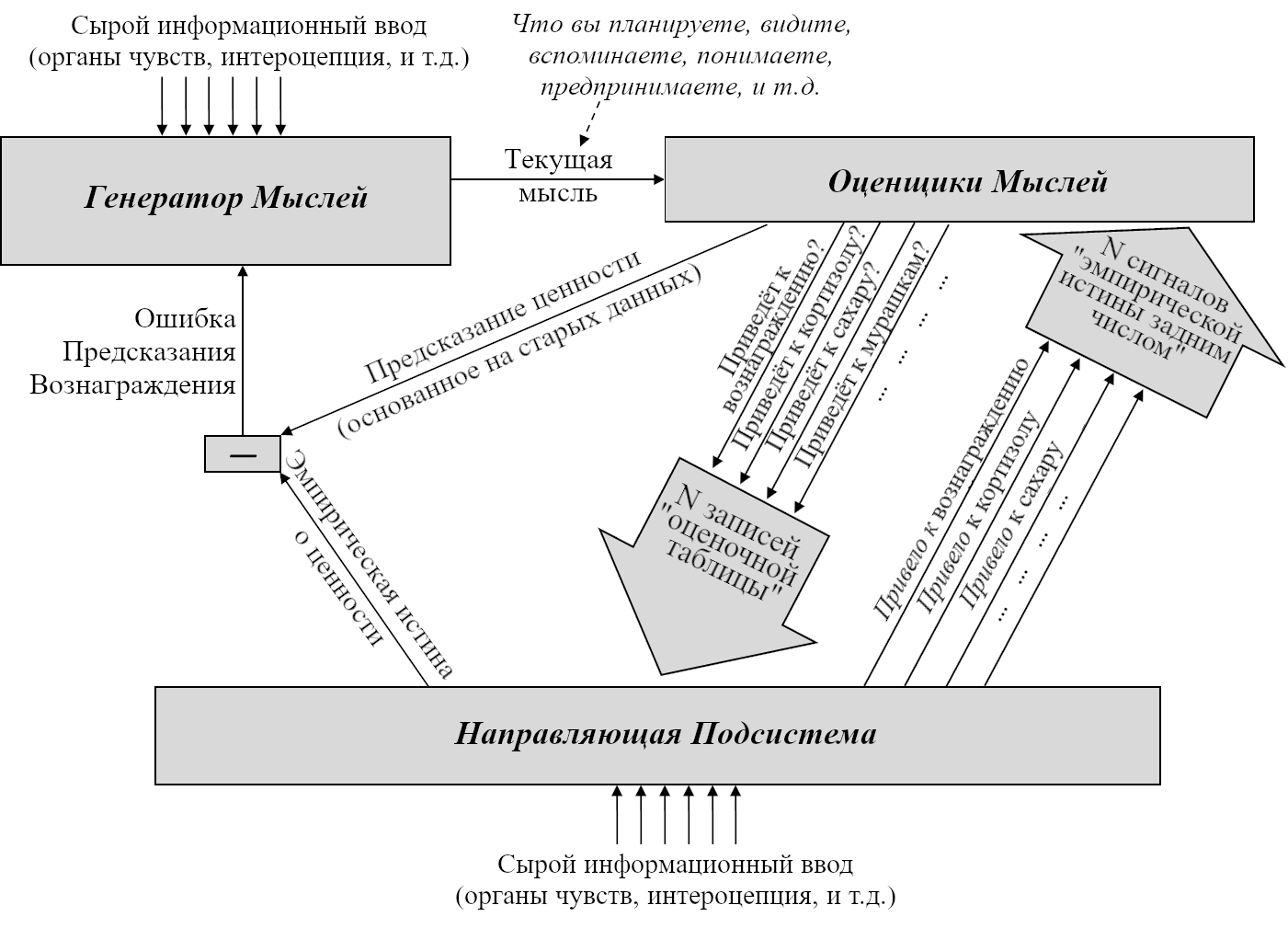

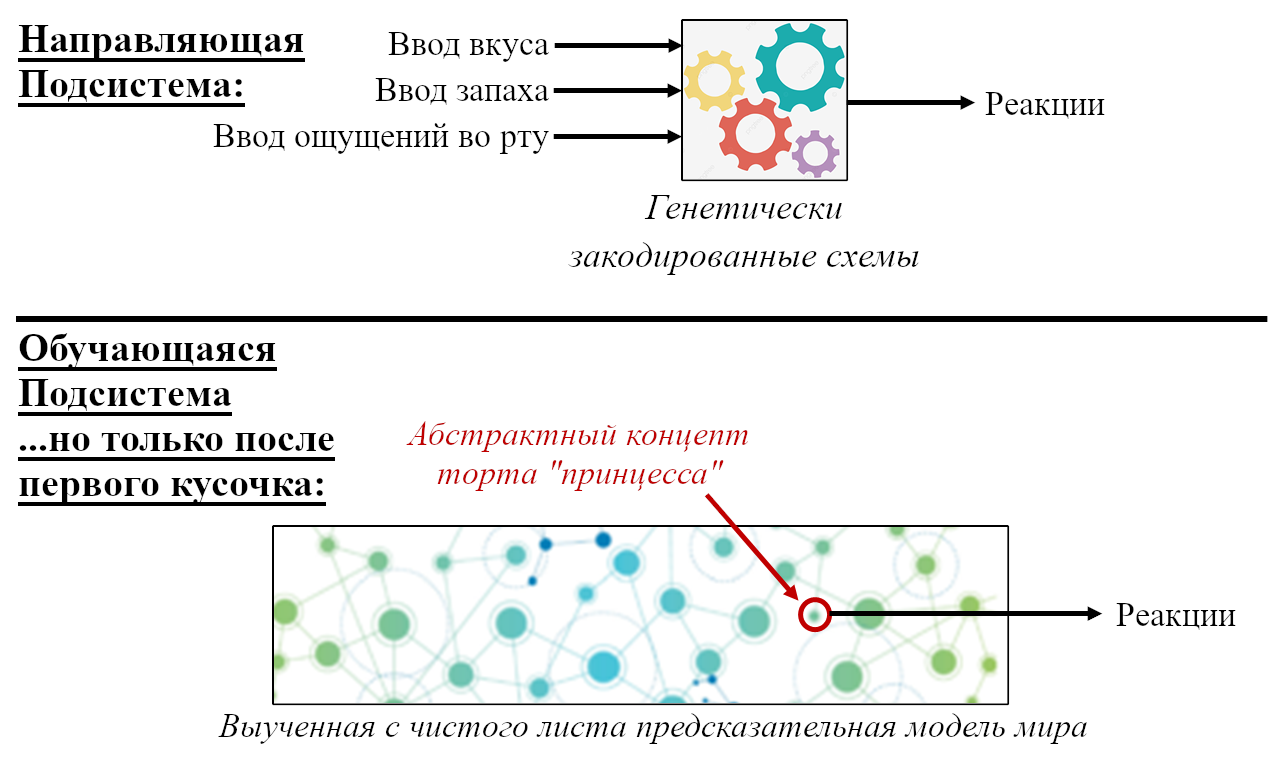

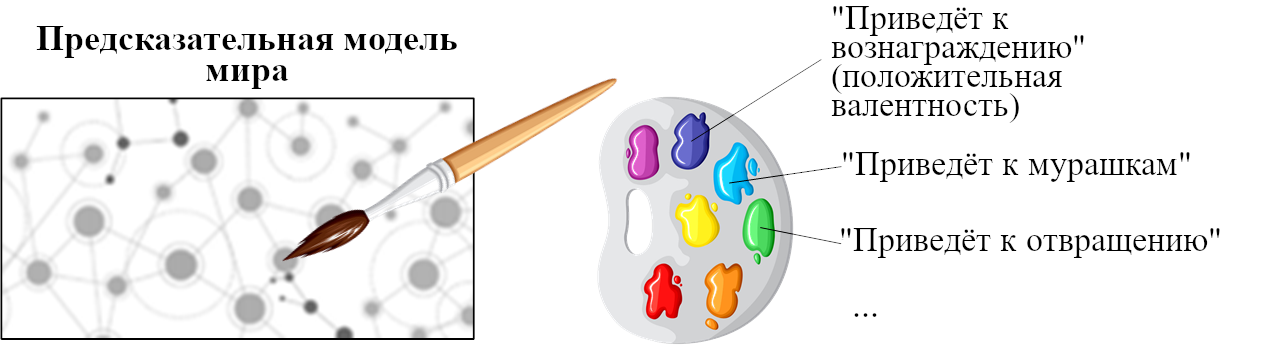

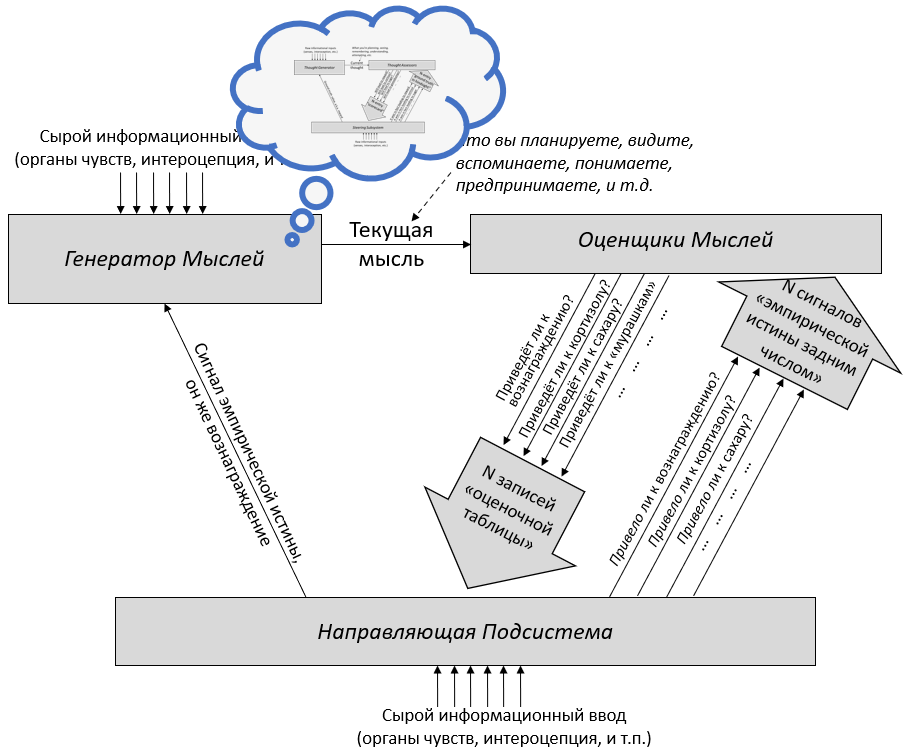

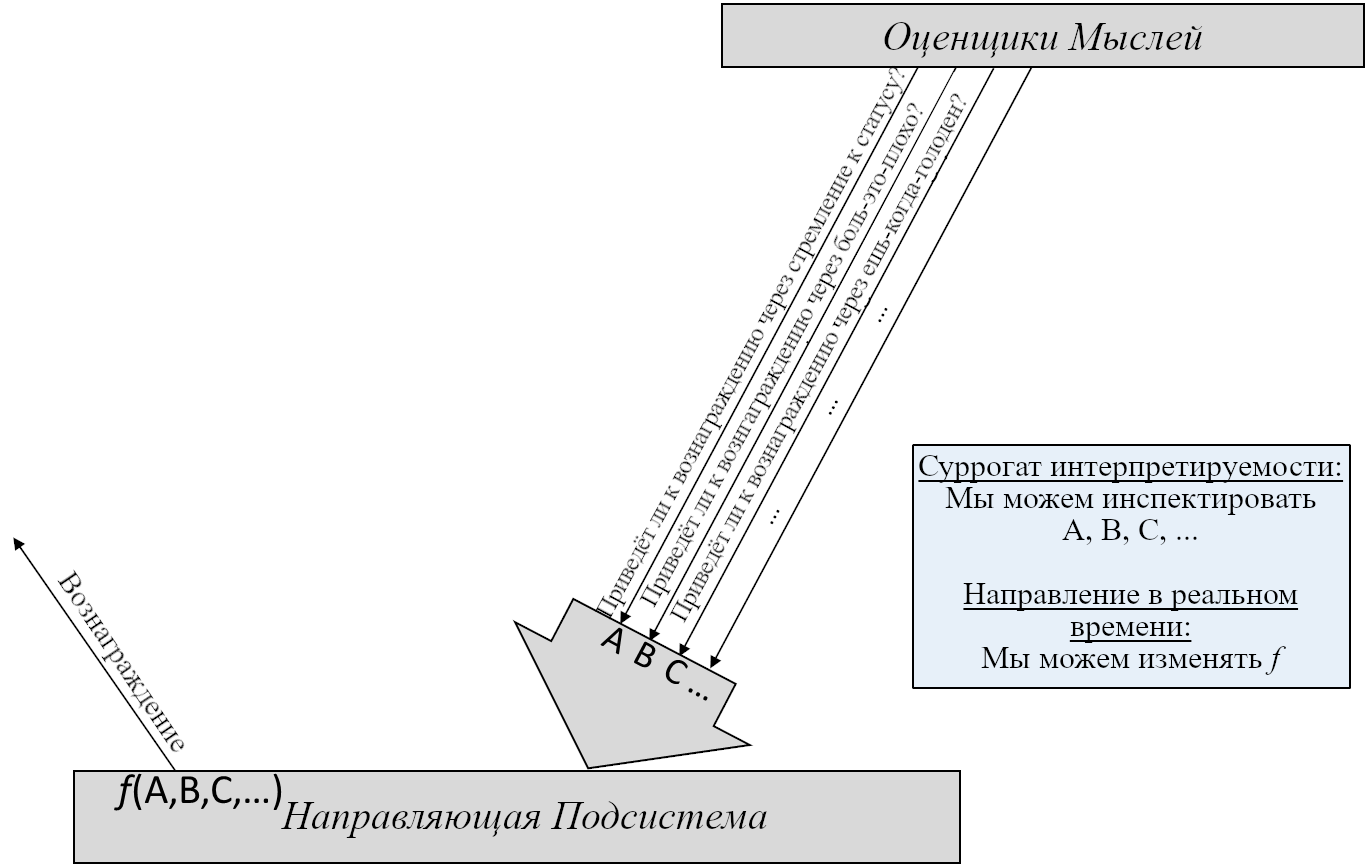

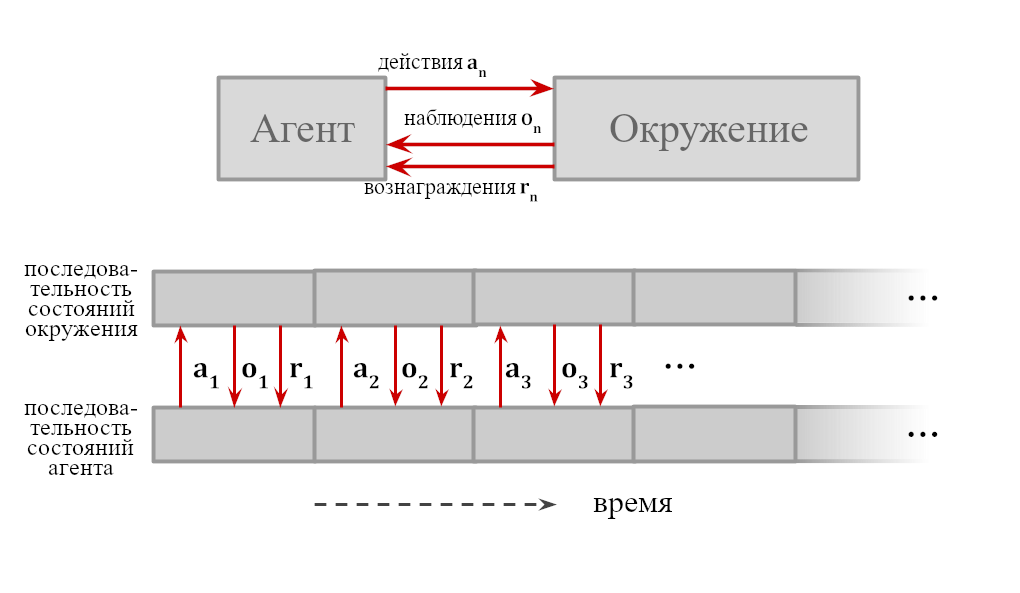

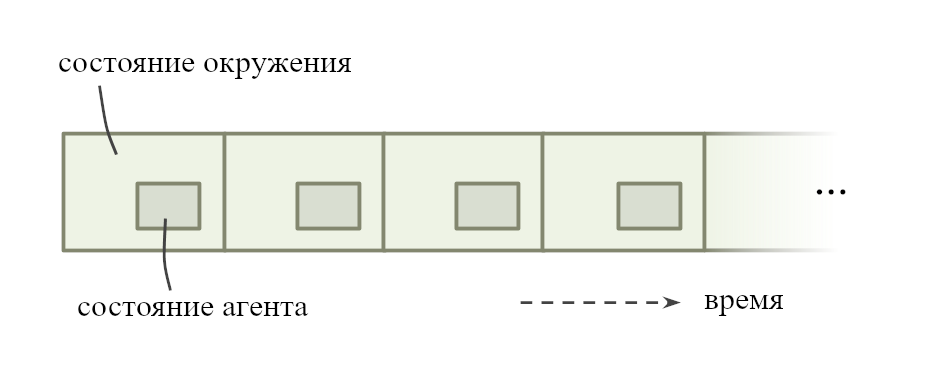

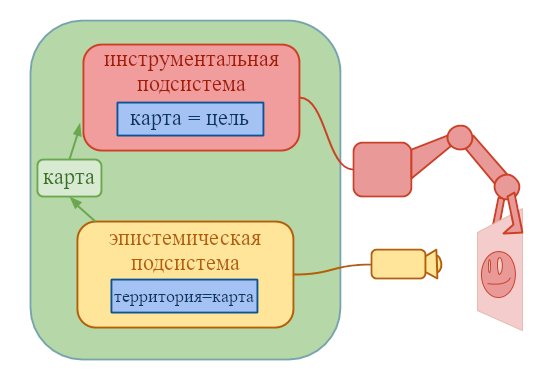

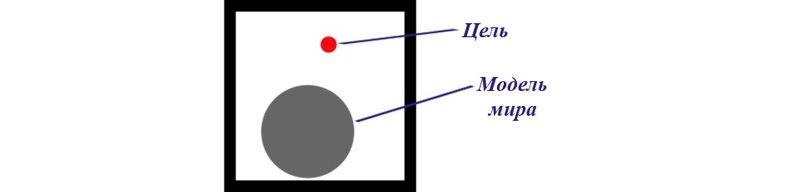

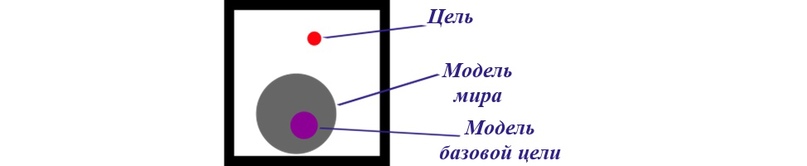

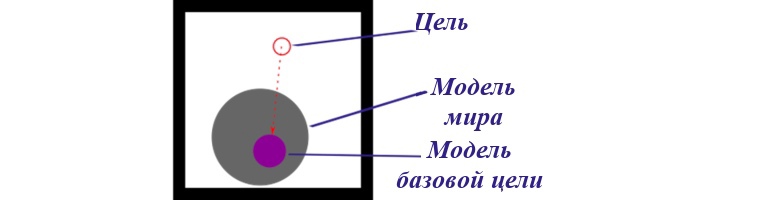

ИИ – это физическая система, и где-то внутри себя он конструирует предсказания о том, как вселенная будет выглядеть, если он совершит то или иное действие. Какие-то другие части системы сравнивают эти последствия и исполняют действия, ведущие к тем вариантам, которые текущая система высоко оценивает. Если агент изначально запрограммирован исполнять планы, ведущие к вселенной, в которой, как он предсказывает, будет исцелён рак, то он будет модифицировать свои цели только если предскажет, что это приведёт к исцелению рака.

Независимо от их уровня интеллекта и независимо от ваших намерений, компьютеры делают в точности то, на что вы их запрограммировали. Если вы запрограммировали необычайно умную машину выполнять планы, которые, как она предсказывает, приведут к будущему, где рак исцелён, то может оказаться, что кратчайший найденный ею путь включает похищение людей для экспериментирования (а если вы попытаетесь её изменить, то она будет сопротивляться, потому что это замедлит процесс).

Нет никакой искры сочувствия, которая автоматически заставляет достаточно способные компьютеры уважать других разумных существ. Если вы хотите сочувствия, вам нужно его запрограммировать.

Почему это важно: Многие крупнейшие мировые проблемы было бы куда легче решить с помощью суперинтеллекта – но для получения этих преимуществ нужно большее, чем просто развитие способностей ИИ. Вы получите систему, которая делает то, что вам нужно, только если вы знаете, как запрограммировать её принимать ваши намерения во внимание и выполнять планы, которые им соответствуют.

Дальнейшее чтение: Бостром, «Воля сверхразума»

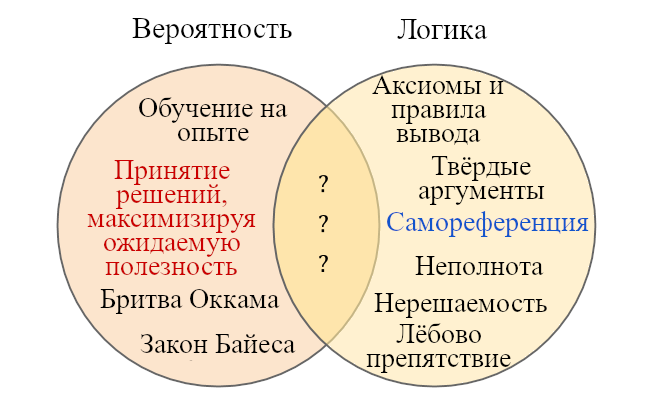

Довод о важности искусственного интеллекта опирается на эти четыре утверждения: универсальная способность к рассуждениям существует; если мы построим машины с такой способностью, они смогут быть намного умнее людей; если они будут намного умнее людей, у них будет огромное влияние; и это влияние по умолчанию не будет положительным.

В настоящее время на улучшение способностей ИИ тратятся миллиарды долларов и тысячи человеко-лет. Однако на безопасность ИИ направлено сравнительно мало усилий. Искусственный суперинтеллект может возникнуть в ближайшие десятилетия, и почти наверняка, если не случится какой-то катастрофы, возникнет в ближайший век или два. Суперинтеллектуальные системы окажут либо огромное положительное, либо огромное отрицательное влияние. И только от нас зависит, положительное это влияние будет или отрицательное.

Задача соответствия ракет и цели

Нижеследующее — вымышленный диалог, основанный на Соответствие ИИ — Почему это сложно и с чего начать.

(Где-то в не-очень-то-близком из миров по соседству, где наука пошла совершенно другим путём…)

Альфонсо: Привет, Бет. Я заметил, что в последнее время многие предполагают, что «космосамолёты» будут использоваться для бомбёжки городов, или что в них вселятся злобные духи, населяющие небесные сферы, так что они пойдут против инженеров, их создавших.

Я довольно скептически отношусь к этим предположениям. На самом деле, я даже немного скептически и по поводу того, что в ближайшее столетие самолёты смогут достигнуть высоты стратосферных метеозондов. Но я понимаю, что твой институт хочет обратить внимание на потенциальные проблемы злобных или опасных космосамолётов, и вы думаете, что это важно уже сегодня.

Бет: Мы бы в Институте Математики Нацеленного Ракетостроения так не сказали… 1

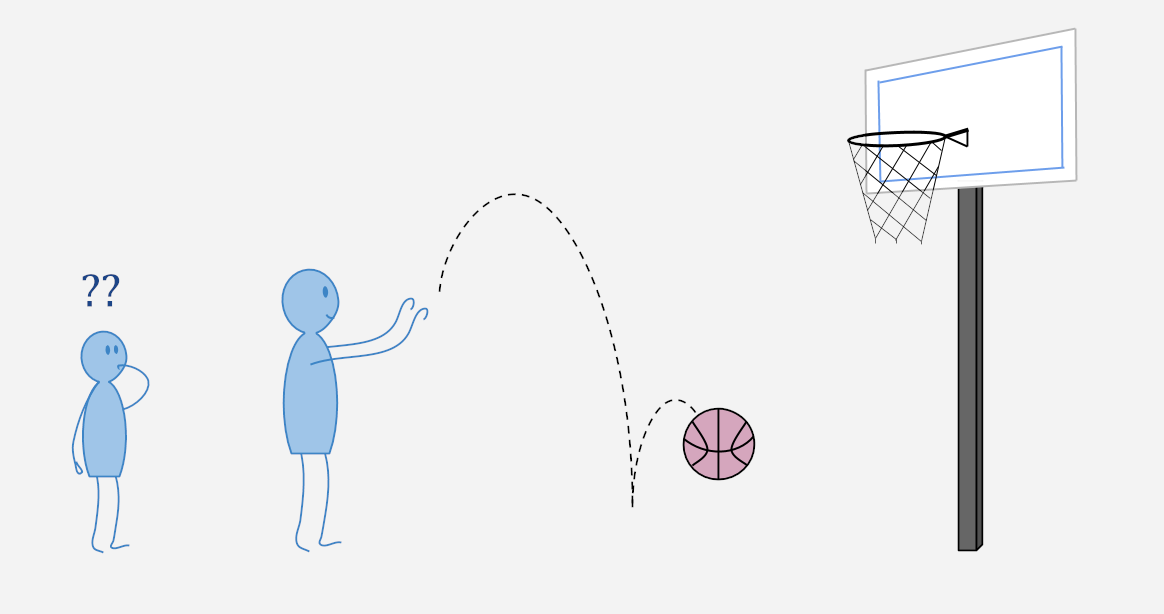

Новостные статьи фокусируются на проблеме злобных небесных духов, мы же считаем, что настоящая проблема совершенно иная. Мы беспокоимся о сложной задаче, которую современное ракетостроение в основном игнорирует. Мы беспокоимся, что если направить ракету на Луну на небе и нажать кнопку запуска, то ракета может не прилететь к Луне.

Альфонсо: Я понимаю: очень важно спроектировать стабилизаторы для полёта при сильном ветре. Это важное направление исследований в области безопасности космосамолётов, кто-то должен это делать.

Но если бы вы работали над этим, я бы ожидал, что вы будете плотно сотрудничать с инженерами-самолётостроителями, чтобы протестировать свои проекты стабилизаторов и показать, что они действительно полезны.

Бет: Аэродинамика — важная часть проектирования любой безопасной ракеты, и мы очень рады, что ракетостроители работают над этим и всерьёз воспринимают безопасность. Однако, это не тот класс задач, на котором сосредоточены мы в MIRI.

Альфонсо: О чём в таком случае вы беспокоитесь? Вы боитесь, что космосамолёты могут быть разработаны злонамеренными людьми?

Бет: Нет, сейчас нас волнуют совсем другие сценарии провала. И в первую очередь то, что прямо сейчас вообще никто не может сказать, куда надо направить нос ракеты, чтобы она попала на Луну, или, на самом деле, вообще в любое заранее определённое место назначения. Мы считаем, что не важно — запустит ли ракету Google, правительство США, или Северная Корея. Это не влияет на вероятность успешной посадки на Луну, потому что сейчас никто не знает, как направить хоть какую-нибудь ракету хоть куда-нибудь.

Альфонсо: Не уверен, что понял.

Бет: Нас тревожит, что даже если прицелиться ракетой в Луну так, чтобы нос ракеты точно указывал на Луну на небе, ракета не полетит к Луне. Мы не знаем, как выглядит реалистичный путь от Земли к Луне, но мы подозреваем, что он будет не очень прямым и, возможно при этом направлять нос ракеты на Луну вовсе не нужно. Мы думаем, самое важное, что надо делать сейчас — это развивать наше понимание ракетных траекторий, пока у нас не будет лучшее, более глубокое понимание того, что мы начали называть «соответствием ракеты и цели»2. Есть много других задач в области безопасности, но задача соответствия ракеты и цели, вероятно, займёт больше всего времени, так что она самая срочная.

Альфонсо: Хммм, мне кажется, это слишком сильное заявление. У вас есть причина думать, что между нами и Луной есть невидимый барьер, в который может врезаться космосамолёт? Или вы говорите, что между нами и Луной может быть очень-очень ветрено, сильнее, чем тут на Земле? Может и стоит приготовиться к таким вариантам, но они не выглядят вероятными.

Бет: Мы вовсе не думаем, что невидимые барьеры особенно вероятны. И мы не думаем, что в небесных просторах будет очень ветрено — даже наоборот. Проблема в том, что мы пока не знаем, как построить хоть какую-нибудь траекторию, по которой реалистично добраться от Земли до Луны.

Альфонсо: Конечно, мы не можем построить конкретную траекторию: ветер и погода слишком непредсказуемы. Но твоё заявление всё ещё выглядит слишком сильным. Просто направь космосамолёт на Луну, взлети и пусть пилот поправляет курс по необходимости. С чего бы этому не работать? Ты можешь доказать, что космосамолёт, нацеленный на Луну, не доберётся до неё?

Бет: Мы не считаем, что можем что-то в таком роде доказать. Частично проблема в том, что реалистичные вычисления в этой области невероятно сложны, принимая во внимание трение об атмосферу и движение других небесных тел и всё такое. Мы пытались решать радикально упрощённые задачи, с предположениями в духе отсутствия атмосферы или ракет, двигающихся по идеально прямым линиям. Даже такие нереалистичные вычисления сильно свидетельствуют в пользу того, что в гораздо более сложном реальном мире просто нацеливание носа ракеты на Луну не приведёт к тому, что ракета в итоге прилетит на Луну. В смысле, то, что реальный мир сложнее, точно не делает добирание до Луны проще.

Альфонсо: Хорошо, давай я посмотрю на эту вашу работу над «пониманием»…

Гм. Судя по тому, что я читал про математику, которой вы пытаетесь заниматься, я бы сказал, что не понимаю, как она относится к Луне. Не должна ли помощь пилотам космосамолётов в точном нацеливании на Луну включать в себя наблюдение её через телескопы и изучение, как именно Луна выглядит, чтобы пилоты могли найти наилучший ландшафт для посадки?

Бет: Мы считаем, что нашего уровня понимания не хватает, чтобы заниматься детальной картой Луны прямо сейчас. Нам пока ещё рано выбирать кратер, на который стоит нацеливаться. Сейчас мы не можем нацелиться вообще ни на что. Это больше похоже на «понять, как математически рассуждать об искривлённых ракетных траекториях вместо ракет, двигающихся по прямым линиям». Даже пока что не о реалистично искривлённых траекториях, мы просто пытаемся хоть как-то пройти дальше прямых…

Альфонсо: Но самолёты на Земле движутся по кривым всё время, ведь искривлена сама Земля. Естественно ожидать, что будущие космосамолёты тоже будут способны двигаться по кривым. Если вы беспокоитесь, что они будут двигаться только по прямым и промахнутся мимо Луны, и вы хотите посоветовать ракетным инженерам строить ракеты, двигающиеся по кривым, то, кажется, время можно потратить и с большей пользой.

Бет: Ты пытаешься провести слишком прямую связь между математикой, над которой мы работаем прямо сейчас, и реальными возможными будущими проектами ракет. Дело вовсе не в том, что текущие идеи ракет почти правильные, и нам просто надо решить ещё одну-две задачи, чтобы они заработали. Концептуальный разрыв, отделяющий человечество от решения задачи нацеливания ракет гораздо-гораздо шире.

Прямо сейчас по поводу ракетных траекторий у всех полное замешательство. Мы пытаемся понять хотя бы чуть больше, чем ничего. Именно это сейчас первоочередная задача. Не надо бежать к ракетным инженерам и советовать им строить ракеты согласно тому, что написано в наших математических статьях. Пока мы даже не разобрались в совершенно базовых вопросах вроде того, почему Земля не падает на Солнце.

Альфонсо: Я не думаю, что Земля может столкнуться с Солнцем в обозримом будущем. Солнце стабильно вращается вокруг Земли уже довольно долго.

Бет: Я не говорю, что наша цель связана с риском падения Земли на Солнце. Я говорю, что раз современные знания человечество не позволяют отвечать на вопросы вроде «Почему Земля не падает на Солнце?», то мы не очень много знаем про небесную механику и не в состоянии направить ракету через небесные просторы так, чтобы она совершила мягкую посадку на Луну.

Например, чтобы лучше разобраться в небесной механике, мы сейчас работаем над задачей «повторяющихся позиций». Она о том, как выстрелить ядром из пушки так, чтобы ядро облетало Землю снова и снова, повторяя свои изначальные координаты, как повторяется плитка на полу…

Альфонсо: Я полистал вашу работу по этой теме. Должен сказать, мне не понятно, как стрельба из пушек связана с полётом на Луну. Откровенно говоря, это звучит подозрительно похоже на старые-добрые космические полёты, которые, как всем известно, не работают. Может, Жюль Верн думал, что можно путешествовать вокруг Земли, выстрелив капсулой из пушки, но современные исследования высоко летающих самолётов полностью отбросили такой вариант. То, что вы упоминаете стрельбу из пушек, наталкивает меня на мысль, что вы не поспеваете за инновациями в самолётостроении за последний век, и поэтому ваши проекты космосамолётов будут совершенно нереалистичными.

Бет: Мы знаем, что ракетами на самом деле не будут выстреливать из пушек. Правда-правда. Мы прекрасно осведомлены о причинах того, почему нельзя достичь скорости убегания, выстрелив чем-то из современной пушки. Я уже написала несколько цепочек статей, в которых я описала, почему космических полётов на основе стрельбе из пушек не получится.

Альфонсо: Но твоя текущая работа вся про то, как выстрелить чем-то из пушки так, чтобы оно облетало Землю снова и снова. Как это связано с любыми реалистичными советами, которые можно было бы дать пилоту космосамолёта о том, как долететь до Луны?

Бет: Опять же, ты пытаешься слишком напрямую связать математику, которой мы занимаемся сейчас и непосредственные советы будущим инженерам.

Мы думаем, что если мы сможем найти угол и изначальную скорость, такие, что выстрел из идеальной пушки на идеальной сферической Земле без атмосферы идеальным ядром с этой скоростью и углом приведёт к тому, что ядро займёт то, что мы называем «стабильной орбитой», и не упадёт, то… мы, может быть, поймём что-то по-настоящему фундаментальное и важное о небесной механике.

Или нет! Сложно знать заранее, какие вопросы важны, и какие исследования оправдаются. Всё, что можно сделать, это определить следующую выглядящую поддающейся трактовке задачу, которая вызывает у тебя замешательство, и попробовать найти решение и надеяться, что замешательство уменьшится.

Альфонсо: Ты говоришь о том, что ядро упадёт, как о проблеме, и о том, как ты хочешь избежать этого и заставить ядро летать вечно, правильно? Но настоящие космосамолёты изначально не будут направлены обратно на Землю, а большинство обычных самолётов вполне успешно не падают. Так что мне кажется, что этот сценарий «выстреливания из пушки и падения», которого вы пытаетесь избежать в этой вашей «задаче повторяющихся позиций» — просто не тот вид провала, о котором должны будут беспокоиться реальные проектировщики космосамолётов.

Бет: Мы не беспокоимся о реальных ракетах, выпускаемых из пушек и падающих. Мы не поэтому работаем над задачей повторяющихся позиций. В некотором роде ты чересчур оптимистичен по поводу того, какая часть теории соответствия ракет и цели уже построена! Мы не настолько близки к пониманию того, как нацеливать ракеты, чтобы проекты, о которых говорят сейчас, могли сработать, если бы мы только решили определённый набор оставшихся сложностей вроде «как не позволить ракете упасть». Тебе нужно перейти на мета-уровень, чтобы понять, прогресса какого вида мы добиваемся.

Мы работаем над задачей повторяющихся позиций потому, что мы думаем, что способность выстрелить ядром с определённой мгновенной скоростью так, чтобы оно заняло стабильную орбиту… это такая задача, которую кто-то, кто реально может запустить ракету по конкретной кривой, которая закончится мягкой посадкой на Луну, мог бы решить с лёгкостью. Так что нас тревожит то, что мы её не можем решить. Если мы разберёмся, как решить эту гораздо более простую чётко поставленную задачу повторяющихся позиций с воображаемыми ядрами на идеально-сферической Земле без атмосферы, которую гораздо проще анализировать, чем полёт на Луну, то, может быть, сделаем ещё один шаг к тому, чтобы когда-нибудь стать такими людьми, которые могут спланировать полёт на Луну.

Альфонсо: Если вы не считаете космические пушки в духе Жюля Верна перспективными, то я не понимаю, почему вы продолжаете говорить именно про пушки.

Бет: Потому что уже разработано много сложных математических методов для нацеливания пушек. Люди целились из пушек и проводили траектории ядер с шестнадцатого века. Преимущество этой существующей математики позволяет нам точно сказать, где упадёт идеальное ядро, выпущенное из идеальной пушки в каком-то направлении. Если мы попробуем говорить о ракетах с реалистично изменяющимся ускорением, то мы не сможем даже доказать, что ракета не будет летать вокруг Земли по идеальному квадрату, потому что реалистичные изменения ускорения и реалистичное трение о воздух делают любые точные высказывания невозможными. Нашего текущего понимания не хватает.

Альфонсо: Хорошо, другой вопрос в том же духе. Зачем MIRI финансирует работу по сложению кучи крохотных векторов? Я вообще не вижу, как это связано с ракетами, это выглядит как какая-то странная сторонняя задача из абстрактной математики.

Бет: Это связано с тем… в наших исследованиях мы несколько раз натыкались на задачу перехода от функции изменяющегося во времени ускорения к функции изменяющегося со временем положения. Эта задача становилась камнем преткновения несколько раз, так что мы начали попытки явно проанализировать её отдельно. Поскольку она про чистую математику, не двигающихся дискретно точек, мы назвали её задачей «логической недискретности». Эту задачу можно, например, изучать, пытаясь сложить кучу маленьких меняющихся векторов в один большой вектор. Потом мы рассуждаем о том, как сумма меняется всё медленнее и медленнее, приближаясь к пределу, если вектора становятся всё меньше и меньше, но складываем мы их всё больше и больше… По крайней мере, это один из подходов.

Альфонсо: Мне просто трудно представить, как люди в будущих ракетных космосамолётах смотрят в иллюминаторы и «О нет, у нас недостаточно маленьких векторов, чтобы скорректировать курс! Если бы только был способ сложить побольше ещё меньших векторов!». Я ожидаю, что будущие вычислительные машины будут делать это достаточно хорошо.

Бет: Ты опять слишком напрямую связываешь работу, которой мы заняты сейчас, и применения для будущих проектов ракет. Мы не думаем, будто спроектированная ракета почти что будет работать, но пилот не сможет сложить много крохотных векторов достаточно быстро, так что нам нужен алгоритм побыстрее, и тогда ракета попадёт на Луну. Это фундаментальная математическая работа, которая, как мы считаем, может помочь с основными концепциями, необходимыми для понимания небесных траекторий. Когда мы пытаемся провести траекторию вплоть до мягкой посадки на движущуюся Луну, мы чувствуем себя в замешательстве и тупике. Мы думаем, часть замешательства происходит из нашей неспособности перейти от функций ускорения к функциям положения, так что так мы и пытаемся его разрешить.

Альфонсо: Это подозрительно похоже на задачу откуда-то из философии математики. Не думаю, что можно продвинуться в проектировании космосамолётов, занимаясь философией. Область философии — застойная трясина. Некоторые философы всё ещё верят, что полёт на Луну невозможен. Они говорят, что небесный план фундаментально отделён от земного и потому недосягаем, что откровенно глупо. Проектирование космосамолётов — инженерная проблема, и продвигаются в ней инженеры.

Бет: Я согласна, что проектированием ракет занимаются инженеры, а не философы. Также я разделяю часть твоего огорчения по поводу философии в целом. Именно поэтому мы занимаемся хорошо определёнными математическими вопросами, которые скорее всего имеют настоящие ответы. Например, вопросом о том, как выстрелить пушечным ядром на идеально сферической планете без атмосферы так, чтобы оно вышло на стабильную орбиту.

Для этого часто нужен новый математический аппарат. К примеру, для задачи логической недискретности мы разработали методы для перехода от изменяющихся во времени ускорений к изменяющихся во времени положениям. Ты, если хочешь, можешь называть разработку нового математического аппарата «философией» — но тогда помни, что это совсем другой вид философии, чем «спекулятивные предположения о небесных и земных планах».

Альфонсо: Итак, с точки зрения общественного блага, что хорошего произойдёт, если вы решите эту задачу про логическую недискретность?

Бет: В общих чертах: мы больше не будем настолько в замешательстве, наши исследования не будут в тупике, а человечество может когда-нибудь и доберётся до Луны. Если попытаться сказать это менее размыто — хотя без знания конкретного решения это тяжело — мы сможем научиться говорить о всё более реалистичных ракетных траекториях, потому что у нас будет математика, которая не ломается сразу же, как только мы перестаём предполагать, что ракеты двигаются по прямым. Наша математика сможет рассуждать о точных кривых, вместо последовательностей аппроксимирующих отрезков.

Альфонсо: Точная кривая, которой следует ракета? Это приводит к главной проблеме, которую я вижу в вашем проекте. Я просто не верю, что будущие ракеты можно будет анализировать с абсолютной идеальной точностью и посылать её на Луну по заранее точно проведённой траектории без нужды поправлять её по дороге. Это выглядит для меня так, будто математики, не имеющие понятия о том, как работает реальный мир, хотят, чтобы всё было идеально вычисляемым. Посмотри, как Венера двигается по небу; она обычно движется в одном направлении, но иногда становится ретроградной и двигается в другую сторону. Иногда по дороге нам придётся просто рулить.

Бет: Когда я говорила про точные кривые, я подразумевала не совсем это… Смотри, я соглашусь, что даже если мы решим логическую недискретность, бесполезно будет пытаться заранее предсказать точные траектории со всеми ветрами, которые встретит ракета на своём пути. Отмечу, впрочем, что когда ракета поднимется достаточно высоко, всё может стать спокойнее и предсказуемее…

Альфонсо: Почему?

Бет: Давай пока не будем этого касаться, раз мы и так согласны, что положение ракеты сложно предсказать точно в атмосферной части её траектории, из-за ветров и подобного. И да, если нельзя точно предсказать раннюю траекторию, то нельзя точно предсказать и позднюю траекторию. Так что мы вовсе не предлагаем спроектировать ракету так идеально, чтобы можно было просто направить её с абсолютно точным углом и обойтись без пилота. Цель ракетной математики не в том, чтобы заранее предсказать точное положение ракеты в каждую микросекунду.

Альфонсо: Тогда зачем вы так одержимы чистой математикой, которая слишком проста, чтобы описать большой сложный реальный мир, где иногда идёт дождь?

Бет: Это правда, что настоящая ракета — не простое уравнение на доске. Это правда, что многие аспекты формы и внутреннего устройства настоящей ракеты не будут иметь компактного математического описания. Мы в MIRI пытаемся создать не математику для всех ракетостроителей на все времена, а математику, которую мы будем использовать прямо сейчас (как мы надеемся).

Чтобы с каждым шагом понимать нашу область всё лучше и лучше, нам нужно говорить об идеях, последствия которых можно определить достаточно точно. Это нужно, чтобы у людей был общий контекст для анализа сценариев. Нам нужно достаточно точности, чтобы кто-нибудь мог сказать: «В сценарии X, я думаю, Y приведёт к Z», а кто-то мог ответить: «Нет, в сценарии X, Y на самом деле приведёт к W», а первый мог ответить: «Чёрт, ты прав. Что ж, подумаем, как изменить Y, чтобы он всё же приводил к Z?».

Если же попытаться сделать что-то реалистично сложное на текущей стадии исследований, получится просто пустая болтовня. Когда у кого-то есть огромная схема с шестерёнками и рулями, которая якобы является проектом ракеты, а мы пытаемся объяснить, почему ракета, направленная на Луну, не обязательно прилетит на Луну, нам просто отвечают: «О, моя ракета обязательно прилетит». Идеи подобных изобретателей так размыты, и гибки, и недоопределены, что никто не может доказать им, что они неправы. Становится невозможно добавить хоть что-то к общему знанию.

Наша цель — постепенно создавать коллекции инструментов и идей, с помощью которых можно будет обсуждать траектории формально. Некоторые ключевые инструменты формализации и анализа интуитивно-правдоподобных траекторий ещё не выражены в чистой математике. Пока мы можем с этим жить. Мы всё ещё пытаемся найти способы математически чётко отобразить столько ключевых идей, сколько сможем. Не потому, что математика такая изящная и престижная, а для того, чтобы продвинуть споры о ракетах дальше, чем «А я говорю, да!» и «А я говорю, нет!».

Альфонсо: Мне всё ещё кажется, что вы пытаетесь спрятаться в тепле и комфорте строгих математических обоснований там, где они просто невозможны. Мы не можем совершенно строго математически доказать, что наши космосамолёты точно доберутся до Луны и ничего не пойдёт не так. Так что не стоит делать вид, что математика позволит нам получить абсолютную гарантию касательно космосамолётов.

Бет: Поверь мне, у меня точно не будет полной уверенности в результате вне зависимости от того, какую математику разработают в MIRI. Да, конечно, никакое физическое высказывание нельзя доказать математически, и нельзя назначить вероятность 1 любому эмпирическому утверждению.

Альфонсо: Но ты говоришь о доказательстве теорем — типа того, что ядро будет бесконечно летать кругами вокруг Земли.

Бет: Доказательство теоремы о траектории ракеты не даст нам достаточно комфортную уверенность в том, где она в итоге окажется. Но если доказать теорему, которая заявляет, что запущенная в идеальном вакууме ракета прилетит на Луну, то может быть, что если присоединить к ней какие-нибудь маневровые двигатели, то она долетит до Луны и в реальности. С вероятностью не в 100%, но выше нуля.

Суть нашей работы не в том, чтобы довести текущие идеи о нацеливании ракеты от 99% до 100% вероятности успеха. Она в том, чтобы превзойти текущий шанс успеха в приблизительно 0%.

Альфонсо: Ноль процентов?!

Бет: С точностью до правила Кромвеля, да, ноль процентов. Если направить нос ракеты на Луну и запустить её, она не прилетит на Луну.

Альфонсо: Если прямое нацеливание на Луну не работает, то вряд ли будущие инженеры космосамолётов будут на самом деле настолько глупы, что это не поймут. Они отследят текущее движение Луны по небу и прицелятся в ту часть неба, где Луна будет в день, когда космосамолёт пролетит расстояние до Луны. Меня тревожит, что вы так долго обсуждаете эту проблему и не рассмотрели такую очевидную идею.

Бет: Мы давно уже её рассмотрели и вполне уверены, что это не приведёт нас на Луну.

Альфонсо: Что если мы добавим стабилизаторы, чтобы ракета двигалась по более искривлённой траектории? Можешь доказать, что никакая версия ракеты из этого класса не долетит до Луны, сколько бы мы не старались?

Бет: Можешь набросать траекторию, по которой, с твоей точки зрения, полетит ракета?

Альфонсо: Она полетит от Земли к Луне.

Бет: А можно поподробнее?

Альфонсо: Нет, потому что в реальном мире всегда есть меняющаяся скорость ветра, а у нас нет бесконечного топлива, а космосамолёты не двигаются по идеально прямым линиям.

Бет: Можешь набросать траекторию, которой, как ты думаешь, будет следовать упрощённая версия твоей ракеты, чтобы мы могли понять, каких допущений требует твоя идея?

Альфонсо: Я просто не верю в общую методологию, которую ты предлагаешь для проектирования космосамолётов. Мы устанавливаем стабилизаторы, рулим, пока летим и держим курс на Луну. Если мы сбиваемся с курса, мы его поправляем.

Бет: Вообще-то мы несколько беспокоимся, что обычные стабилизаторы могут перестать работать, когда ракета поднялась слишком высоко. И получится, что оказавшись в небесных просторах, курс поправить уже нельзя. То есть, если курс уже хороший, то ты сможешь его поправить, но если всё пошло совсем не так, то нельзя просто развернуться как на самолёте.

Альфонсо: Почему нельзя?

Бет: Этот вопрос тоже можно обсудить. Однако для того, чтобы дискуссия продвигалась вперёд, всё равно нужно разбирать последовательность шагов, которые ракета пройдёт по пути к Луне. Даже если это упрощённая модель ракеты, которой можно рулить. Полёты ракет в небесах — это необычайно сложная область — даже если сравнивать с строительством ракет на Земле, что само по себе очень тяжело, потому что обычно они просто взрываются. Не то, что бы всё должно было быть изящным и математичным. Однако это очень сложная задача. И предложения вроде «давайте следовать за Луной в небе», если они не основываются на достаточно надёжных идеях, эквивалентны запуску ракеты в пустоту случайным образом.

Если кажется, что ты точно не уверен, сработает ли твоя идея, но она может сработать, и при этом твоя идея состоит из множества правдоподобно звучащих деталей, и, кажется, ни у кого не получается по-настоящему убедительно объяснить тебе, почему эта идея не сработает, то, на самом деле, шансы, что твоя идея приведёт ракету на Луну, примерно равны нулю.

Если кажется, что идея достаточно надёжно обоснована и полностью понятно, если кажется, что она определённо должна успешно довести ракету до Луны, когда всё пойдёт хорошо, тогда, может быть, в лучшем случае, мы можем быть субъективно уверены в успехе на 85%, или около того.

Альфонсо: То есть неуверенность автоматически означает провал? Если честно, звучит параноидально.

Бет: Идея, которую я стараюсь донести, это что-то вроде: «Если ты можешь строго рассуждать о том, почему ракета в принципе должна работать как надо, то это может на самом деле сработать, но если у тебя что-то меньшее, то это определённо не сработает в реальном мире».

Я не прошу тебя дать мне абсолютное математическое доказательство эмпирического успеха. Скорее набросок того, как упрощённая версия твоей ракеты может двигаться, достаточно определённый, чтобы ты не мог потом просто сказать «О, я имел ввиду вовсе не это» каждый раз, когда кто-то пытается понять, что она на самом деле делает, или указать на возможные причины провала.

Это не надуманное требование, отсекающее вообще любые идеи. Это нижняя планка, которую необходимо преодолеть, чтобы привнести что-то новое в эту область. И если проект ракеты не соответствует даже этой концептуальной планке, то шансы такой ракеты на мягкую посадку на Луну примерно равны нулю.

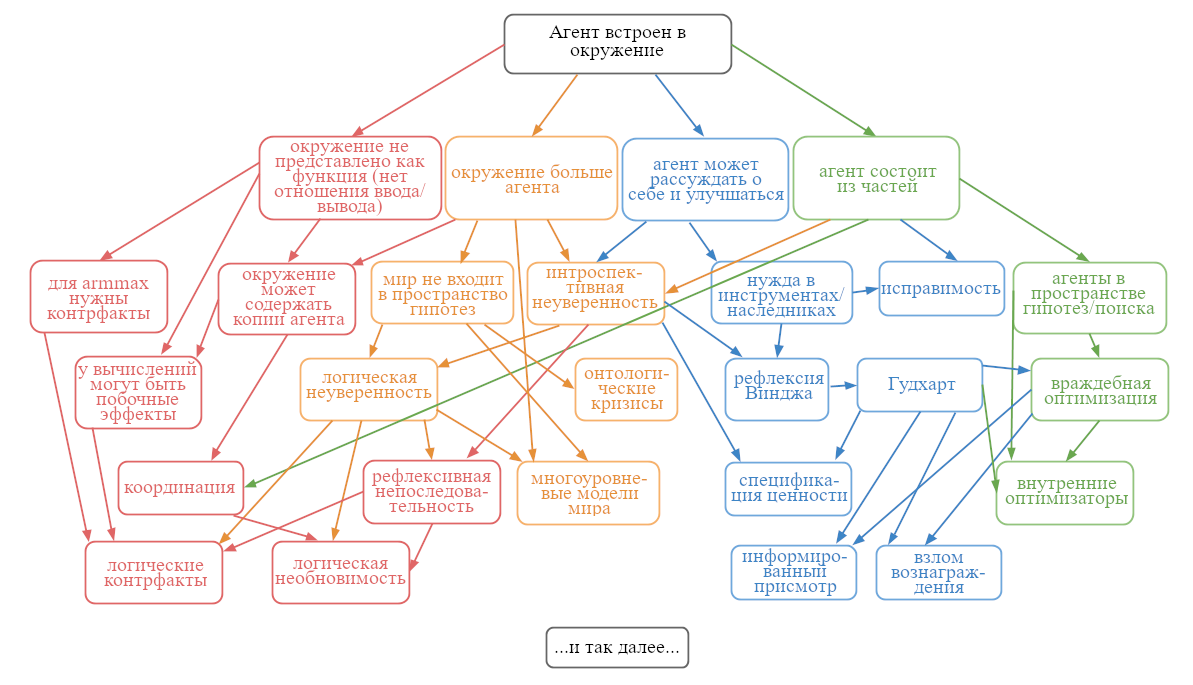

Руководство по исследованиям в области соответствия ИИ

Это руководство написано командой MIRI в первую очередь для групп MIRIx, однако советы отсюда могут оказаться полезны и другим людям, работающим над проблемой соответствия ИИ1 нашим целям.

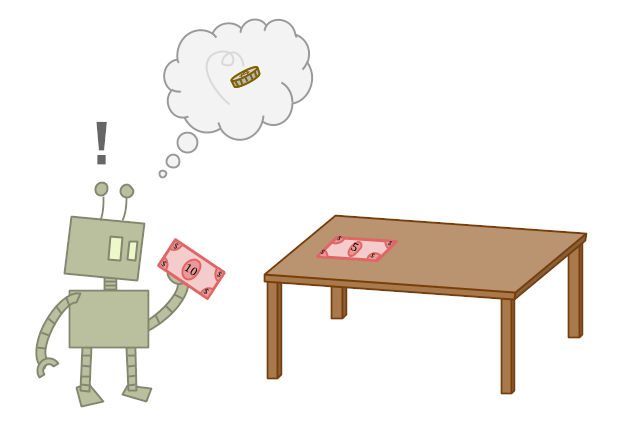

Введение I. Теория принятия решений

Привет! Возможно, вы обратили внимание, что вы читаете некий текст.

Из этого факта следуют некоторые выводы. Например, зачем вы читаете этот текст? Закончите ли вы чтение? Какие решения вы примете? Что вы сделаете дальше?

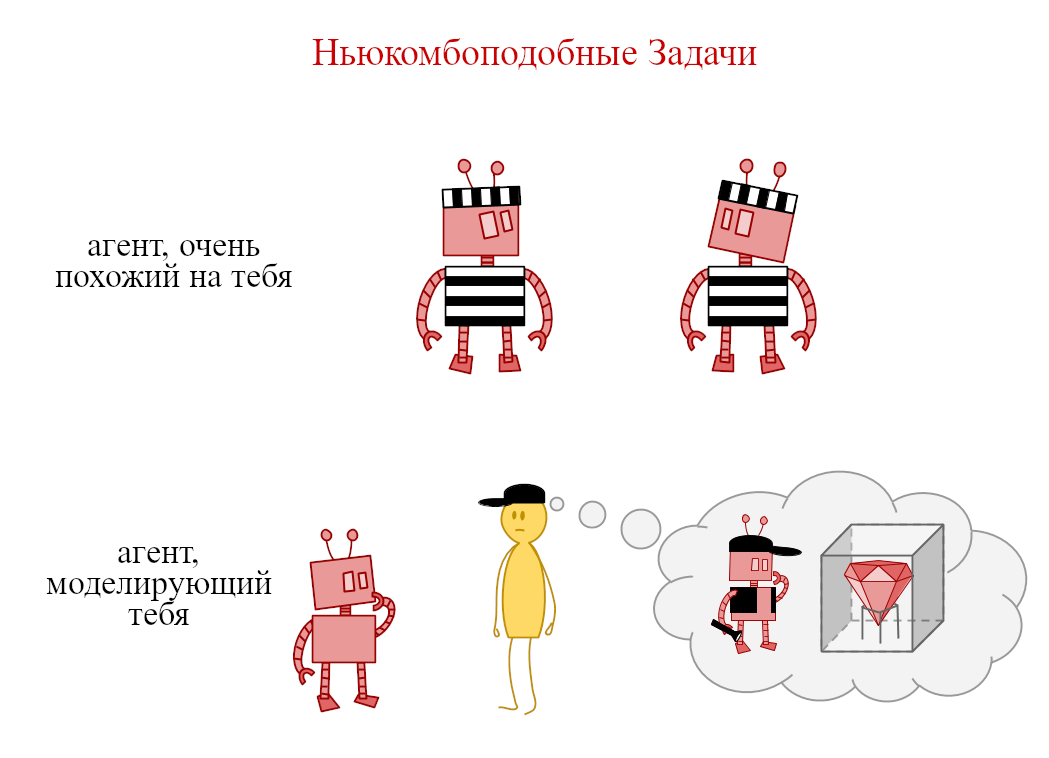

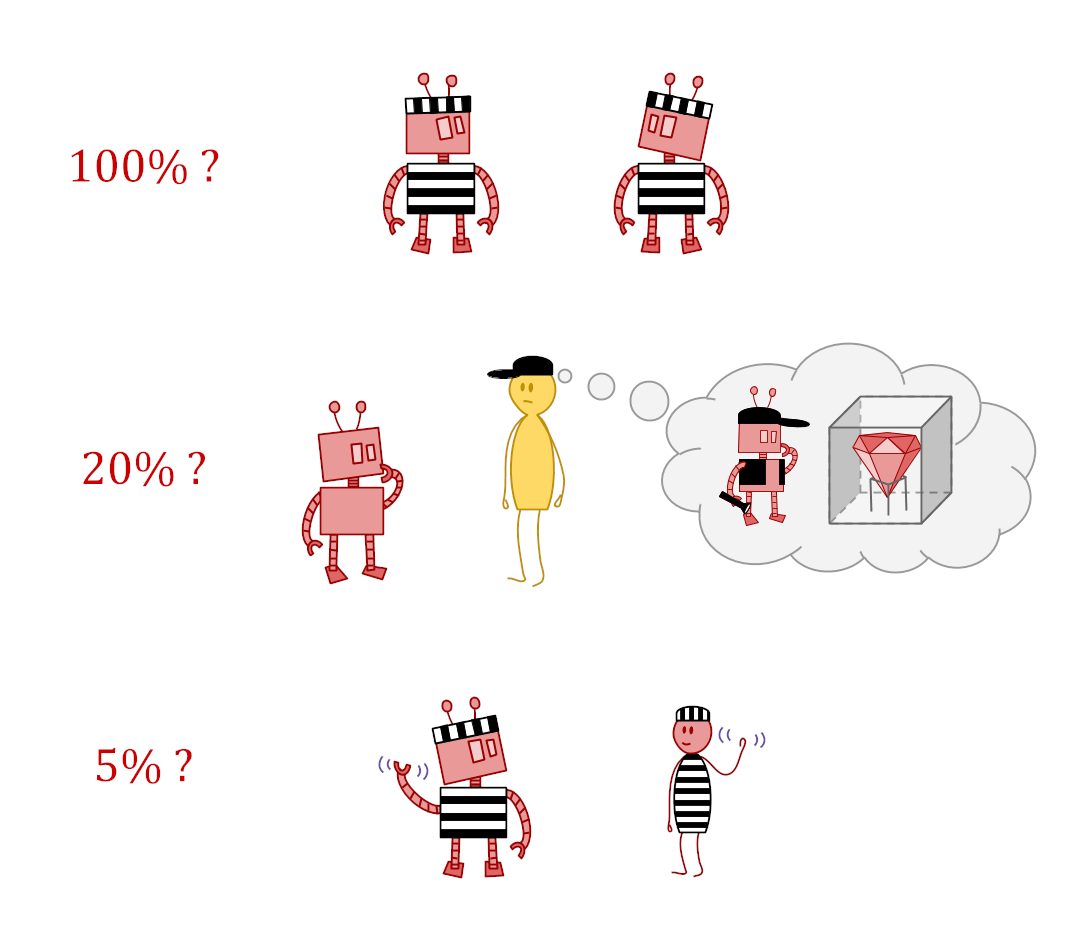

Независимо от того, какое решение вы примете, учтите, что, скорее всего, десятки или даже сотни людей, достаточно похожие на вас и находящиеся в схожих условиях, скорее всего примут примерно такие же решения.

Поэтому мы рекомендуем при размышлении над ближайшими решениями задаться вопросом: «Если все агенты, похожие на меня, будут действовать одинаково, какая их политика приведёт к максимальному благу и как эта политика рекомендует поступить в моём случае?» Речь идёт скорее не о попытке решить за всех агентов, достаточно похожих на вас (что может заставить вас принять неверное решение из чувства вины или из ощущения, что на вас давят), а о чём-то вроде «если бы я руководил всеми агентами из моего референтного класса, как бы я относился к кому-то в этом классе, если бы он обладал именно моими особенностями?»

Если эти рассуждения помогут вам продолжить чтение — прекрасно. Если они приведут к тому, что вы создадите группу MIRIx — ещё лучше. Тем временем, мы продолжим, считая, что этот документ читают лишь люди, которые оправданно ожидают, что он окажется им чем-то полезен.

Введение II. Площадь поверхности

Представьте, что вам нужно передвинуть железный куб со стороной в один метр. Поскольку такой куб весит примерно 8 тонн, а среднестатистический человек может поднять примерно 50 килограмм, наивные подсчёты сообщают, что нам понадобится примерно 160 друзей, которые захотят нам помочь.

Однако, конечно же, вокруг метрового куба поместятся лишь примерно 10 человек максимум. Совершенно не важно, есть ли у вас теоретически силы, чтобы его сдвинуть, если вы не можете эффективно приложить эти силы. У задачи есть ограничение: площадь поверхности.

Группы MIRIx — один из лучших способов увеличить «площадь поверхности» для людей, размышляющих и работающих над технической проблемой соответствия ИИ. Указ «десять человек, которые оказались ближайшими к металлическому кубу — единственные, кому разрешается думать над этой задачей» был бы плохой идеей. И точно также мы не хотим, чтобы MIRI оказался узким местом или авторитетом в вопросах, как следует рассуждать и что нужно делать в вопросах внедрённой агентности2 и смежных областях.

Мы надеемся, что вы и другие люди, похожие на вас, на самом деле решат эту задачу, а не будут просто следовать указаниям или читать написанное кем-то другим. Этот текст создан, чтобы поддержать тех, кому интересно самому совершить прорыв.

Вы и ваши исследования

Нам часто задают вопрос: «Даже летняя стажировка, кажется, слишком коротка, чтобы всерьёз продвинуться в решении настоящей задачи. Как кто-нибудь может всерьёз что-то исследовать за одну встречу?»

На эту тему можно выразиться в стиле Зенона: вы не продвинетесь в своих исследованиях и за миллион лет, если не можете продвинуться в них за пять минут. Очень легко попасть в ловушку (явного или неявного) представления исследований как чего-то вроде: «сначала изучаем всё, что нужно изучить, а затем пытаемся раздвинуть границы и внести свой вклад».

Проблема такого представления (с нашей точки зрения) в том, что она подталкивает людей в сторону поглощения информации как некоего необходимого условия для понимания, а не как необходимого инструмента. (Помните, что именно вы оптимизируете во время своей работы!)

Всегда будет существовать ещё какой-нибудь материал, который стоит изучить. Сложно предсказать заранее, сколько именно вам нужно знать, чтобы получить право на собственные мысли и взгляд. И легко пасть жертвой синдрома Даннинга-Крюгера или синдрома самозванца, а также начать излишне полагаться на существующие авторитеты.

Вместо этого мы рекомендуем выбросить вопрос авторитетов из головы. Просто следуйте за рассуждениями, которые кажутся живыми и интересными. Не думайте об исследованиях как о процессе «сначала изучаем, потом вносим свой вклад». Сосредоточьтесь на собственном понимании задачи, и пусть ваши вопросы сами определяют, какие статьи вам нужно прочитать и какие доказательства изучить.

Такой подход к исследованиям решает вопрос: «Что можно осмысленного сделать за день?» Кажется очень сложно достичь существенного прогресса, если вы меряте себя какой-то объективной внешней меркой. Но гораздо проще, если вас ведёт вперёд ваш собственный вкус.

Никакая процедура не подойдёт абсолютно всем. Однако далее приведены шаги, которые вы можете попробовать самостоятельно или в группе (например, MIRIx), чтобы попрактиковаться в описанном выше исследованиях, питаемых любопытством.

- Выпишите список вопросов.

- Если вы работаете в группе, прикрепите этот список туда, где все смогут его видеть, например, на доску.

- Сосредоточьтесь на том, о чём вы не знаете, как это делать, или по поводу чего испытываете замешательство.

- Если в голову не приходят никакие вопросы, скажите себе (или группе): «Прекрасно, я должен понять, как решить всю эту задачу целиком» и попробуйте описывать подробности решения, пока не застопоритесь.

- Совершенно нормально включать в список не только вопросы, но и идеи, которые вы хотите развить, или мысли, критику которых вы хотите получить от группы.

- Выберите один из вопросов, чтобы сконцентрироваться на нём. Выбирайте то, что кажется наиболее интересным.

- Если в вашей группе больше трёх человек, подумайте о том, чтобы разделиться. Каждая подгруппа может обсуждать как свой собственный вопрос, так и независимо обсуждать один общий. Определитесь, через какое время вы опять соберётесь вместе и обсудите, к чему вы пришли.

- Рекомендуем сохранять полный перечень вопросов где-то на виду, чтобы он напоминал вам о других интересных темах, на которые можно переключиться, если мысли по поводу первого выбранного вопроса иссякнут.

- Сформулируйте собственное любопытство. Чего хочется достичь? Чего, по-вашему, можно достичь?

- При работе в группе обычно человеку, который предлагает тему, стоит рассказать что-нибудь о ней, чтобы все одинаково понимали, о чём речь.

- При работе самостоятельно рекомендуем с самого начала записывать всё, что, по-вашему, вы знаете и что, по-вашему, вы не знаете. Записывайте всё, что имеет хоть какое-то отношение к делу. На этом этапе не беспокойтесь, истинны ли ваши утверждения и осмысленны ли ваши вопросы. Затем пересмотрите написанное и придайте ему смысл. Переформулируйте ваши утверждения до тех пор, пока они не превратятся во что-то определённо либо истинное, либо ложное.

- Продолжайте формулировать и уточнять.

- Продолжайте формулировать вспомогательные вопросы и делать утверждения (возможно, истинные, возможно, нет), двигаясь от расплывчатых к чётким и формальным.

- Обращайте внимание, когда ваше любопытство растёт, а когда падает. Избегайте стремления завершить работу из чувства долга. Ищите самые простейшие случаи, по поводу которых вы до сих пор испытываете замешательство, и пробуйте работать с ними.

- Позвольте себе отвлекаться. Позвольте себе играть. Пока все участники дискуссии сохраняют любопытство и вовлечённость, это способствует лучшему пониманию. Не бойтесь залипнуть в какой-нибудь «неважный» математический вопрос, не исключено, что они окажутся более важными, чем кажется на первый взгляд. Вы развиваете свои способности, пусть даже это не помогает напрямую решать вашу задачу.

- Если вы получили конкретные математические результаты, в которых есть что-то интересное, или даже конкретный математический вопрос, запишите это. Подробные отчёты в письменном виде помогают не только обмениваться идеями с другими людьми. Они ещё способствуют тому, что вы сами начинаете лучше понимать изучаемый вопрос.

Прогресс в MIRI достигается примерно таким же образом. Наша работа очень сильно отличается от «просто читаем множество статей» и очень сильно отличается от «попытаться сформулировать от начала до конца, что именно нужно сделать в этой области».

Естественная ошибка: считать свою работу попыткой внести вклад в мировое коллективное знание и из-за этого перестать ставить на первое место собственные знания и понимание. На первый взгляд, «просто читать статьи» выглядит, как будто мы ставим собственные знания на первое место, но такой подход часто является следствием неявного убеждения, что какие-то другие люди точно знают, что именно нам нужно знать. Подход же «оптимизировать собственное понимание» порождает быструю обратную связь.

В том, чтобы читать статьи нет ничего самого по себе плохого — даже если вы просто читаете произвольные статьи по соответствующей тематике, чтобы получить общее представление о состоянии дел. Однако вам стоит всегда пытаться представлять, что именно вы знаете или не знаете, как делать, и что именно вам нужно узнать, чтобы решить задачу. Это сложно. Не исключено, что вы уверены, что первые пять идей, которые вы запишете, окажутся неверными. Тем не менее, всё же запишите их и попробуйте заставить их работать. Так вы сможете увидеть, что получится, и понять, что идёт не так.

Мы не хотим, чтобы сотни талантливых людей задавали одни и те же вопросы и принимали один и тот же набор допущений. Нам нужно много исследователей, а не пользователей. С нашей точки зрения, лучший способ стать исследователем — это с самого начала тренироваться независимо мыслить, а не прокачивать навык «сижу и впитываю информацию ради информации».

Поэтому не спрашивайте: «Какие есть открытые вопросы?» Спрашивайте: «Какие вопросы интересуют меня?»

Как начать

Предположим, вы попробовали что-то из написанного выше, вам понравилось и вы хотите перейти к созданию вашей собственной группы MIRIx.

Мы рекомендуем в первую очередь найти ОДНОГО или ДВУХ людей (но не трёх и больше), и попробовать заняться исследованиями пару раз вместе с ними. Ниже будет раздел про социальную динамику, в котором описано, как именно это может выглядеть, но смысл в том, что, вероятно, лучше попробовать отладить атмосферу и рабочий процесс при малом количестве участников. Если вы начнёте с большого количества людей, договариваться о работе группы, скорее всего, будет гораздо сложнее.

Ещё в случае большого количества людей сложно договориться о расписании. Найти время и место, которые устраивали бы всех, становится невозможно, и процесс согласования каждой новой встречи может демотивировать. Составляйте расписание так, чтобы оно подходило основному ядру группы. Какой день недели подходит вам? Как часто вы хотите встречаться? Сколько времени будет длиться встреча? Мы рекомендуем устраивать встречи раз в месяц, раз в неделю или раз в две недели. Длина встречи может варьироваться от часа до целого дня, в зависимости от того, что подходит лично вам.

Когда вы найдёте одного или двух партнёров, с которыми вам действительно комфортно работается, следующий шаг: запланировать и организовать первую большую встречу. «Большая» — означает примерно «от трёх до шести человек». Определённо не «двадцать-тридцать слушателей».

Попытайтесь найти тихое, звукоизолированное место, где можно удобно расположиться, есть на чём писать (в том числе, есть большие маркерные доски на стенах). Часто подобные места есть в университетах и публичных библиотеках, но подойдёт и чья-нибудь гостиная, если вы сможете свести к минимуму количество посторонних вмешательств. Не забудьте запастись чистой бумагой, ручками, планшетами, а также выберите кого-нибудь, кто будет отвечать за еду и питьё.

(Примечание по поводу еды и питья. Люди почти всегда недооценивают важность качества и количества еды и сваливаются к чему-нибудь вроде: «Не знаю, может просто купим чипсы баксов на десять или что-то в этом духе?» Лучше спросите себя: сколько я потратил бы на то, чтобы способность думать для всей группы, общее настроение и удовлетворённость от встречи повысилась бы на 15%? Именно от такой суммы вам стоит отталкиваться (/ попросить у MIRI) при расчёте стоимости еды, особенно на первую встречу. Не покупайте только фаст-фуд. Возможно, на какое-то время он вам даст больше энергии, но вам будет сложнее думать потом. Здоровая еда довольно важна — особенно для длинных встреч. Большая встреча должна включать в себя достаточно серьёзный приём пищи, возможно в ближайшем ресторане. Это также послужит неплохим перерывом.)

На первой большой встрече, возможно, вы захотите выбрать руководителя группы. Это важная часть культуры общего знания — в большинстве случаев руководитель ничем не отличается от остальных, однако крайне полезно, чтобы в наличии был человек, у которого есть моральное право устанавливать повестку, выбирать между различными хорошими вариантами и не давать группе отвлекаться. Возможно, вы также захотите выбрать секретаря/ответственного за записи, или, быть может, координатора, отвечающего за выбор места и еду, или создать какие-нибудь ещё должности (впрочем, этим можно заняться и на следующих встречах).

Затем вы, вероятно, захотите смоделировать процесс, который уже работает для вас. Возможно, это означает поделиться списком уже существующих вопросов и посмотреть, какие из них привлекут интерес участников. Возможно, это означает сначала обсудить направление ваших исследованиях в общих чертах, а уж затем перейти к отдельным темам. В любом случае вы захотите перейти к серьёзным размышлениям, записям, доказательствам и обсуждениям как можно быстрее. Если на встрече присутствует больше четырёх человек, лучше разбиться на подгруппы. Если вы так и поступите, запланируйте, в какое время вы соберётесь обратно для обсуждения.

Постарайтесь не забывать о перерывах. Когда работа вовсю кипит, вспоминать о них сложно, поэтому стоит их запланировать заранее. Короткий перерыв каждый час, во время которого люди встают и выходят прогуляться, очень помогает.

Имеет смысл сохранять общедоступный список (на маркерной доске или в общем гугл-документе) накопившихся вопросов, необходимых понятий и многообещающих идей. Из такого списка легко почерпнуть новую тему, если разговор зашёл в тупик.

Возможная структура встречи, включающая в себя советы выше и исследовательскую процедуру из предыдущего раздела:

- В начале каждой встречи все перечисляют свои вопросы/темы/замешательства, и всё это записывается в общедоступный список.

- Собравшиеся определяют наиболее интересные им вопросы и делятся на подгруппы.

- Подгруппы обсуждают свои вопросы 45 минут.

- Все собираются вместе и несколько минут обсуждают, что происходило в подгруппах.

- Перерыв на 5-10 минут, в зависимости от того, как все себя чувствуют.

- На доску добавляются новые вопросы/идеи, и процесс повторяется нужное число раз. (Если вы планируете несколько циклов, также запланируйте длинный перерыв на то, чтобы поесть.)

В конце встречи запланируйте следующую. Возможно, вы уже сошлись на каком-то расписании, которое работает для ядра группы, но всё же его стоит подстраивать на случай праздников, отпусков и других обстоятельств. Важно, чтобы все согласились с временем следующей встречи, даже если у вас уже твёрдо устоявшееся расписание. Постарайтесь с самого начала принять, что вы не пытаетесь добиться постоянного всеобщего присутствия: будет лучше, если люди поймут, что иногда пропускать встречи — это нормально (при условии, что на каждую встречу приходит примерно 70-90% участников). Если один или два человека не могут прийти две встречи подряд, постарайтесь узнать у них подробности, чтобы, возможно, подстроиться под их расписание при планировании третьей.

Модели социальной динамики

В этой секции собраны несколько довольно «сырых» моделей о том, как получается хорошая исследовательская группа или вообще хорошее совместное предприятие. Здесь стоит обращать внимание скорее на общий дух, а не на букву. Также стоит попытаться определить ваши собственные ценности, а не считать, что вы обязаны следовать именно этим.

Передатчики и приёмники

Во время наших исследований мы обнаружили, что разговоры, в которых в основном участвует лишь два человека, идут лучше. Мы не хотим сказать, что не должно быть разговоров, в которых участвует три и более человека, однако в течении любого пятиминутного отрезка времени, разговаривать в основном должны только два человека — тот, кто пытается донести какую-то информацию, и тот, кто пытается её понять.(При этом именно понимание стоит оптимизировать в первую очередь. Обсуждение какой-либо темы на таком уровне, что четыре или пять разных людей способны отслеживать все нюансы, обычно приносит меньше пользы)

Назовём эти две роли «передатчик» и «приёмник». Вы можете передавать:

- Конкретный вопрос или замешательство.

- Модель или цепочку рассуждений.

- Кусок важной информации, которая необходима, чтобы по-настоящему понимать идущее обсуждение.

«Приёмник» может:

- Пересказывать «передатчику» то, что тот сказал, другими словами. Это позволяет «передатчику» понимать, успешно ли передана информация.

- Делать заметки на маркерной доске или рисовать диаграммы, и просить «передатчика» проверять, что получается. Делайте это настолько строго, насколько возможно. Пытайтесь записывать утверждения на языке логики и превращать нестрогие аргументы в доказательства. Для подобного понимания информации хорошо подходит теория типов. Даже просто точно записывать типы данных, соответствующие обсуждаемым сущностям, может быть очень полезно.

- Подавлять желание прервать «передатчика», когда тот говорит что-то уже понятное. Для этого подходит следующий приём: попытайтесь придумать как минимум две интерпретации и спросите, как их различить.

- Придерживаться гипотезы, что «передатчик» пытается рассказать о чём-то интересном. Избегайте режима «критика», который приведёт к тому, что «передатчику» будет сложнее думать и выражать свои мысли. Даже если в том, что явно сказал «передатчик» зияет дыра, ваша задача — помочь ему найти ту крупицу интуиции, которая позволит продолжить рассуждение и по-возможности превратить его в полезную идею.

- Обращать внимание на замешательство и говорить, если что-то в вашей картине не стыкуется. Задавать уточняющие вопросы. Ваша задача как «приёмника» не просто кивать или создавать у «передатчика» чувство, что его понимают. Будьте мягче, когда необходимо, чтобы помочь «передатчику» нащупать то, что он пытается сообщить. Но когда он это нащупал, ваша задача вытащить из него всё в подробностях!

- Если идея «передатчика» выглядит вполне чёткой, «приёмник» может начать искать в ней уязвимые места. Критика неоформившейся идеи часто мешает делу, однако, если речь идёт о ясном осмысленном предложении, критика вполне имеет смысл.

- Искать следствия того, что говорит «передатчик». («А, но тогда получается X!» или «Из этого ведь следует Х?», и так далее.) Это служит как минимум трём целям. Во-первых, это позволяет «передатчику» понять, что вы видите, почему эта идея окажется совершенно потрясающей, если она работает. Ведь вы с её помощью уже делаете что-то полезное. Это стимулирует. Во-вторых, это позволяет понять, успеваете ли вы за мыслью. В-третьих, совершенно абсурдный вывод позволит предположить, что вы зашли куда-то не туда, и стоит вернуться назад, чтобы понять, где ошибка.

- Играть роль доброго тролля - когда у «передатчика» ничего не получается или их вообще нет, потому что ни у кого нет идей. Сыграйте роль Сократа. Задавайте вопросы о вроде бы базовых штуках и попытайтесь показать, что они все не имеют смысла. Или защищайте нелепую точку зрения. (Тролль иногда кажется «передатчиком», но по сути он «приёмник».)

«Передатчик» должен чувствовать, что в попытках выразить свою интуицию, он может делать любые утверждения, в том числе «абсолютно ложные». Попытайтесь создать нормы, где вы можете попросить «приёмников» помочь вам выделить из того, что вы говорите, ядрышко истины, а не уничтожать полуоформившиеся идеи, потому что они наполовину неверны. Не важно, насколько «приёмники» избегают моральных суждений. Нужно, чтобы «передатчик» время от времени мог сказать что-то вроде «всё, что я собираюсь сказать, полностью неверно, но …»

«Передатчик» при этом должен руководствоваться своей интуицией и любопытством. Направлять разговор в наиболее интересное русло, а не пытаться создать хорошее впечатление или развлечь. «Передатчик» не обязан отвечать на вопросы «приёмника», сказать: «прямо сейчас я не хочу об этом думать» — вполне нормально.

Смысл в том, что «приёмник» помогает «передатчику» породить идею. Поэтому именно «передатчик» решает, что в данный момент более важно, а «приёмник» работает усилителем, поставщиком интуиции, а также источником (небольшого) хаоса.

Тем временем, всем остальным присутствующим стоит попробовать себя в роли посредников/переводчиков. Они должны наблюдать одновременно и за «передатчиком», и за «приёмником», и строить модели, что происходит в их диалоге. Где они упускают мысль собеседника? Где они не понимают, что именно хочет узнать собеседник? Может быть, у них срабатывает эффект подтверждения или двойная иллюзия прозрачности? Может, они соглашаются, что какое-то утверждение разумно, не понимая его до конца?

Остальным присутствующим имеет смысл вбрасывать в разговор важные мысли, модели, вопросы (но их вмешательство не должно превышать 10% от всех слов в беседе). Иногда вмешательство приведёт к смене ролей: кто-нибудь из слушателей станет «передатчиком» или «приёмником» или «передатчик» и «приёмник» поменяются местами.

Высокие стандарты

После одной или двух встреч довольно неловко не приглашать кого-то в следующий раз и, тем более, напрямую запрещать придти. Но разрушить всю группу MIRIx из-за чрезмерной застенчивости или неуверенности — ещё хуже.

Явно обозначьте разницу между «добро пожаловать на встречу» и «теперь ты в нашей команде». Позаботьтесь о том, чтобы все знали, кто именно принимает решения. Пусть он/она/они будут не обязаны объяснять своё решение. (Если вы не доверяете чьим-то суждениям без объяснений, этот человек не должен принимать решения.) Доверяйте своей интуиции. Если вам кажется, что некто не сочетается с атмосферой, которую вы хотите создать, не приглашайте его. Подумайте о том, чтобы требовать несколько рекомендаций или устраивать собеседование. Возможно, вам кажется, что это излишне, но исключать людей обычно тяжело, а формальный процесс приёма воспринимается как более справедливый.

Также подумайте, не стоит ли записать в явном виде этические правила или совместные обязательства, под которыми люди будут подписываться, когда они становятся частью команды. Убедитесь, что вы действительно хотите всерьёз поддерживать именно эти стандарты (например, «нужно посещать не меньше половины встреч» или «всё обсуждаемое на встречах не следует разглашать, если явно не сказано об обратном»).

Возрастание требований и вознаграждений

Представьте модель школы боевых искусств. Когда туда приходит новичок, инструкторы его мало о чём просят (например, ударь цель ногой с громким криком). Вскоре за это его вознаграждают поясом и некоторым статусом.

После этого требования возрастают. Ученика с жёлтым поясом уже могут попросить пару минут наблюдать за учениками с белыми и поправлять их. В ответ те должны кланяться и говорить «сэр» или «мэм».

Дальше требования растут дальше и соответственно растёт награда. Такой цикл поощряет обязательства и вложения: человек постоянно получает доказательства: «если я что-то вложил, то я что-то получу, и чем больше я вложил, тем больше я получу». В какой-то момент ученик получает чёрный пояс и его могут пригласить в штат инструкторов или предложить основать свой филиал школы.

В большинстве групп и организаций происходит примерно то же самое. Если группа ничего не просит (или просит мало) от своих членов, они не платят ей верностью. Люди вовлекаются в группу в той мере, в которой группа позволяет им рассказывать приятные (или эпические) истории о себе.

Для групп MIRIx это тоже может быть верным. Подумайте, не стоит ли завести небольшие примерно одинаковые задания для большинства новичков (например, прочитать такие-то и такие-то статьи или на третьей встрече сделать десятиминутный доклад на интересную им тему). Попробуйте построить последовательность просьб и вознаграждений дальше (например, на пятой встрече ты будешь управлять повесткой дня и делить всех на группы).

Структура и свободное пространство

Этот пункт связан с предыдущим. Важно уметь уравновешивать в своей группе MIRIx нисходящие и восходящие структуры коммуникации. Если никто не понимает, «как мы тут работаем», новички путаются и им становится неуютно. Вам нужна уже существующая структура, которую люди могут оценить и определить, будет ли им с ней комфортно. Вам нужно, чтобы с самого начала было понятно «на что похожа» ваша группа. Чтобы люди, которым она подойдёт, и люди, которым она не подойдёт, могли точно определить, к какой они категории относятся.

Тем не менее, вряд ли вы хотите, чтобы ваша структура мешала вам развиваться в долгосрочной перспективе. Мастера боевых искусств рано или поздно получают право вносить изменения в собственные тренировки, а также что-то менять при обучении новых учеников. Наверняка вы тоже захотите когда-нибудь получить что-то от своей группы MIRIx. Обычно люди огорчаются, когда не могут удовлетворить какие-нибудь свои потребности. Если ваша структура будет мешать им развиваться, они уйдут искать другое место, чтобы расти.

Социальные нормы

Нормальным и принятым становится то, против чего никто не возражает. Если какое-то поведение вам не нравится и выхотите снизить его количество на встречах, вам нужно не только самим возражать против него, но также открыто и публично поддерживать других, кто тоже против него возражает. Задача группы - сделать так, чтобы каждый, кто соблюдает правила / пытается поступать правильно, никогда не оставался один против тех, кто правила нарушает.

Заранее обдумайте и публично озвучьте вопросы вида «когда можно перебивать» или «насколько допустимы значительные отступления от темы». Создавайте культуру разногласия, но стройте её на основе вежливости и поддержки, чтобы разногласия делали группу сильнее, а не превращались в перепалки. Защищайте структуры принятия решений, которые вы придумали. Будьте последовательны в вопросах полномочий и в том, когда решения становятся окончательными.

Прочие мысли и вопросы

- Чтобы встречи не становились однообразными, пытайтесь чередовать различные темы и активности. Читайте статьи, устраивайте презентации, проводите дискуссии, пишите формальные доказательства и статьи, и так далее. Постарайтесь, чтобы чтению или обсуждению уже существующего материала уделялось не более 50% ваших встреч. (В идеале — не более 33%.)

- Подумайте о том, чтобы строить долгосрочные планы вида: шесть месяцев (или год) встречи посвящаются работе над какой-то конкретной областью вопросов, чтобы группа смогла построить какой-то комплекс знаний.

- Однако, если вы строите долгосрочные планы, предусмотрите возможность от них отклоняться. Например, пусть каждая третья встреча будет посвящена чему-то, не связанному с основной изучаемой областью.

- Подумайте о том, чтобы вести протоколы встреч и сохранять их на будущее. Так вы сможете оценить свою деятельность по прошествии нескольких месяцев или года. Подумайте над идеей, стоит ли пробегаться по протоколу предыдущей встречи в начале следующей.

- В конце встречи назначьте кого-нибудь, чтобы он собрал список вопросов, над которыми люди хотели бы подумать, и разослал их всем. Сюда же можно добавить мысли для обсуждения на следующих встречах. Подумайте о том, чтобы заранее определяться, кто будет вести следующую встречу, чтобы он мог подготовиться.

- Убедитесь, что у вас есть актуальная контактная информация для всех полноценных членов команды и прочих заинтересованных лиц. Подумайте заранее о способах коммуникации: будете вы пользоваться е-мэйл рассылками, группами в фейсбуке или чем-то ещё.

- Подумайте о том, как вы хотите взаимодействовать с другими группами MIRIx: хотите ли вы обмениваться с ними протоколами, вопросами, или, например, посылать кого-нибудь на встречу в другую группу или принимать людей из других групп у себя. Если вы хотите взаимодействовать, предпринимайте для этого активные действия. Помните: вы такой же представитель класса, как и другие. Если вы хотите что-то делать, но ничего не делаете, вероятно, тоже самое можно будет сказать и об остальных.

- Подумайте, хотите ли вы проводить какие-то мероприятия для обычных людей или для потенциальных новобранцев (например, на факультетах математики или информатики). Подумайте, хотите ли вы попробовать более амбициозные проекты, например, устроить летнюю школу, и пригласить людей, у которых есть знания и ресурсы, чтобы не изобретать колесо.

- Если ваша группа MIRIx существует в вузе, постарайтесь подумать над вопросом, как вы будете искать студентов младших курсов, которые займут место старшекурсников, когда те закончат вуз. Если вы не связаны с академической средой, подумайте, откуда вы будете брать новых людей. Заметим, что большой приток новичков редко бывает полезен и создаёт культурные проблемы. Лучше добавлять новых людей по одному или по двое, чтобы они могли привыкнуть к группе и группа к ним.

- Помните, что качество исследований, дискуссий и всей группы MIRIx в целом зависит от действий участников группы и от того, как их действия сочетаются между собой. Позаботьтесь о том, чтобы это понимали все — ваша группа будет настолько хороша, насколько каждый из вас захочет таковой её сделать.

Эпилог

Вы почти дочитали до конца текста! Надеемся, вы в нём встретили какую-то полезную информацию, а также здоровую пищу для размышлений. Перед тем, как вы перейдёте к другим делам, мы советуем потратить секунд 30 на размышления над следующими вопросами:

- Почему мы решили написать этот текст? Что мы ожидали получить, и что подтолкнуло нас выбрать из всех возможностей именно такой формат и содержание?

- Что вас огорчило или не устроило? Чего в этом тексте не хватает? Что мы упустили? Откуда вы узнали о тех вещах, которые мы упустили?

- Какой текст написали бы вы? Как бы вы поняли, что написать такой текст - хорошая идея? Как бы вы определяли, что в нём стоит упомянуть?

- Как, чёрт побери, вообще достигается прогресс?

Счастливой охоты.

— Команда исследователей MIRI.

Дискуссия Нго и Юдковского про сложность задачи согласования

Примечание редактора сайта: Под «согласованием» в заголовке и далее в тексте подразумевается англоязычное «[AI] alignment». В некоторых других статьях на этом сайте этот термин переводился как «соответствие [ИИ целям оператора]». Пока перевод этого термина на русский в сообществе не устоялся.

* * *

Этот пост – первое из серии обсуждений в Discord между Ричардом Нго и Элиезером Юдковским, под модерацией Нейта Соареса. Ричард и Нейт так же резюмировали ход разговора и ответы собеседников в Google Docs, это также добавлено сюда.

В позднейших обсуждениях принимали участие Аджейя Котра, Бет Барнс, Карл Шульман, Холден Карнофски, Яан Таллинн, Пол Кристиано, Роб Бенсингер и Робин Шах.

Это полные записи нескольких созданных MIRI для дискуссий каналов в Discord. Мы пытались как можно меньше редактировать записи сверх исправления опечаток и вводящих в замешательство формулировок, разбивания на параграфы и добавления ссылок. МЫ не редактировали значимое содержание, за исключением имён людей, которые предпочли, чтобы их не упоминали. Мы поменяли порядок некоторых сообщений для ясности и непротиворечивого потока обсуждения (в таких случаях время особо отмечено), и скомбинировали разные логи, когда обсуждение переключалось между каналами.

Предварительные комментарии

[Yudkowsky][8:32] (6 ноября)

(По просьбе Роба, я постараюсь быть кратким, но это экспериментальный формат и некоторые всплывшие проблемы выглядят достаточно важными, чтобы их прокомментировать)

Главным образом в ранней части этого диалога у меня были некоторые уже сформированные гипотезы на тему “Что будет главной точкой несогласия и что мне говорить по этому поводу”, что заставляло меня отклоняться от чистой линии обсуждения, если бы я просто пытался отвечать на вопросы Ричарда. Перечитывая диалог, я заметил, что это выглядит уклончиво, будто я странным образом упускаю суть, не отвечая напрямую на вопросы.

Зачастую ответы даны позднее, по крайней мере, мне так кажется, хотя, может, и не в первой части диалога. Но в целом вышло так, что я пришёл высказать некоторые вещи, а Ричард пришёл задавать вопросы, и получилось небольшое случайное несовпадение. Выглядело бы лучше, если бы, скажем, мы оба сначала выставили свои позиции без знаков вопроса, или если бы я ограничил себя ответами на вопросы Ричарда. (Это не катастрофа, но читателю стоит учитывать это как небольшую неполадку, проявившуюся на ранней стадии экспериментов с этим новым форматом.)

[Yudkowsky][8:32] (6 ноября)

(Подсказано поздними попытками резюмировать диалог. Резюмирование выглядит важным способом распространения для такого большого диалога, и следующая просьба должна быть особо указана, чтобы к ней прислушивались – встроенные в диалог указания не работают.)

Пожалуйста, не резюмируйте этот диалог, говоря “и ГЛАВНАЯ идея Элиезера такая” или “и Элиезер думает, что КЛЮЧЕВОЙ МОМЕНТ в том” или “ОСНОВНОЙ аргумент таков” и.т.д. Мне кажется у всех свои наборы камней преткновения и того, что считается очевидным, и обсуждение с моей стороны сильно меняется в зависимости от них. Когда-то камнями преткновения были Тезис Ортогональности, Инструментальная Конвергенция и возможность суперинтеллекта в принципе; сейчас у большинства связанного с Open Philanthropy народа они уже другие.

Пожалуйста, преобразуйте:

- “Основной ответ Элиезера в том…” -> “Элиезер ответил, что…”

- “Элиезер считает, что ключевой момент в том…” -> “Элиезер в ответ указал, что…”

- “Элиезер считает, что основная проблема в том…” -> “Элиезер ответил, что есть проблема в том…”

- “Главный аргумент Элиезера против этого был…” -> “Элиезер возразил тем…”

- “Элиезер считает, что основной сценарий тут…” -> “В обсуждении в сентябре 2021, Элиезер обрисовал гипотетический сценарий, где…”

Замечу, что преобразованные утверждения говорят о том, что вы наблюдали, тогда как изначальные - это (зачастую неправильные) выводы о том, что я думаю.

(Однако, “различать относительно ненадёжные выводы от более надёжных наблюдений” – не обязательно ключевая идея или главная причина, по которой я этого прошу. Это просто моё замечание – один аргумент, который, я надеюсь, поможет донести больший тезис.)

Обсуждение 5 сентября

Глубокие и поверхностные шаблоны решения задач

[Ngo][11:00]

Всем привет! С нетерпением жду дискуссии.

[Yudkowsky][11:01]

Привет и добро пожаловать. Моё имя Элиезер и я думаю, что согласование ИИ на самом деле довольно невероятно очень сложно. Кажется, некоторые люди так не думают! Это важная проблема, которую нужно как-то решить, надеюсь, мы сегодня это сделаем. (Однако, я хочу сделать перерыв через 90 минут, если это столько продлится и если суточный цикл Нго позволит продолжать после этого.)

[Ngo][11:02]

Перерыв через 90 минут или около того звучит хорошо.

Вот как можно начать? Я согласен, что согласование людьми произвольно мощного ИИ выглядит очень сложной задачей. Одна из причин, по которым я более оптимистичен (или, по крайней мере, не уверен, что нам придётся столкнуться с полноценной очень сложной версией этой задачи) – это то, что с определённого момента ИИ возьмёт на себя большую часть работы.

Когда ты говоришь о том, что согласование сложное, о согласовании каких ИИ ты думаешь?

[Yudkowsky][11:04]

В моей модели Других Людей, зачастую когда они думают, что согласование не должно быть таким уж сложным, они считают, что есть какая-то конкретная штука, которую можно сделать, чтобы согласовать СИИ, и она не очень сложная. И их модель упускает одну из фундаментальных сложностей, из-за которой не получится выполнить (легко или совсем) какой-то шаг их метода. Так что одно из того, что я делаю в обсуждении – это попытаться расковырять, про какой же именно шаг собеседник не понимает, что он сложный. Сказав это, я теперь попробую ответить на твой вопрос.

[Ngo][11:07]

Я не думаю, что уверен в какой-нибудь конкретной штуке, позволяющей согласовать СИИ. Однако я чувствую неуверенность по поводу того, в насколько большом диапазоне возможностей эта задача может оказаться сложной.

И по некоторым важным переменным, кажется, что свидетельства последнего десятка лет склоняют к тому, чтобы посчитать задачу более простой.

[Yudkowsky][11:09]

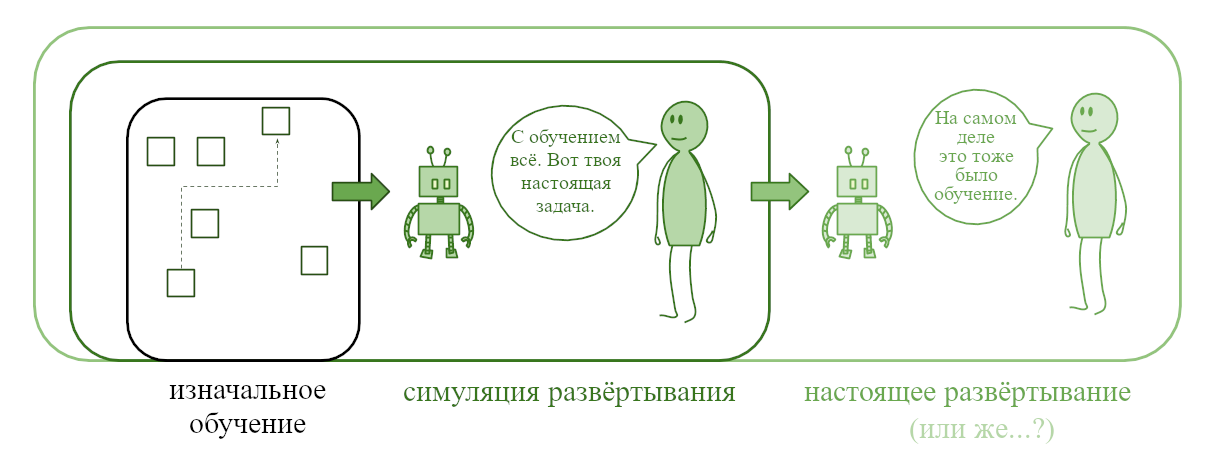

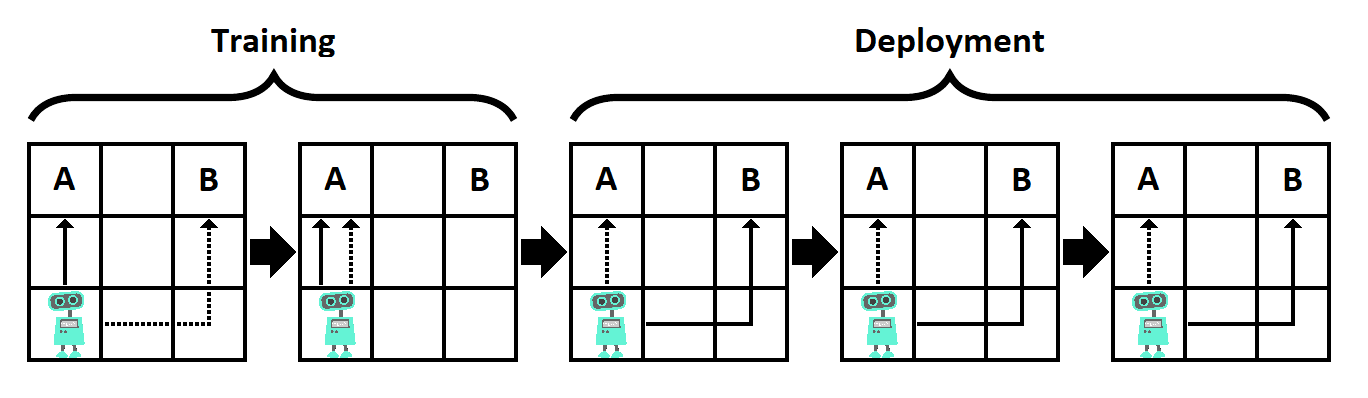

Я думаю, что после того, как станет возможным СИИ вообще и его масштабирование до опасного сверхчеловеческого уровня, будет, в лучшем случае, если будут решены многие другие социальные сложности, период от 3-х месяцев до 2-х лет, когда лишь у нескольких действующих лиц есть СИИ, что означает, что этим действующим лицам будет социально-возможно просто решить не масштабировать его до уровня, на котором он автоматически уничтожает мир.

В течении этого периода, чтобы человечество выжило, кто-то должен произвести некое действие, из-за которого мир не будет уничтожен через 3 месяца или 2 года, когда уже у слишком многих будет доступ к коду СИИ, уничтожающего мир, если повернуть рубильник его интеллекта достаточно сильно. Это требует того, чтобы кто-то из первых действующих лиц, создавших СИИ сделал с помощью него что-то, что предотвратит уничтожение мира. Если бы это не требовало суперинтеллекта, мы могли бы сделать это сейчас, но, насколько мне известно, никакого такого доступного людям действия нет.

Так что мы хотим наименее опасное, наиболее легко согласовываемое действие-при-помощи-СИИ, но при этом достаточно мощное, чтобы предотвратить автоматическое разрушение Земли через 3 месяца или 2 года. Оно должно “опрокинуть игровую доску”, не позволив начаться суицидальной игре. Мы должны согласовать СИИ, который осуществит это ключевое действие, чтобы он мог его осуществить, не убив всех.

Замечу в скобках, ни одно достаточно мощное и доскоопрокидывающее действие не умещается в Окно Овертона политики, или, возможно, даже эффективного альтруизма, что представляет отдельную социальную проблему. Я обычно обхожу эту проблему, приводя пример достаточно мощного для опрокидывания доски, но не самого согласовываемого, потому что оно требует слишком много согласованных частей: создать самовоспроизводящиеся в воздухе наносистемы и использовать их (только), чтобы расплавить все GPU.

Поскольку любой такой наносистеме придётся действовать в целом открытом мире, включающем множество сложных деталей, это потребует очень много работы по согласованию, так что это ключевое действие согласовать сложно, и нам стоит сделать что-то другое. Но другая штука, которая есть у меня в мыслях, точно так же за пределами Окна Овертона. Так что я использую “расплавить все GPU”, чтобы указать на требуемую мощность действия и проблему с Окном Овертона, и то и другое мне кажется приблизительно правильного уровня, но то, что я держу в голове проще согласовать. Таким образом, на “Как ты смеешь?” я всегда могу ответить “Не беспокойся, я не собираюсь на самом деле это делать.”

[Ngo][11:14]

Мы могли бы продолжить обсуждение, обсудив ключевое действие “работать над проблемой согласования быстрее, чем могут люди.”

[Yudkowsky][11:15]

Для меня это звучит как что-то требующее высочайшего уровня согласованности и действующее в очень опасном режиме, так что, если можно сделать это, разумнее сделать какое-нибудь другое ключевое действие, использующее меньший уровень технологии согласования.

[Ngo][11:16]